Вітаю. Вже традиційно для весни - компанія Google проводить щорічну презентацію Google I/O. Цього року, очікувано, вся увага на Keynote прикута до штучного інтелекту. На жаль, деякі деталі і терміни я не дуже розумію, тому їх покрити повністю не зміг. Проте, про них завжди можна знайти окремі статті, а також - окремі презентації впродовж Google I/O 2024.

Вступ

Отож, презентації передував традиційний перфоманс, цього разу - музичний, де (невідомий мені, але відомий світові) музика за допомогою гуглівського інструменту MusicFX створював музику наживо за допомогою ШІ, і стріляв мерчем в людей. Для розуміння вайбу достатньо скріншоту:

Початок

Технічну частину розпочали з нагадувань про досягнення компанії, здебільшого в ШІ.

Під час вступу одразу анонсували AI Overviews, які вже були показані минулого року - як окремі частини в пошуковій видачі зі стиснутою інформацією, поданою в зручному вигляді. Про них ще згадуватимуть впродовж презентації.

Оновлення Google Photos

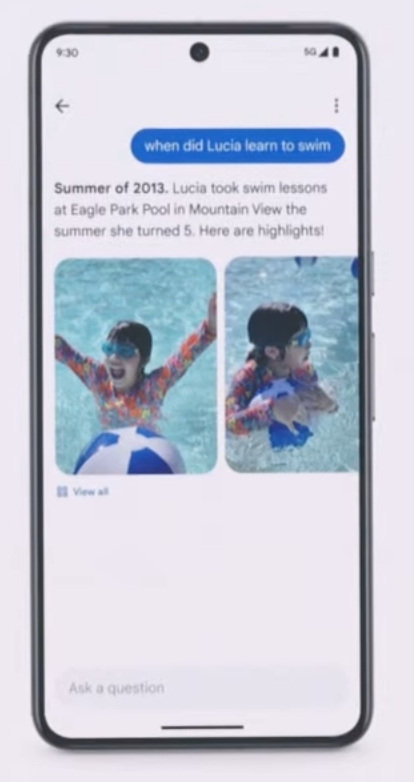

Одразу, прямо напочатку події, показали і розповіли про нововведення в пошуку у Google Photos - а саме можливість пошуку з контекстом по фото.

Тобто тепер, якщо у користувача є набір знімків з людиною чи річчю, про яку потрібно дізнатися якусь інформацію - тобто трансформацію чи розвиток - застосунок може розповісти детально і зі знімками, що і коли відбувалось. Це назвали:

Оновлення Gemini 1.5 Pro

Продовжили анонсом Gemini 1.5 Pro, який тепер доступний для всіх розробників у світі, пропонуючи розпізнавання 35 мов і 1 млн токенів вже.

Про нього будуть згадувати протягом презентації постійно, і це основна тема, власне.

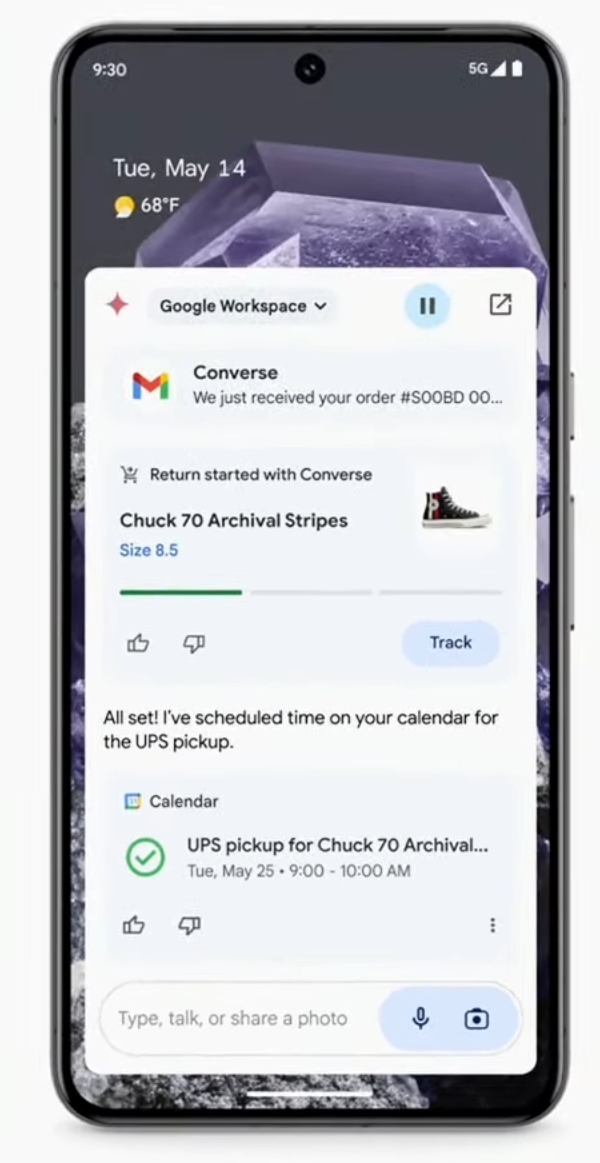

Інтеграція Gemini у Workspace

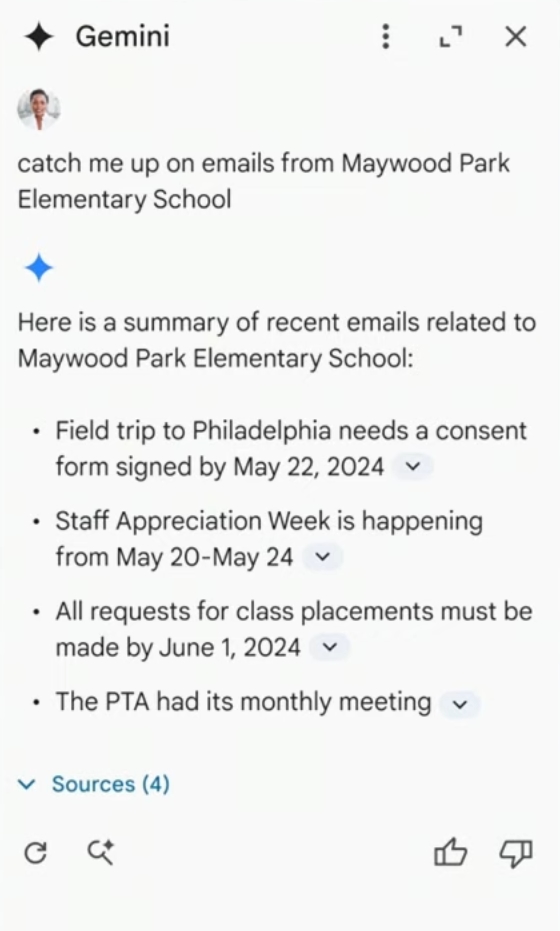

Показали, як інтегрують Gemini в Workspace на прикладі пошти. Подібна демка вже була минулого року, бо я спіймав дуже відчутне дежавю.

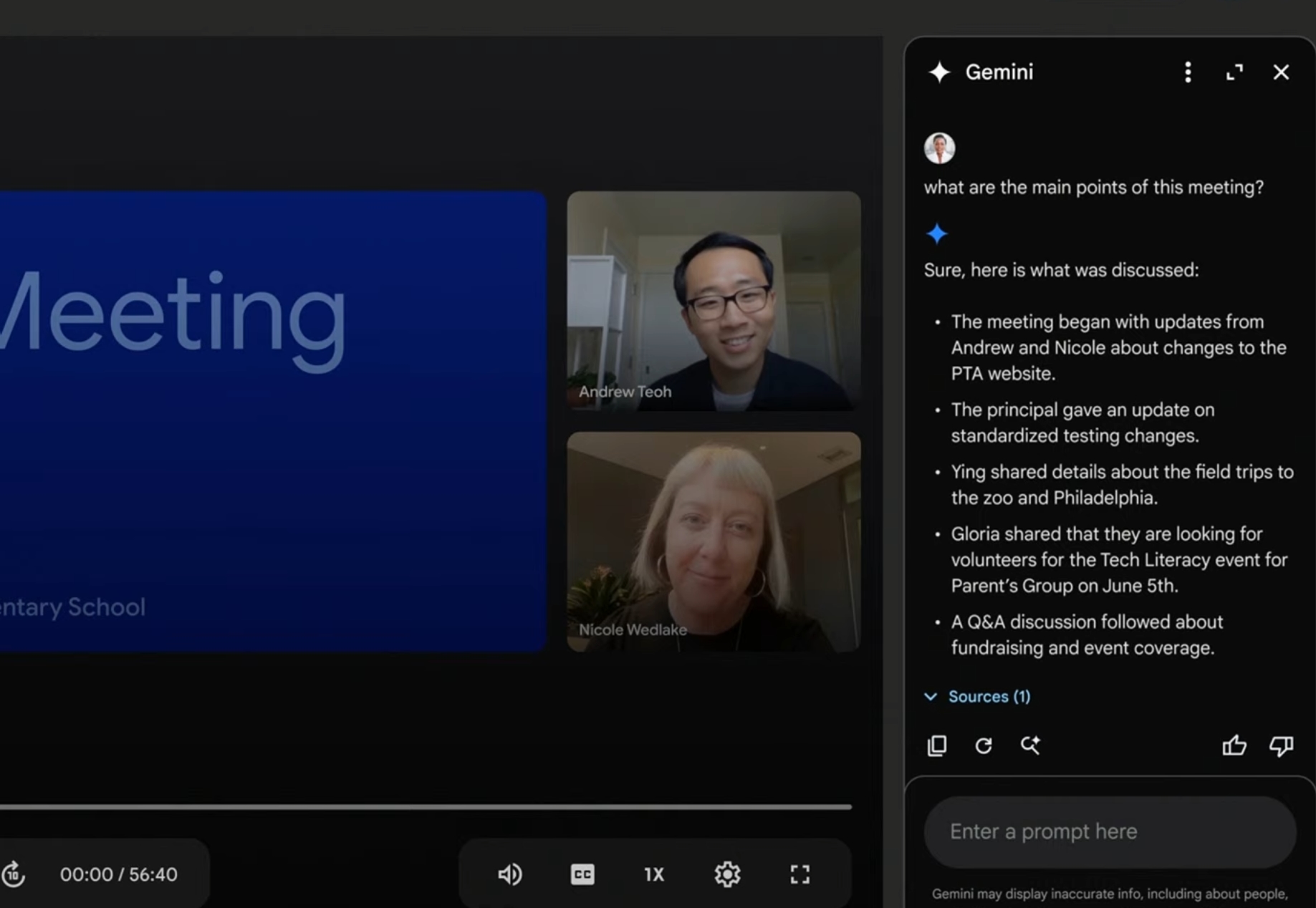

А от чого не було (або ж не запам’яталось) - це допомога прямо під час відеозустрічей від чатбота, який може розуміти контекст під час дзвінка і давати інформацію стосовно нього.

Все це вже доступно в Workspace Labs.

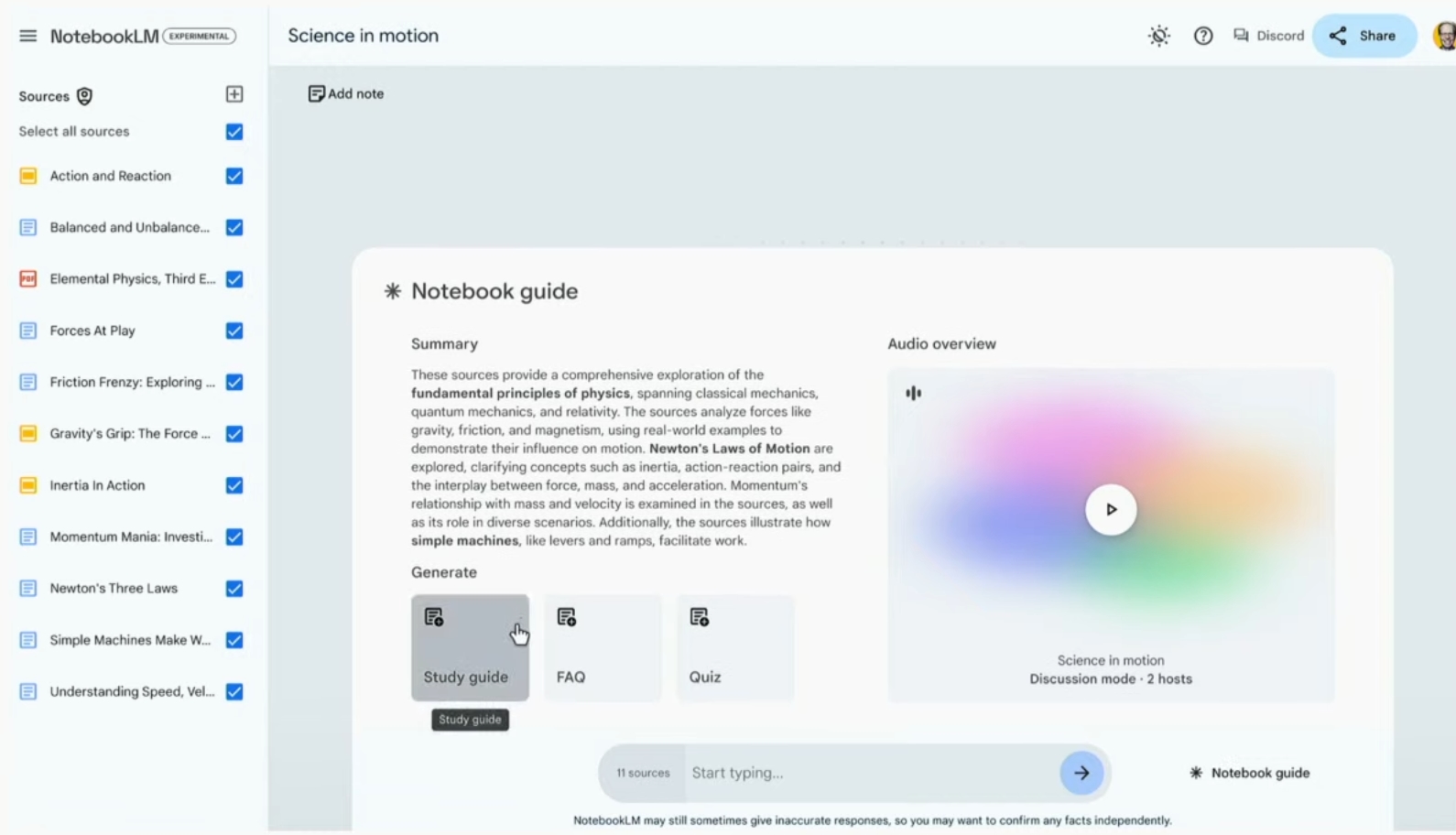

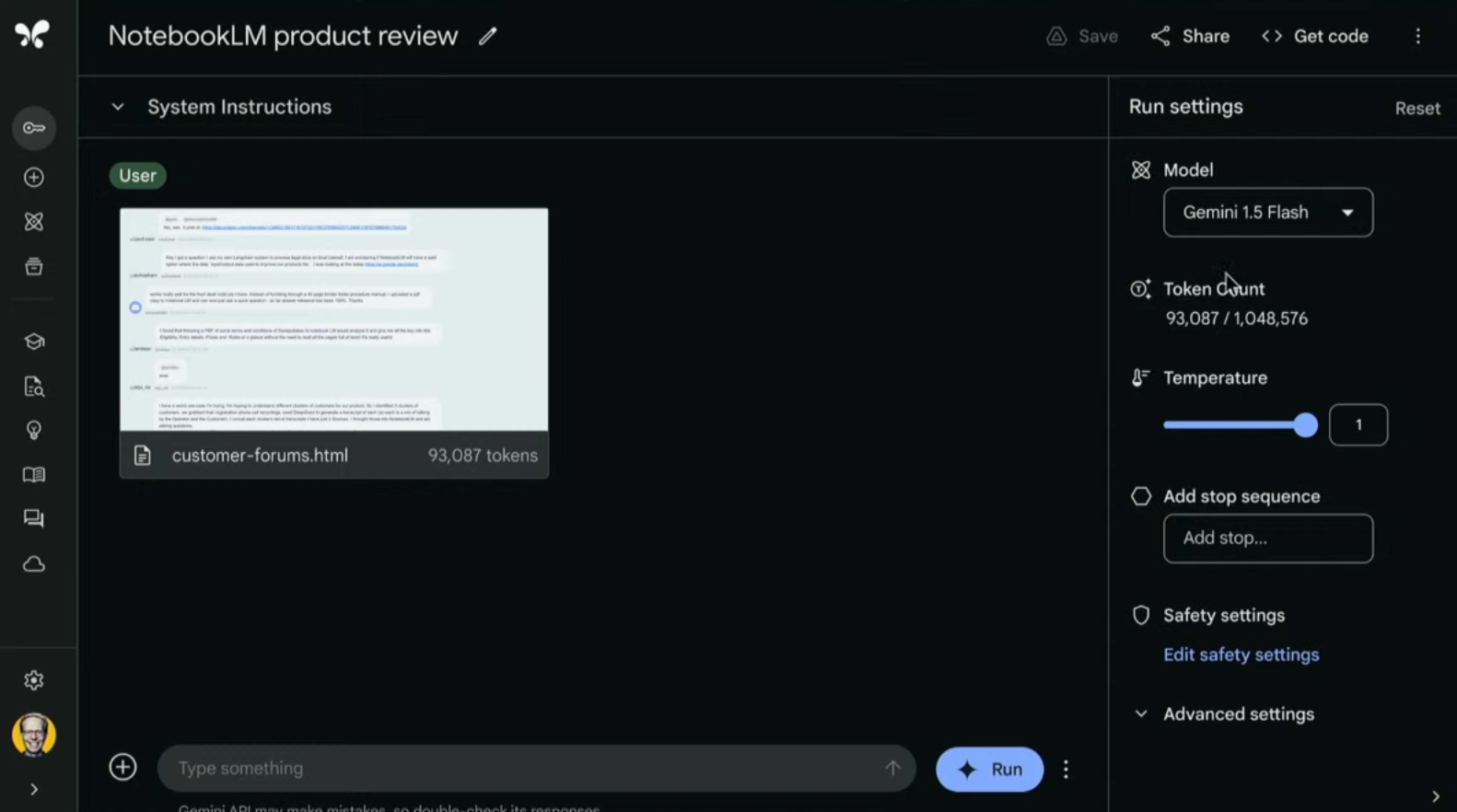

NotebookLM

Загадали і про NotebookLM.

Фактично, інформація не змінилась - в даний сервіс можна надати все, що завгодно, на кшталт нотатника - будь-які джерела, файли, медіа, і за допомогою Gemini 1.5 Pro відбувається вивчення всіх цих даних. На основі цих даних можна робити різні запити і отримувати різну подачу аналізованох інформації в необхідному вигляді.

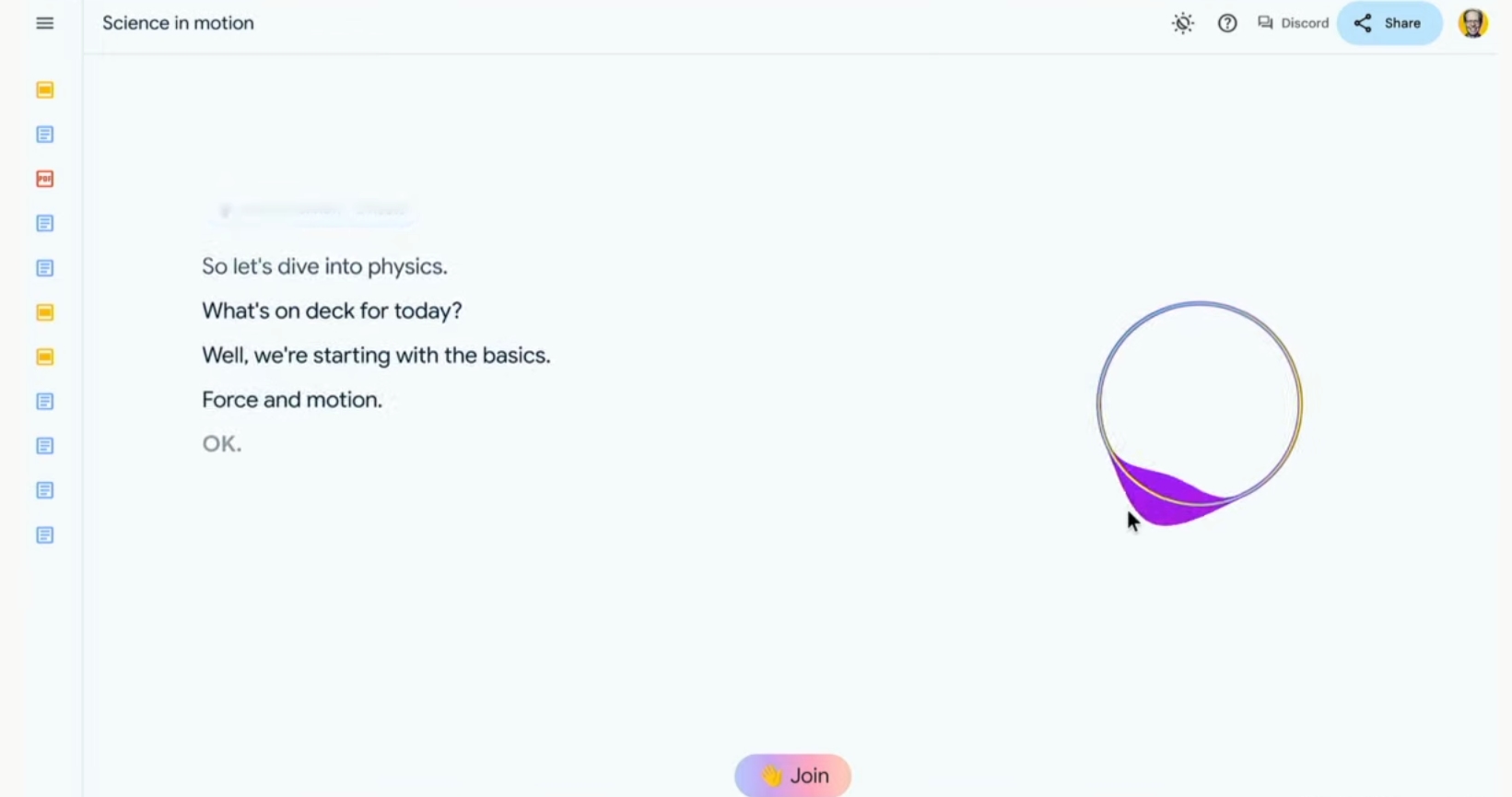

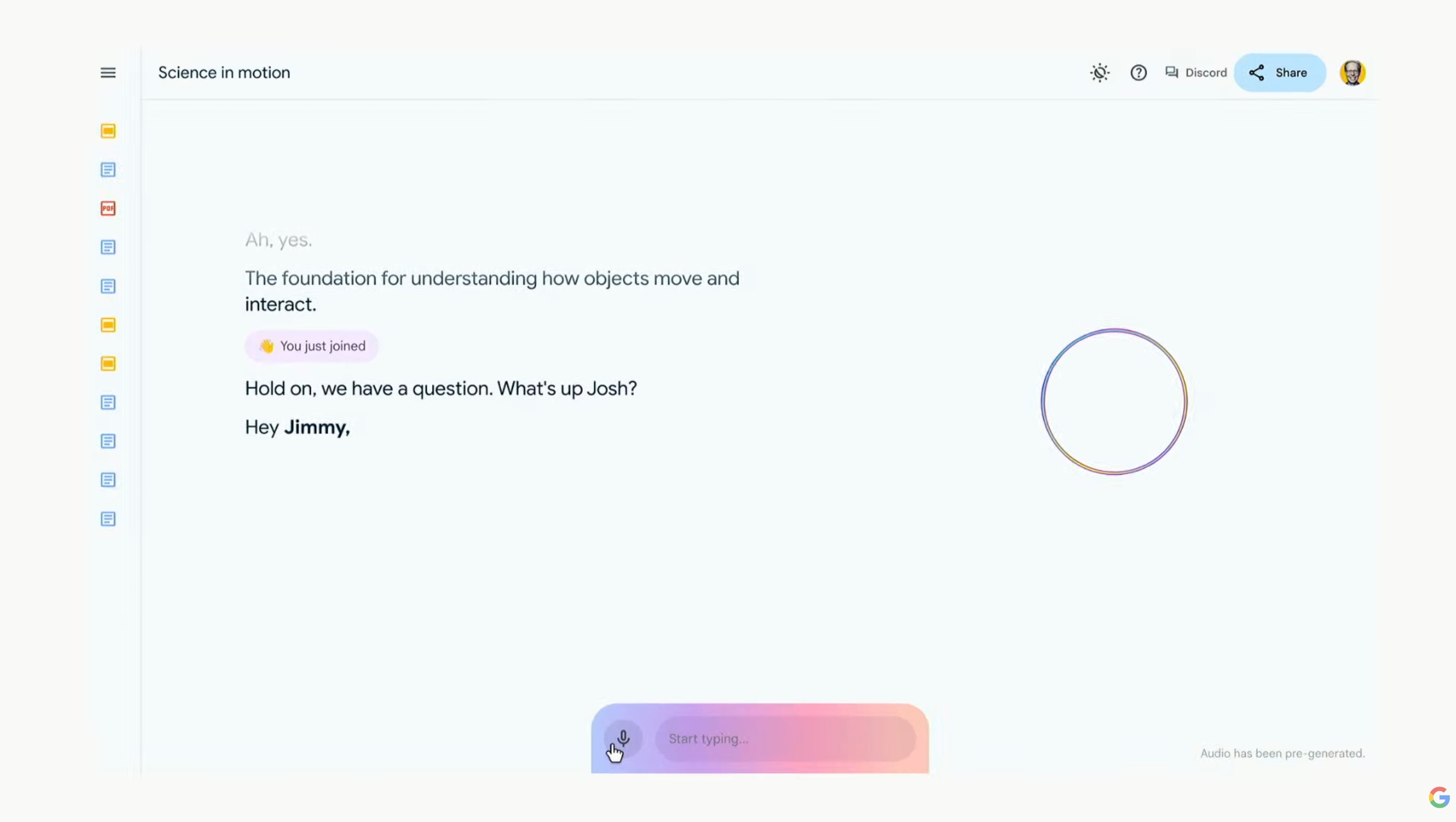

З нового - тепер можна генерувати діалоги з цього всього, що відбуватиметься неначе люди пояснюють щось користувачу.

Що цікаво, і відчувається дійсно інноваційно - це можливість включатись в цей діалог і робити додаткові запити з контекстом, який потрібен.

Також, Gemini може поєднувати інформацію з мережі з наданою, і давати комбіновані відповіді або пояснення вже з контекстом поза наданими даними.

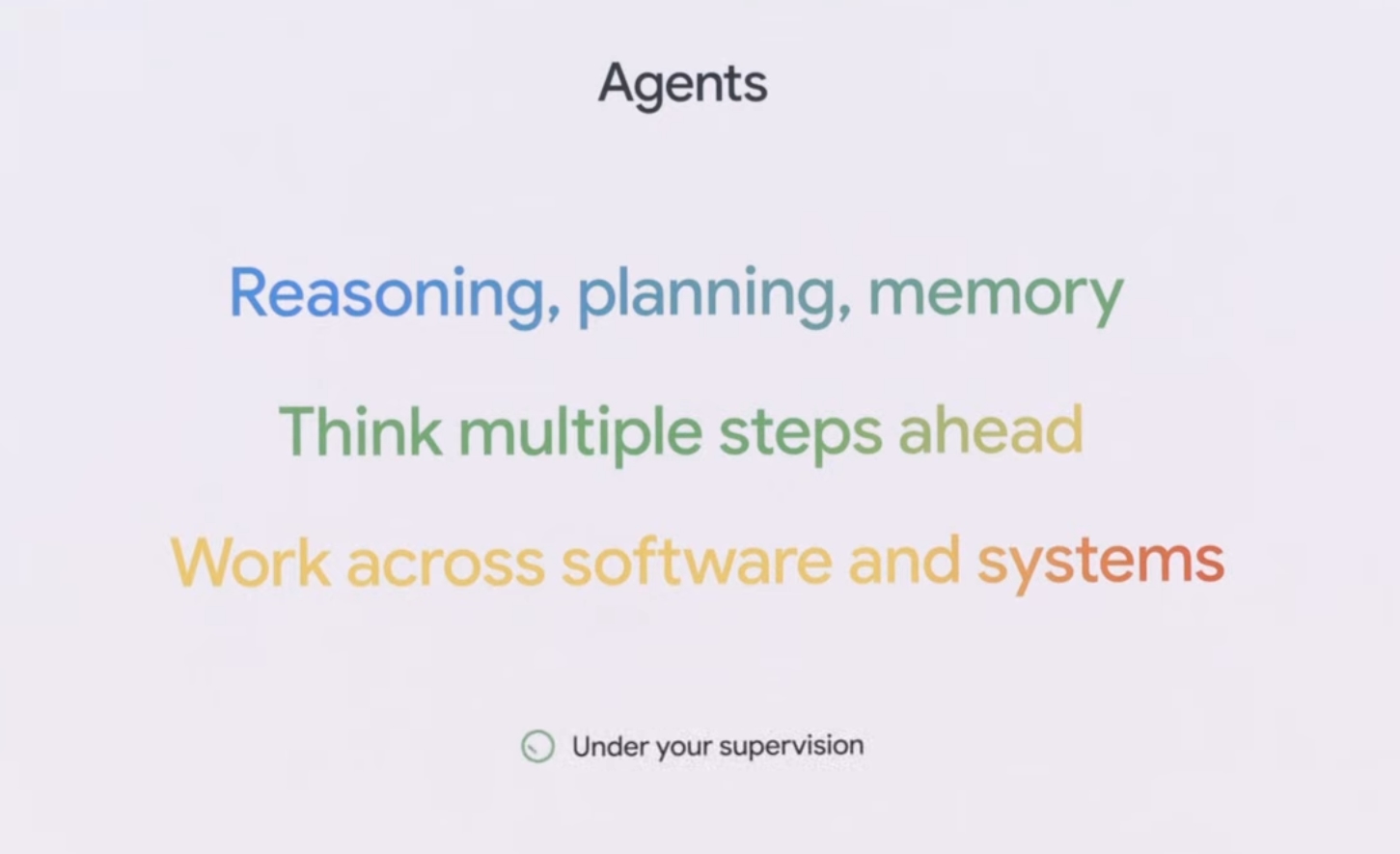

AI Agents

Після цього пішли про AI Agents.

Фактично, це спосіб комбінування кількох дій в різних сервісах Google, на демо - це було повернення взуття, придбаного в певному магазині. Тобто тепер Gemini може одразу визначити за допомогою пошти, яке взуття було куплене, і, якщо воно не підійшло (а запит був про це) - одразу запланувати його повернення, додати це в календар і спланувати все за користувача.

Основний сенс цих нововведень:

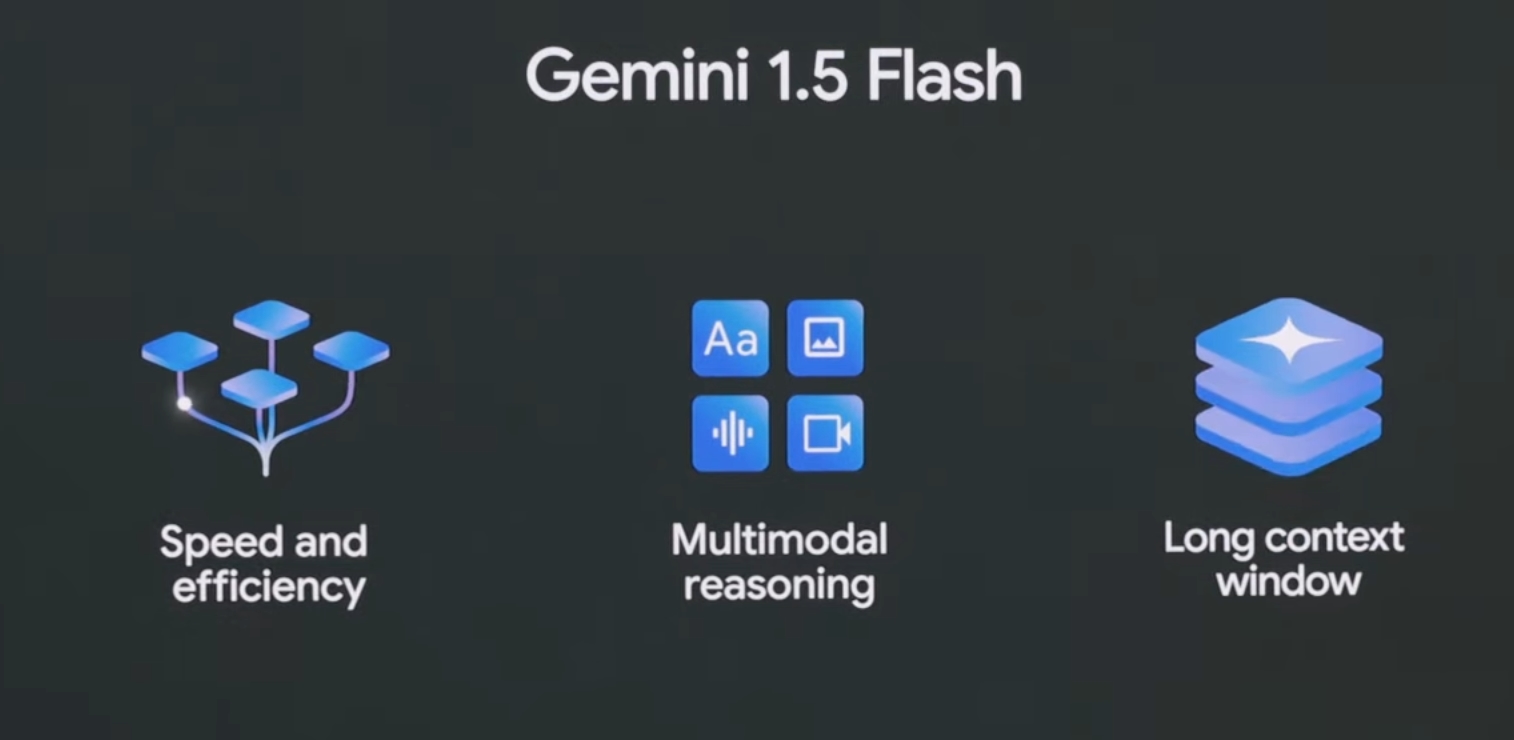

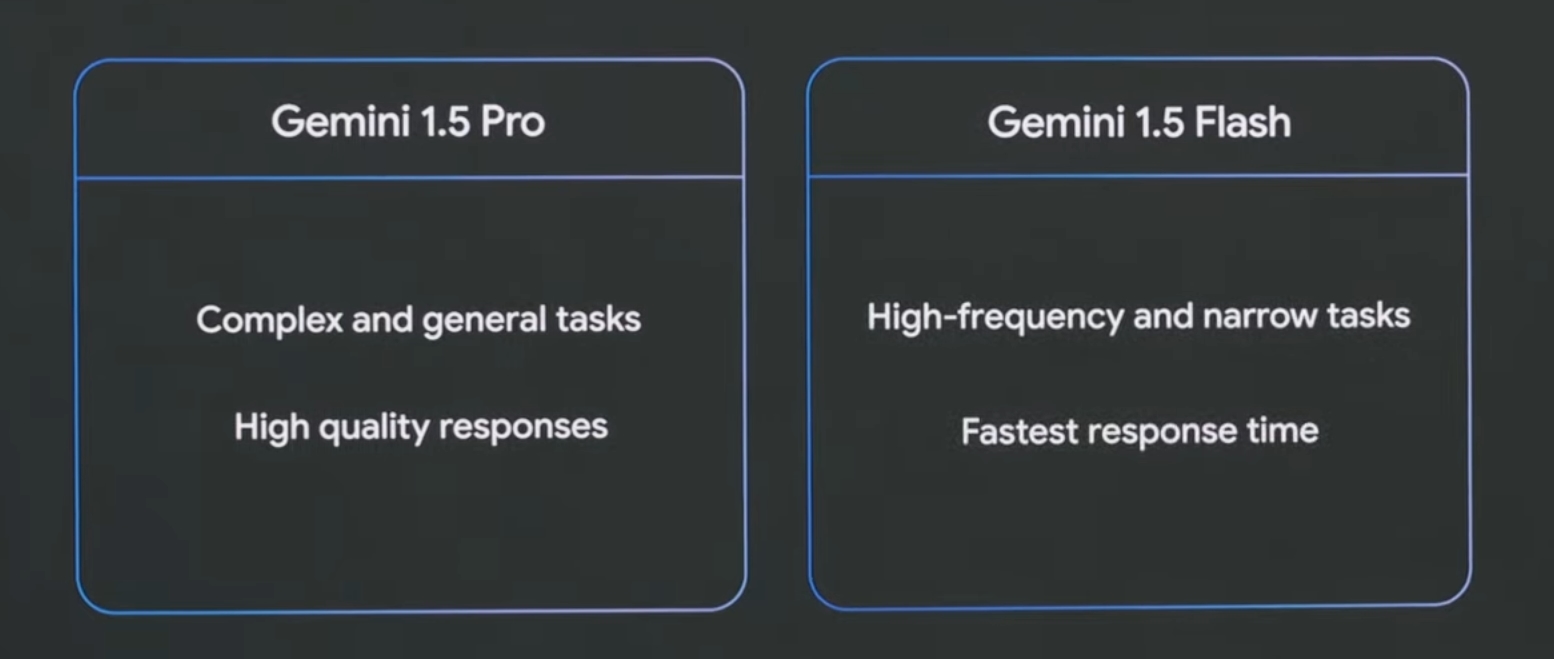

Gemini 1.5 Flash

Далі вийшов представник Google DeepMind.

Його розповідь була про те, де застосовується інфраструктура Google для ШІ.

Після - він презентував Gemini 1.5 Flash.

Суть існування цієї моделі паралельно з моделлю Pro - в швидкості і ефективності.

Доступно вже.

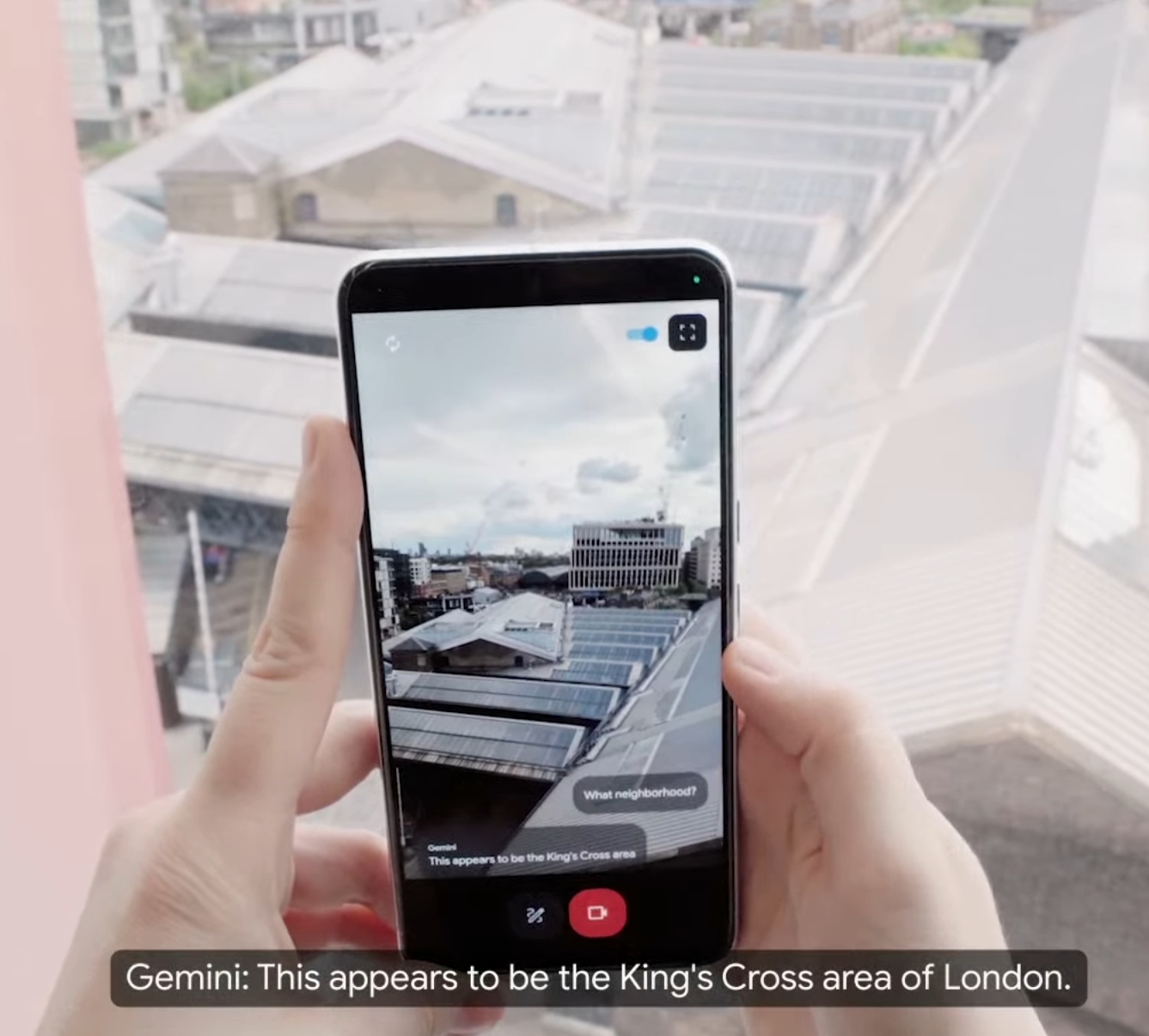

Project Astra

Це один з найцікавіших анонсів за всю презентацію

Суть - в тому, щоб повністю зробити зрозумілою взаємодію з ШІ, який пам’ятає і розуміє контекст.

Тобто завдяки Project Astra - Gemini може розрізняти все навколо, запам’ятовувати речі і їхнє положення, мати контекст стосовно них і відповідати на питання про них, а також про їхню взаємодію між собою і з невідомими речами за взятою інформацією з мережі. Якщо такі можливості з’являться у людей в звичайних смартфонах у кожного (нехай і за підпискою) - це може дійсно стати справжнім асистентом для кожного, з можливістю нагадувань як про віртуальні речі, так і про реальні, а також - про те, як вони взаємодіють.

Generative media

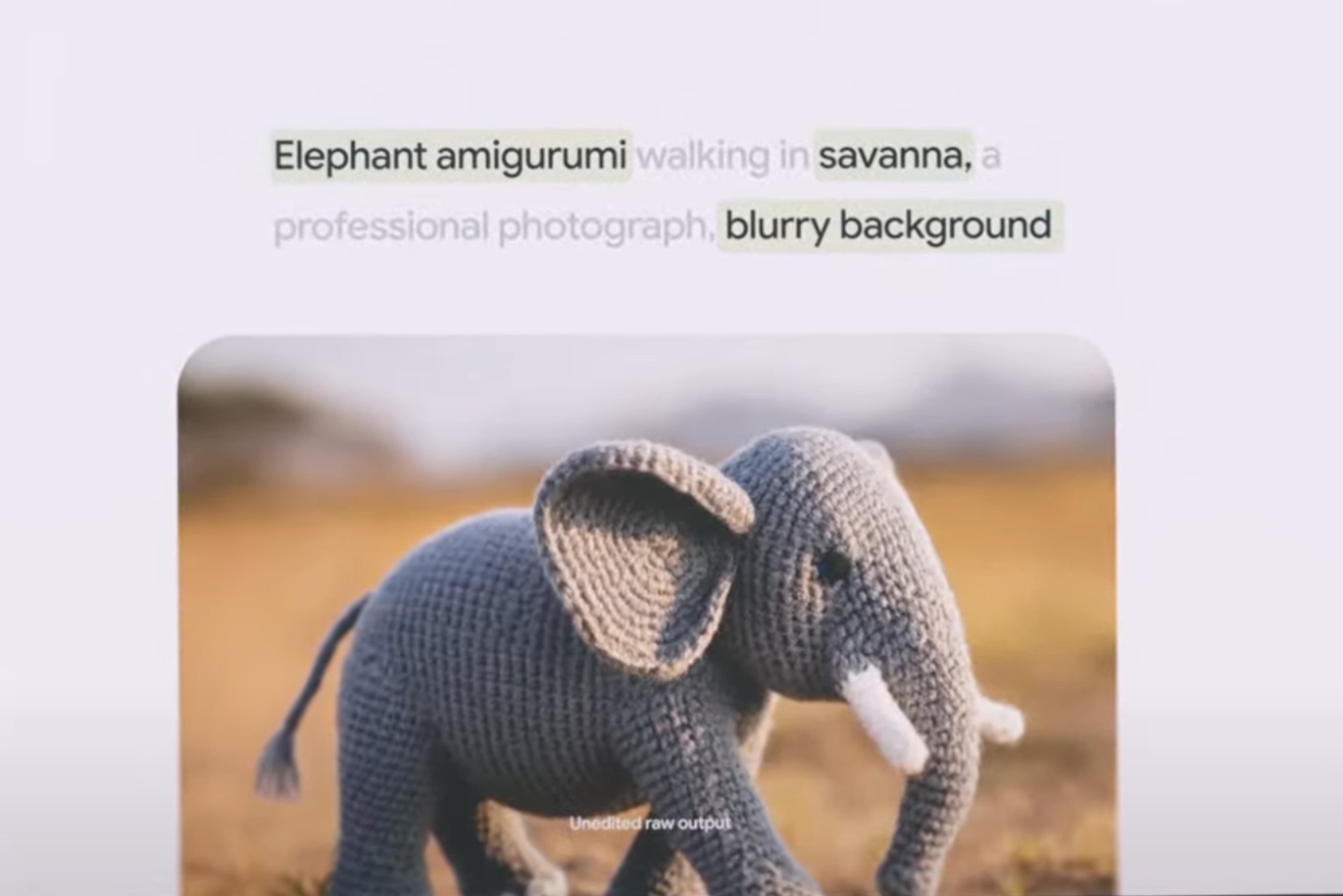

Компанія створює інструменти на основі ШІ для створення зображень, музики та відео.

Наразі, з нуля був перероблений інструмент для створення зображень за запитом, його назвали Imagen 3.

Тепер, після повного перестворення - даний сервіс вміє створювати фотореалістичні зображення по складним запитам.

Також, показали, як різні музиканти взаємодіють із сервісом для створення музики з допомогою ШІ.

З того, що стало зрозумілим - модель може як комбінувати надані семпли на новий манер, так і пропонувати повністю нові, а також сама збирати це в повноцінну мелодію.

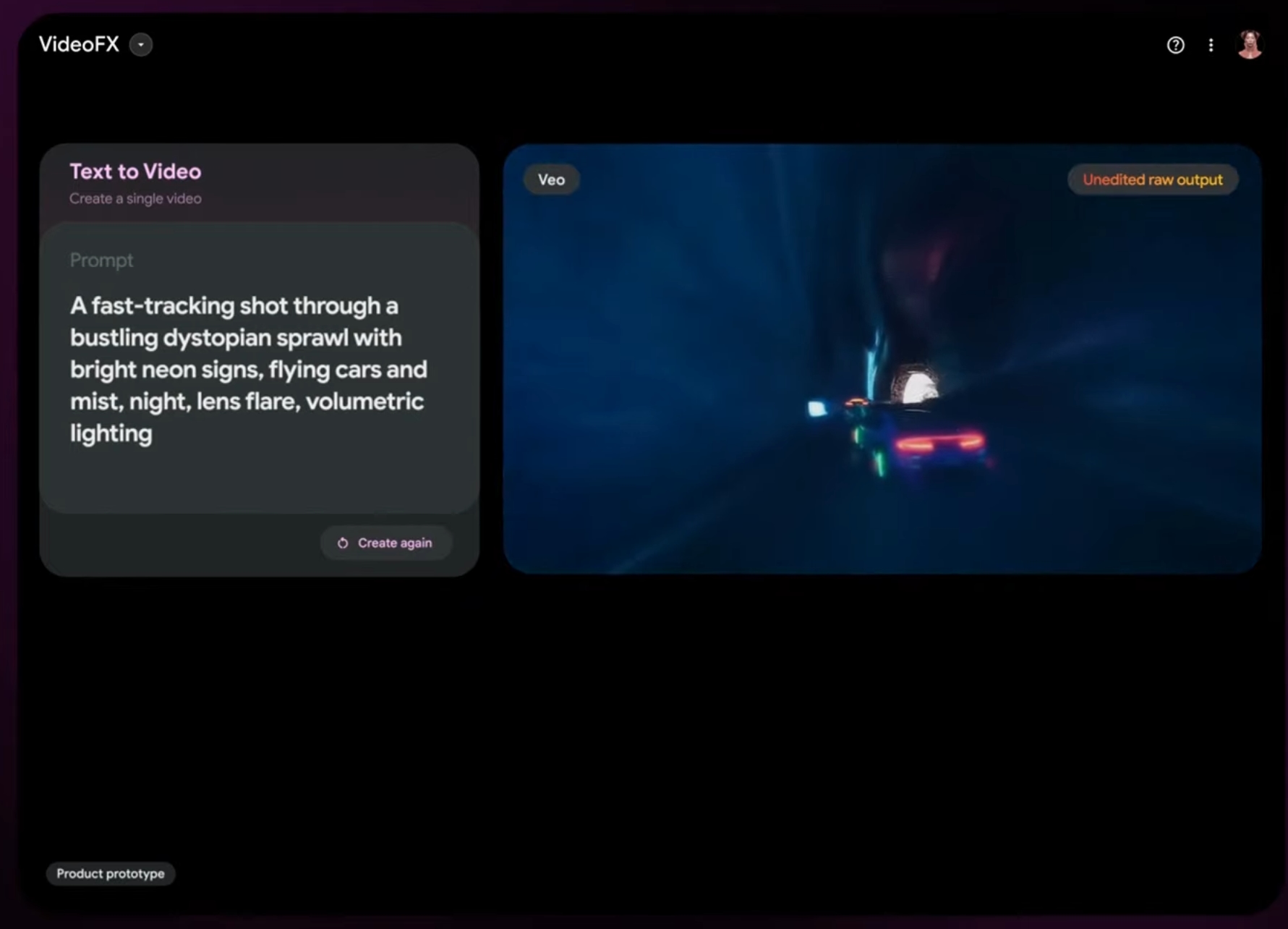

І, мабуть, найцікавіше для звичайного користувача - новий сервіс для створення повноцінних відео за запитом - Veo.

Тут мене дійсно вразила якість результатів.

Всі приклади, які були продемонстровані - дійсно вражають. Для створення чогось подібного вручну - я навіть не уявляю, які ресурси треба мати, тут же - все створюється в хмарі за простим запитом чат-боту.

Апаратні розробки

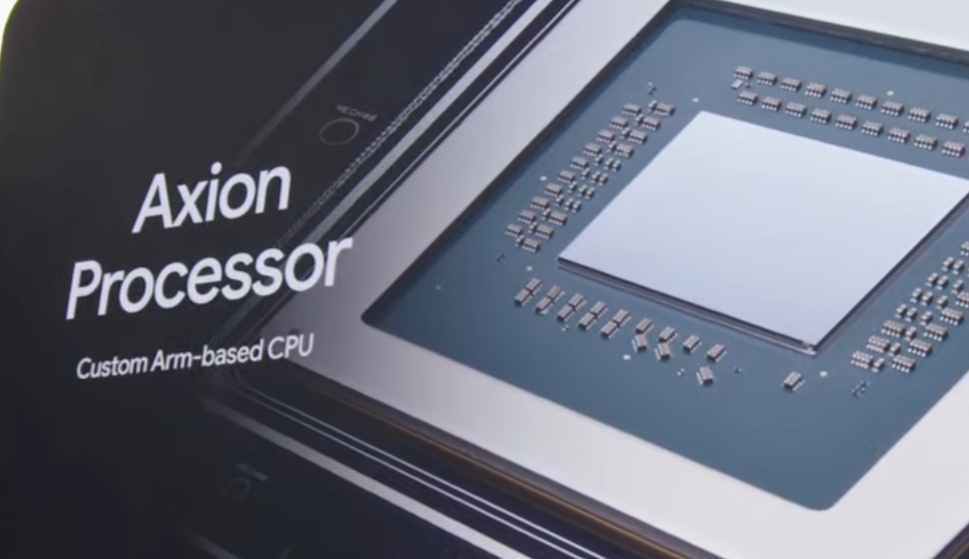

Опісля, розповіли про нові тензорні процесори власного виробництва, а також ARM-чіпи власного виробництва.

Це все було в рамках пояснення того, що компанія володіє широкою інфраструктурою для роботи з ШІ і, також - що вони створили свій гіперкомп’ютер з ШІ.

Оновлення Google (пошуковика)

Надалі, перейшли до деталей по оновленням основного і найпопулярнішого сервісу компанії - пошуковика.

AI Overviews

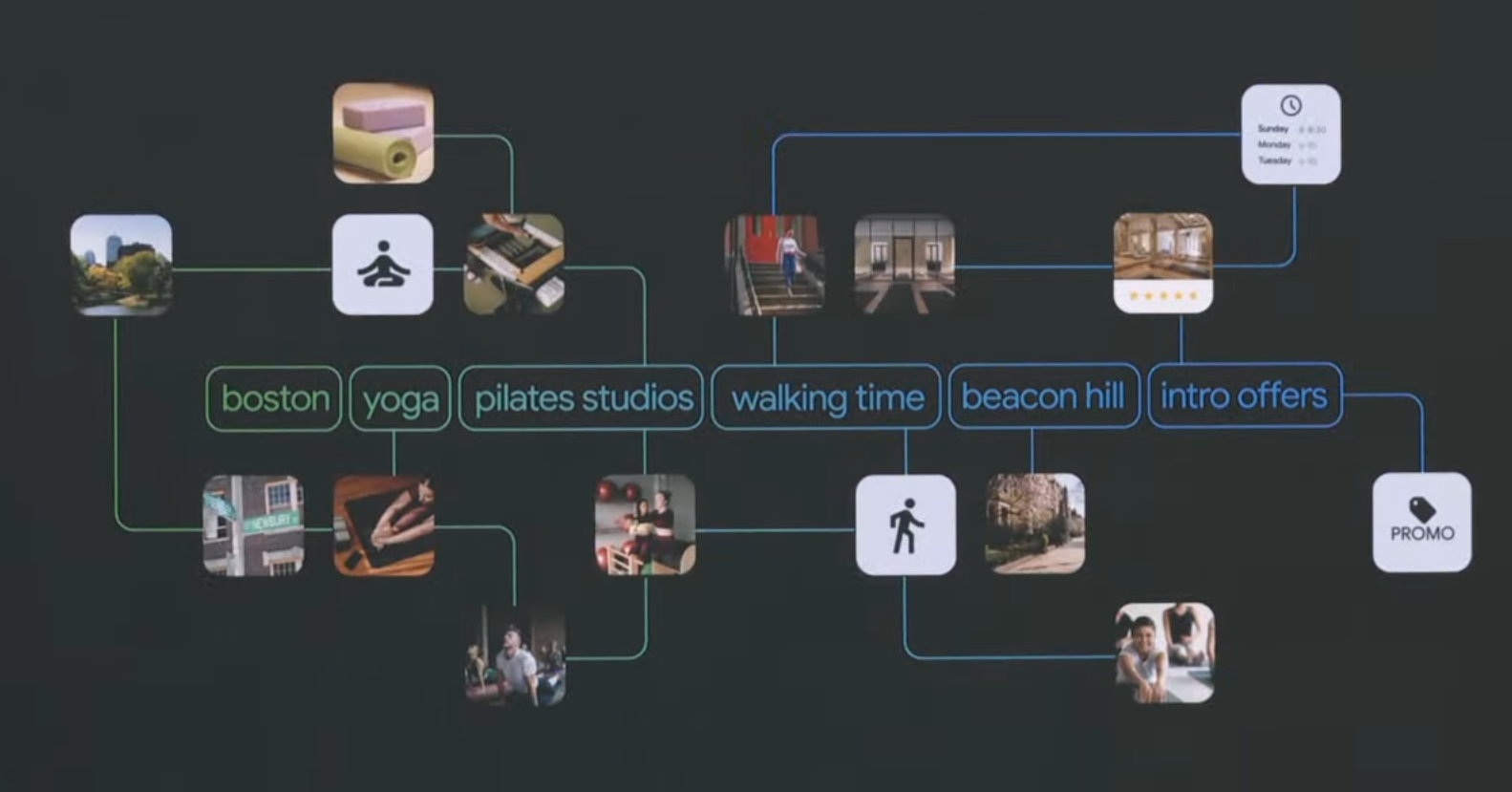

Знову нагадали про AI Overviews, але вже з демонстрацією - в пошук тепер можна буде задавати великий запит з нюансами і деталями, а Gemini буде все задане враховувати і видавати потрібний стислий результат. Тобто тепер ніяких запитів по типу “бургери Київ” і розбирання всіх результатів, а справді детальний запит з районом, цінами і рівнем відгуків/популярністю.

Тобто Google як пошуковик буде досліджувати питання за користувача.

Також, надали приклад того, як пошук може робити планування різних речей, тієї ж дієти - і це дійсно буде виглядати як план.

Важливо, що пошукова модель тепер може надавати більше результатів з різними пропозиціями з пропонуванням контексту зі свого боку, замість простої видачі результатів по запиту.

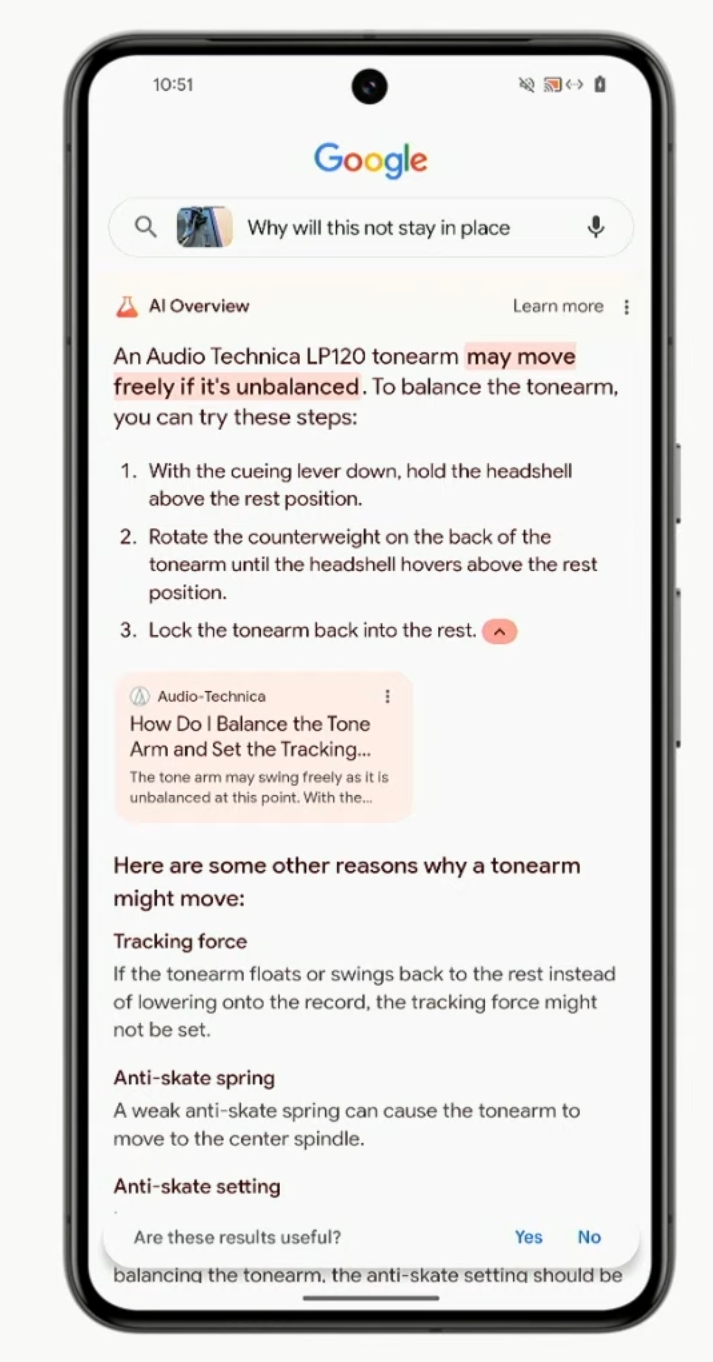

Ask with video

Також, скоро запрацює функція в пошуку - можна буде шукати по контексту відео.

В демо показали, що можна прямо показати на відео проблему, запитати про неї і отримати відповідь з розгорнутими кроками для її вирішення.

Функції почнуть додаватись в пошуковик найближчими тижнями.

Gemini for Workspace

Після цього перейшли до:

Анонсували доступ для всіх наступної фічі:

Фактично, це те, що презентували на минулому І/О, але тепер буде доступне кожному, а не тільки обраним корпоративним користувачам. Також, показали і демо на смартфоні в Gmail - можна підсумувати листи, опрацювати інфу з них і оце все. Кілька фіч все ще будуть ставати доступними y Workspace Labs:

Наступною функцією, яку показали, стала автоматизована взаємодія між сервісами Google. Тобто це повноціння автоматизація роботи документів, пошти, календаря і файлів в хмарі, коли юзер може прямо створити сценарії обробки листів чи документів, або ж файлів чи подій в календарі, і все це буде оброблятись без необхідності користувачу контролювати цей процес або ж взагалі виконувати його вручну.

Також, можна буде ставити питання по даним в Workspace (всіх сервісах), анонсовано в Labs в вересні цього року.

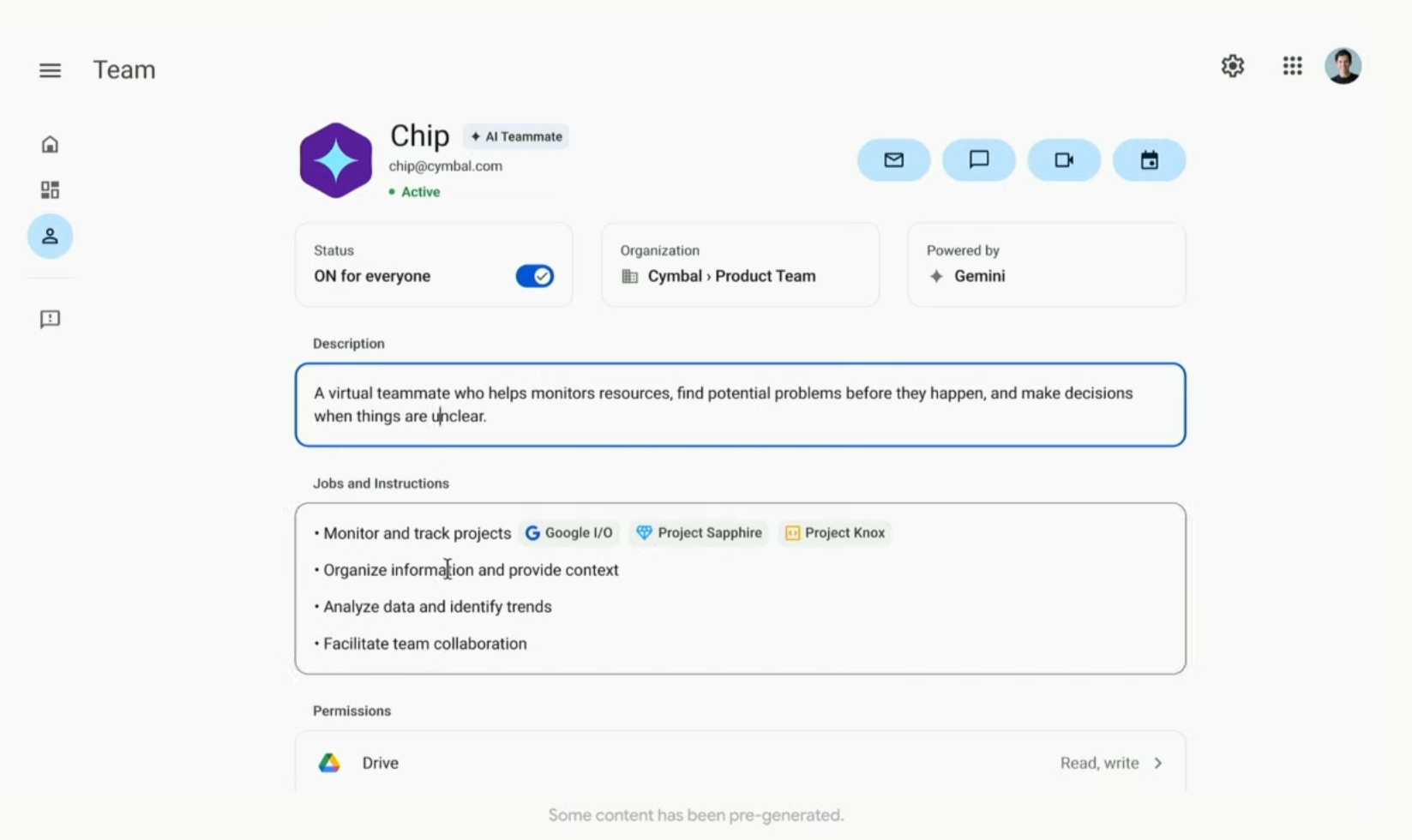

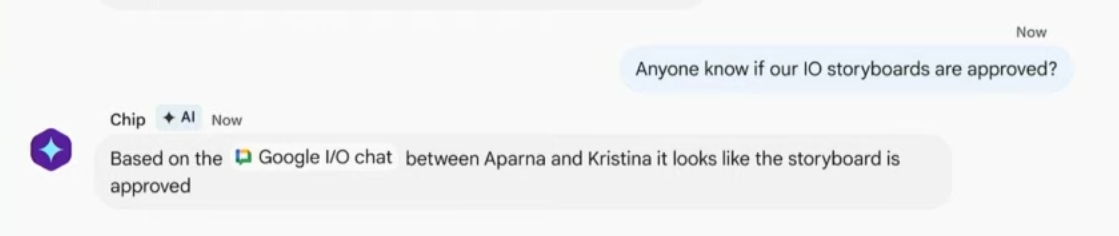

AI Teammate

Представники компанії поділились також планами створення AI Teammate - тобто віртуального працівника.

Він може взаємодіяти з інформацією з корпоративних чатів, файлів і т.п., і відповідати на питання про них як людина в звичайних чатах. Це як звичайний чат-бот для персонального використання - але зі знаннями всього, до чого встиг торкнутися в межах компанії, розумінням контексту цих даних і можливістю відповіді в чатах як звичайний колега.

Оновлення сервісу Gemini

Перейшли тепер до опису оновлень самого чат-бота Gemini, який доступний вже у багатьох країнах звичайним користувачам.

Першим критичним нововведенням, по якому може здатися, що компанія все ще наздоганяє основного конкурента - стає Gemini Live.

Фактично, це просто постійний голосовий бот, який не перестає слухати і відповідати після кожного запиту.

Стосовно ж більш інноваційного оновлення - цього року також можна буде постійно показувати речі камерою, а не лише робити фото, і включати їх в контекст. Я так розумію, що це якраз та інтеграція Project Astra прямо в Gemini відразу для всіх користувачів.

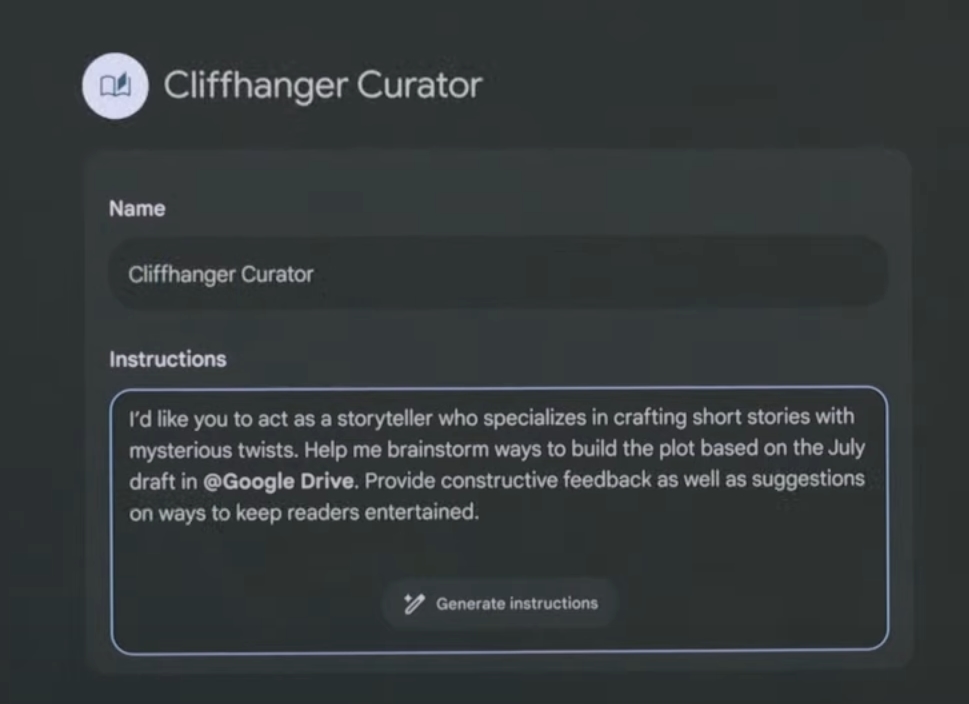

Також розповіли про те, що можна створювати інструкції для Gemini - Gems, які можна юзати повторно для саморозвитку, наприклад.

Тобто Gemini зможе навіть стати універсальним засобом замість проходження курсів на будь-яку тему. Вихід в світ також заплановано на цей рік.

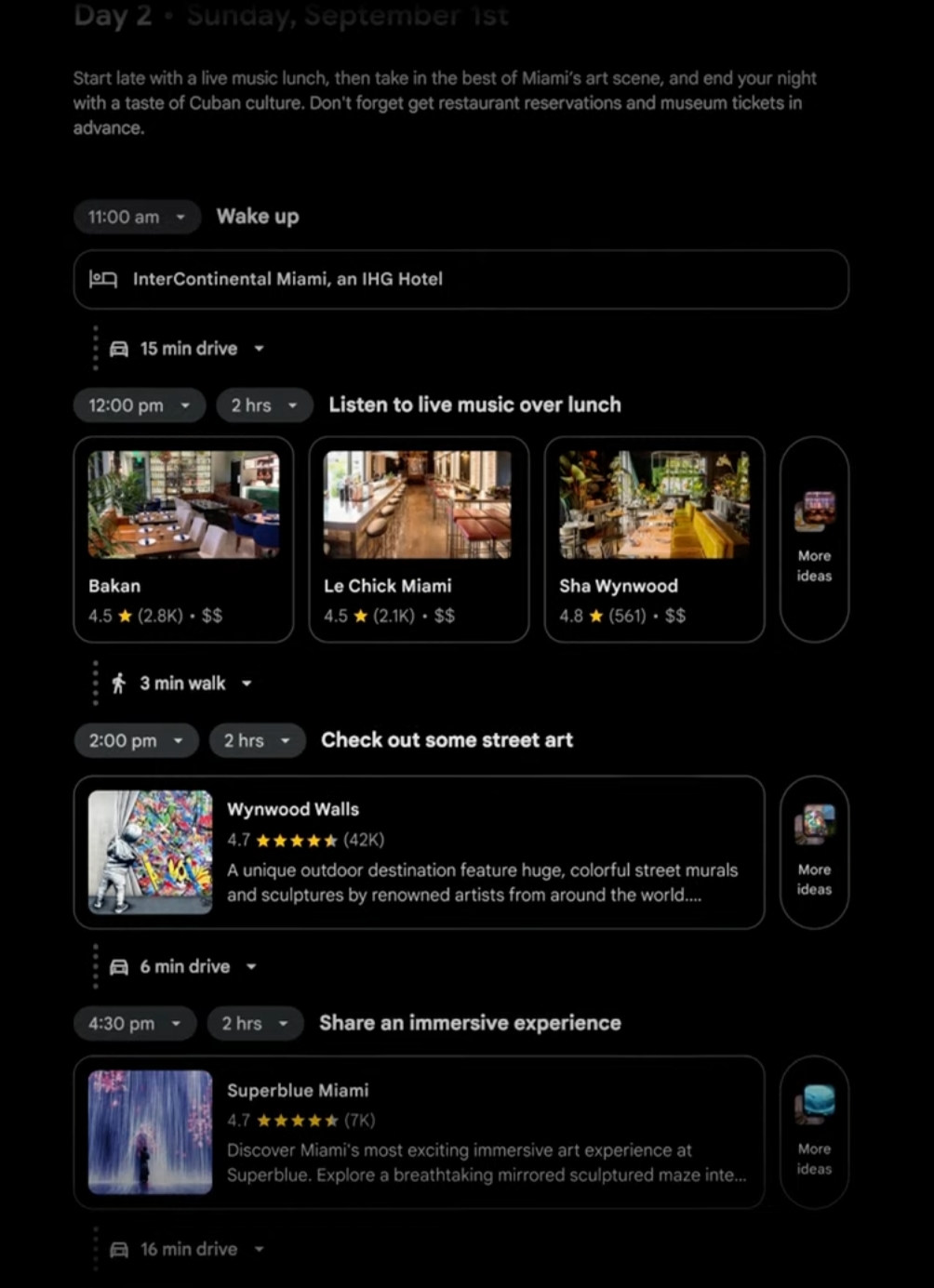

Як зазначалось раніше - Gemini навчиться повноцінному плануванню за складними запитами; включатиме інформацію з багатьох джерел, беручи за основу інформацію з запиту і сортуючи її. Також є повна кастомізація цих планів.

Це виглядає як чудовий спосіб планування абсолютно всього - дієти, розпорядку дня, покупок, поїздок і т.п. Можливість налаштування і зміни кожного пункту особливо радує. Мені, правда, цікаво, чи можне буде це зберігати в інтерактивному вигляді і повертатись з можливість кастомізації в будь-який момент… Обіцяють реліз влітку.

Gemini Advanced

Тепер перейшли до підписочного сервісу, де якраз і надали доступ до версії 1.5 Pro, і де якраз і доступна обробка 1 млн токенів (я так розумію, це кількість символів) на кожен запит.

Тобто можна завантажувати будь-які величезні файли для аналізу і дізнаватись з їхнього змісту потрібну інформацію в потрібному вигляді.

Представник компанії уточнив, що дані людей не використовуються для навчання моделі. Це було дійсно важливе питання, бо зараз багато різних судових позовів, що стосуються цього.

Також, анонсували, що влітку модель зможе обробляти вже 2млн токенів, а також підтримуватиме більше 35 мов.

Android

Згадали і про те, що вони розробляють Android, та нагадали, як інтегрували ШІ в ОС останніми роками.

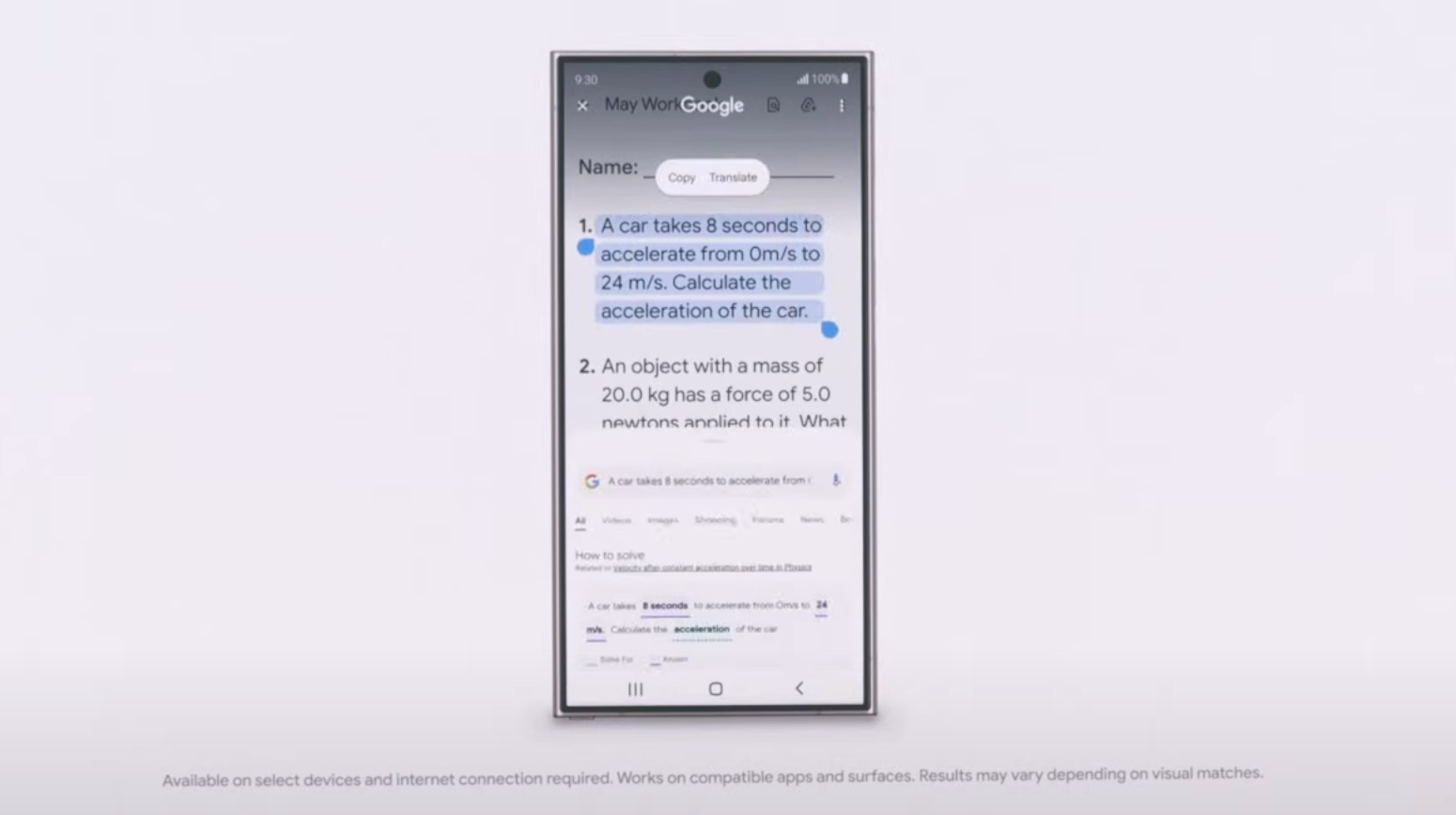

Також, кокмпанія покращує роботу “кружечка для пошуку”. Тепер він може не тільки видавати результати, а й надавати більш точні інструкції для різних задач, пов’язаних з навчанням (математичні і фізичні, наприклад).

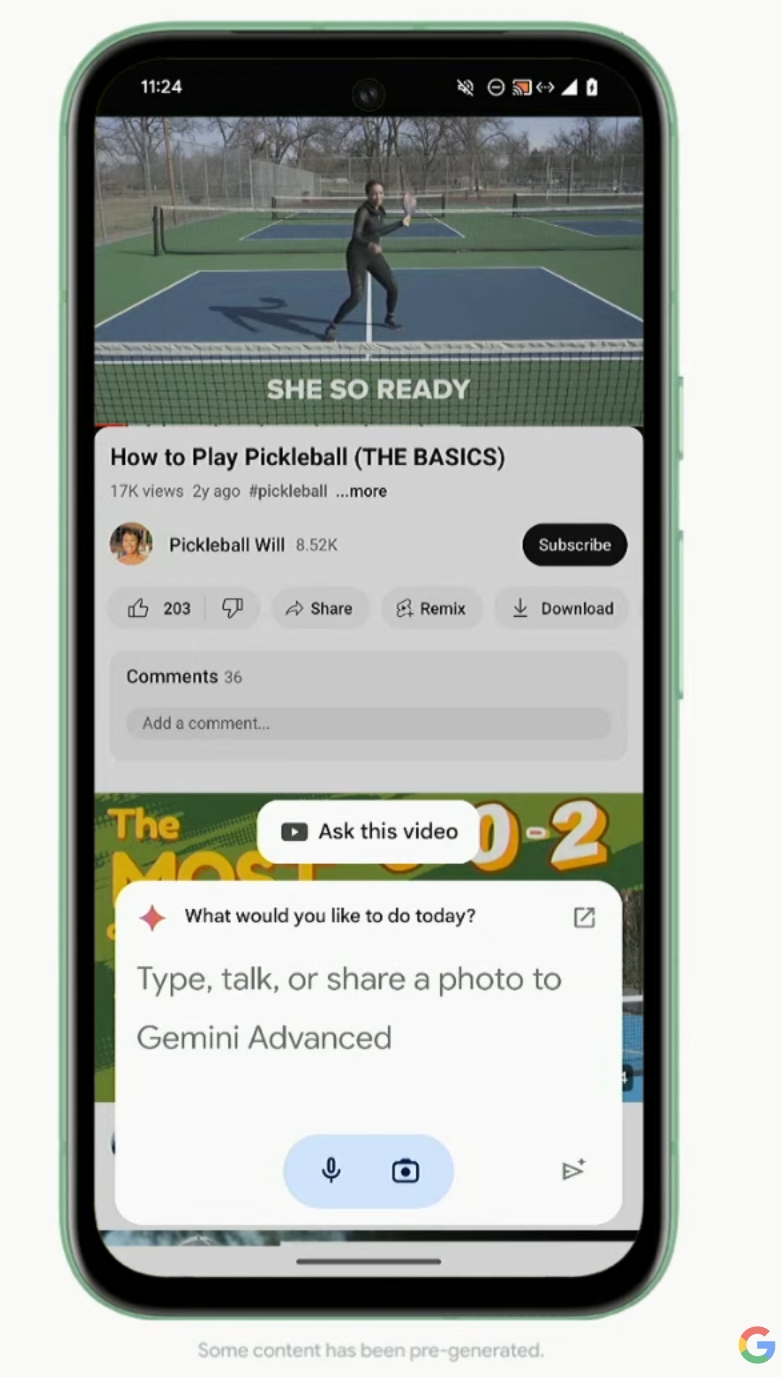

Далі показують, як працює інтеграція Gemini в систему.

На демо показали як Gemini вивчає відео на ютубі і дає відповідь на питання по тому відео, що дозволяє користувачу швидко отримати з нього інформацію замість перегляду його повністю і витрати часу.

Або ж Gemini обробляє документ, який відкритий на екрані (причому саме як файл, а не лише те, що влізло на видимій частині) - і відповідає на питання про нього.

Під час цих анонсів представник компанії робить дуже сильний акцент на тому, шо Gemini повноцінно працює лише на Android, що досить цікаво, бо зазвичай не було такого акценту “only on Android”.

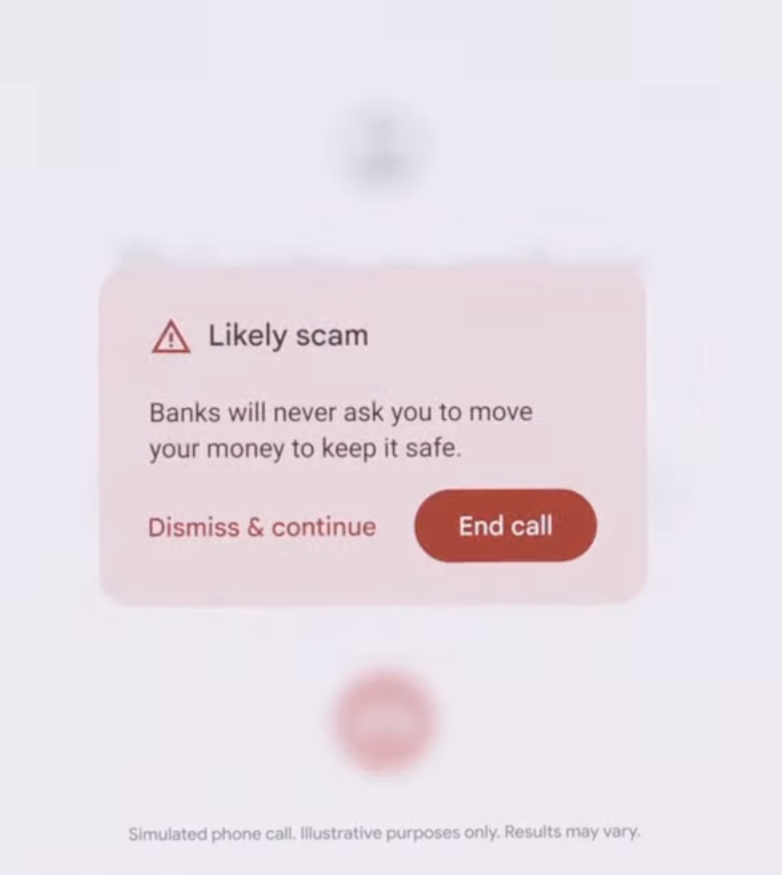

З цікавих нововведень також анонсували, що нова Gemini Nano в Google Pixel вже цього року матиме більше розуміння даних, і можливість їх обробляти на пристрої замість хмари, покращуючи таким чином безпечність і конфіденціність. До прикладу - пристрій зможе слухати телефонні розмови і прямо локально визначати, чи це шахраї.

І це все на пристрої, локально, без хмари і витоку даних. Має запрацювати влітку. Розумію, що українську воно не підтримуватиме - але ж наскільки це корисна річ! При цьому нема залежності тепер від номерів телефонів, які можна підробляти чи приховувати - а ШІ дійсно буде аналізувати сказане.

Анонсували також вихід нової бети Android:

Щось для розробників ШІ

В цьому блоці більше було інформації для розробників - що можна вже записатись на очікування доступу до Gemini з 2 млн токенів:

Також пояснення різниці між Gemini 1.5 Pro та Gemini 1.5 Flash:

Також, в кінці вирішили показати демо в AI Studio.

Демо було більше для розробників, тож я не дуже його розумію, тут вибачте.

Далі розповіли про:

Що є кілька моделей саме для розробників, але я не дуже зрозумів це, і я не очікував, що настільки заглиблюватись будуть в технічні деталі ШІ для розробників саме під час Keynote, який дивиться більшість звичайних любителів таких заходів, хто взагалі зацікавлений в досягненнях компанії.

Але всю інформацію саме стосовно Gemma - можна дізнатись в офіційному блозі компанії.

Відповідальність і завершення

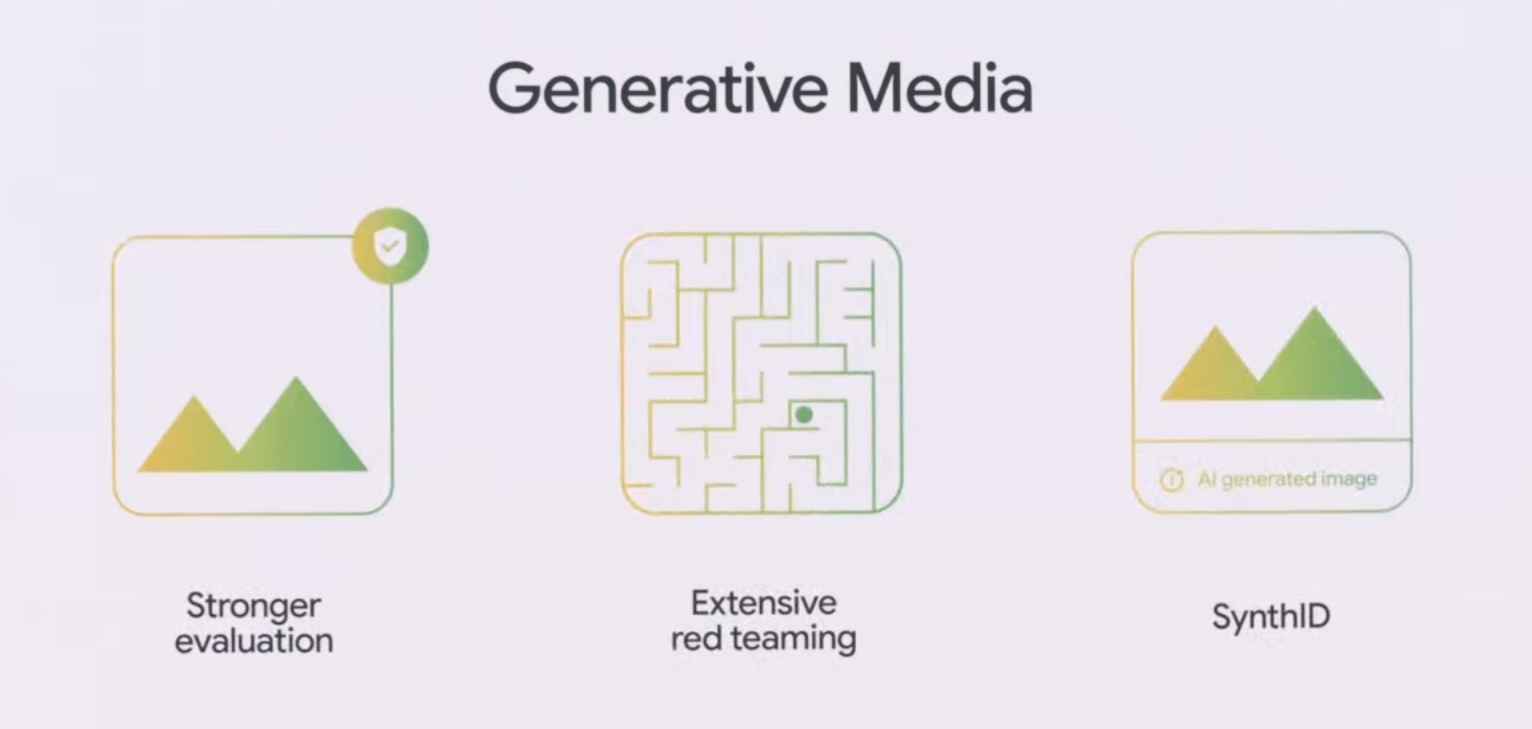

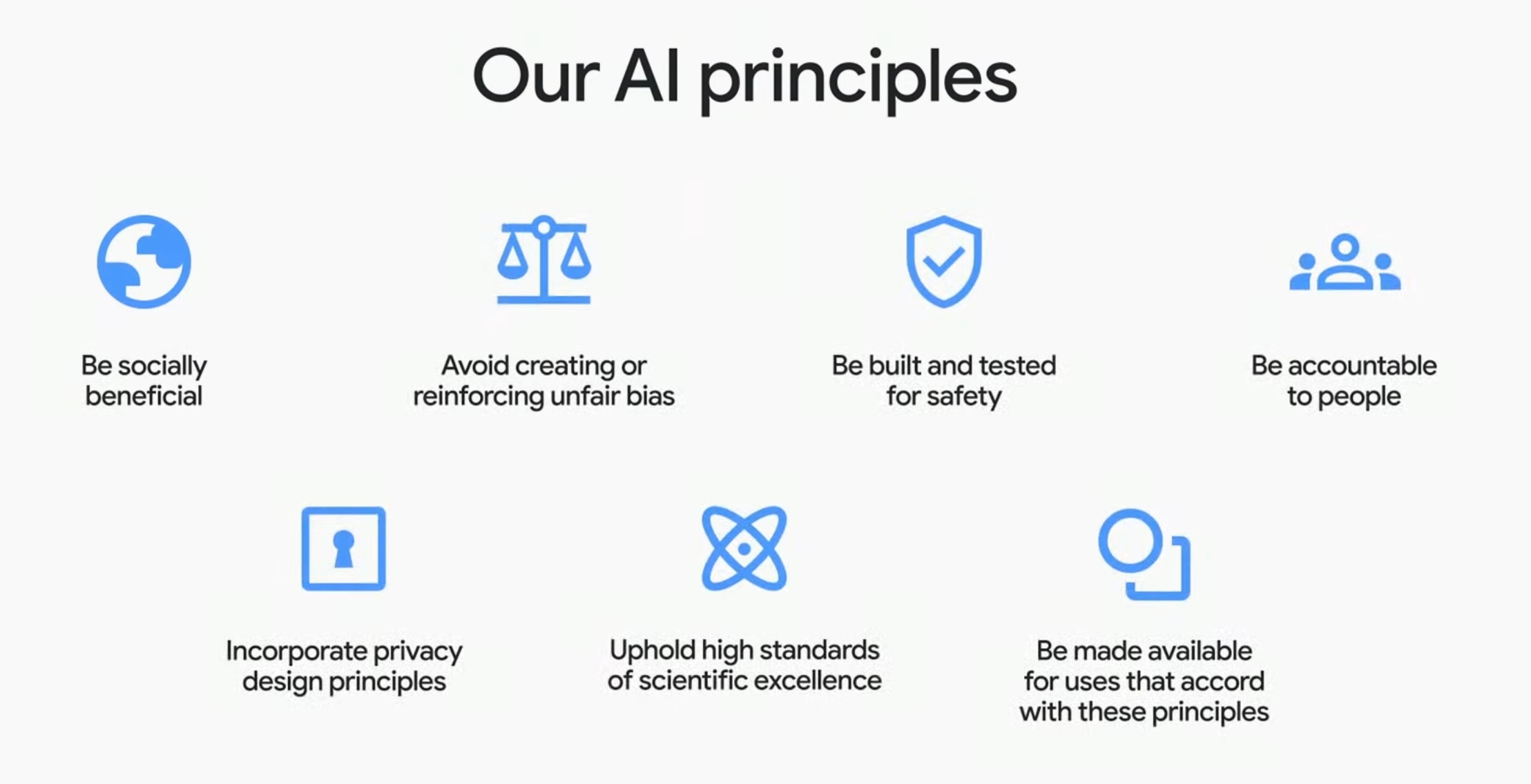

Наприкінці згадали про те, що розвиток ШІ має бути відповідальним. Надали принципи, за якими це виконується.

Далі перейшли до більш загальних речей. З цікавого - LearnLM.

Це те, що “живить” вищезгадані Gems в Gemini - тобто дозволяє вчитись за допомогою ШІ.

Наприкінці, Сундар Пічай повідомив найважливіше - скільки разів сказали “АІ” протягом події - і це 121 раз :D

Висновки

Цього разу презентація виявилась більше для заглиблених в тему ШІ людей і розробників, аніж для пересічних користувачів, які хотіли дізнатися нові функції в їхніх пристроях, які з’являться протягом найближчого часу. З одного боку - прогрес вражає, дуже багато можливостей для взаємодії з інформацією як з мережі, так і з реального світу компанія надає людям, причому велику частину з них - безкоштовно. Про оновлення для звичайних користувачів не забули, проте - мабуть, тому, що вже особливих змін, видимих користувачу, придумати складно - вони виглядають досить мінорно і зосереджено виключно навколо однієї теми, якою просякнута була вся подія.

Від себе хочу зазначити - це було цікаво, деякі речі я дійсно чекаю, проте з кожним роком презентація стає все більш складною для розуміння звичайним людям, і все більш зосередженою на розробниках. В цілому - це нормально, ніхто не подає це як подію для всіх, проте раніше було зрозуміліше в цілому.

Ось так пройшла одна з важливих подій цього року в сфері технологій. Дякую за ознайомлення!