Всім привіт. Вчора ввечері пройшла Keynote презентації Google I/O 2023. Зазвичай, цей захід хоч і йде на одному рівні з презентацією Apple по важливості, проте багатьом здається нуднуватим. Для більшості, мабуть, цей раз не буде виключенням, проте я постарався взяти всі основні інформаційні моменти і розписати їх зрозумілою мовою. А там, де не зрозумів - на жаль, не розписав :( Також, хочу вибачитись за кількість скріншотів, але ж це презентація була, тому візуалізація необхідна.

Тож, почнемо.

Штучний інтелект

Більша частина презентації складалась з абревіатури “АІ”, тому в цьому тексті він теж буде згадуватись занадто часто, за це вибачте як мене, так і компанію Google.

Gmail

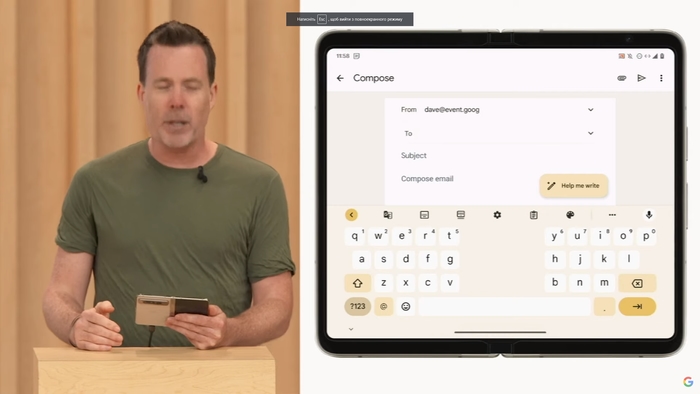

Почали з нього і як він інтегрувався в сервіси Google. Перший приклад - автопідстановка слів в листи в Gmail. Користувач може почати писати листа, а поштовий сервіс пропонуватиме продовження речень.

Ця технологія оновлюється, зветься вона тепер “Help me write”.

Тепер, користувач може просто відкрити поле написання відповіді на лист, натиснути окрему кнопку, написати ідею відповіді і ШІ згенерує її гарним формальним текстом. Також є можливість зробити його більше розширеним (неначе автор “старався” зробити його більш наповненим, по суті - додає води, як в диплом в універі).

Google Maps

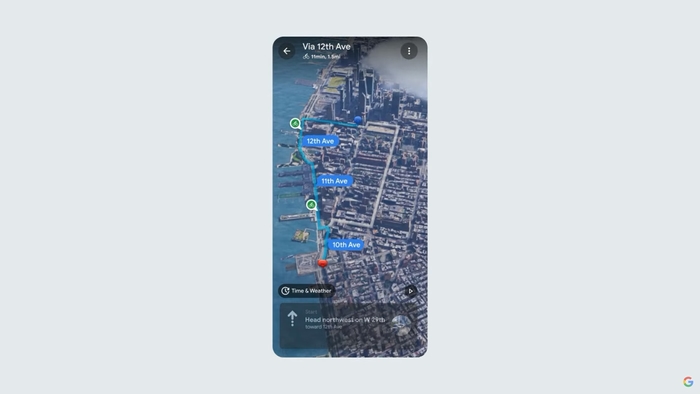

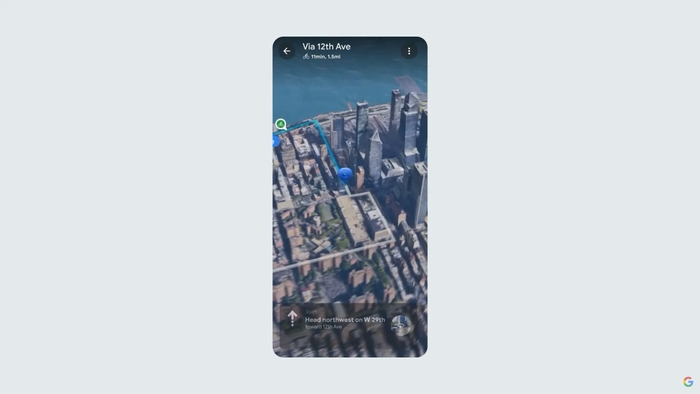

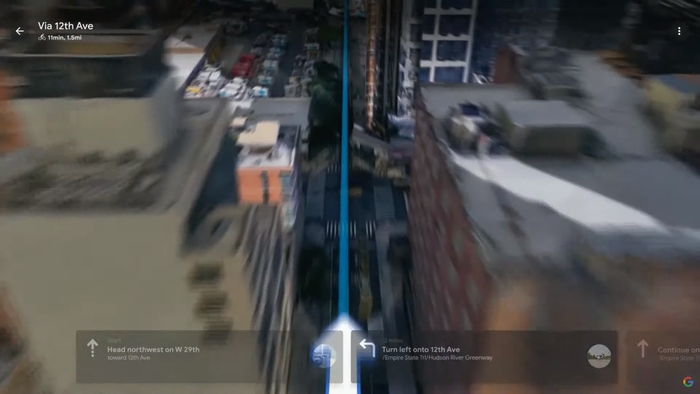

Далі почали про оновлення Google Maps (до речі, в Україні вже кілька тижнів пройшло з відновлення можливості постити коментарі на мапах, може це комусь корисно).

Дуже круте оновлення - технологія “Immersive View for routes”. Це віртуальне прев’ю маршруту з об’ємною генерованою графікою на основі супутникових знімків. Також може генерувати візуалізацію погоди і трафіку, щоб симулювати подорож більш детально. З’явиться влітку, але запуститься лише в 15 містах по всьому світу (очікувано, що навіть в Києві такого не буде, в тому числі через кляту русню). ДАлі скріншоти з прикладом роботі цієї фічі у мапах.

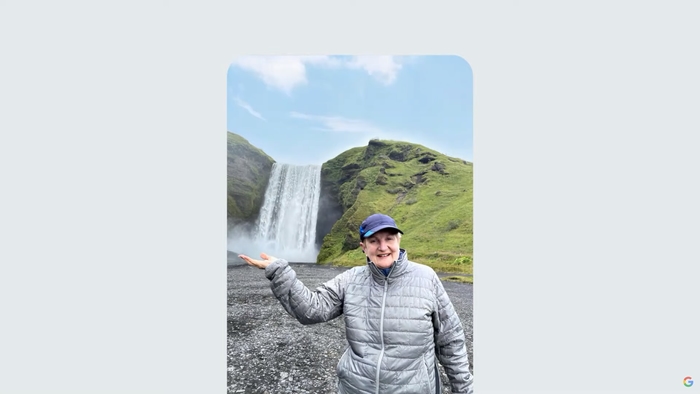

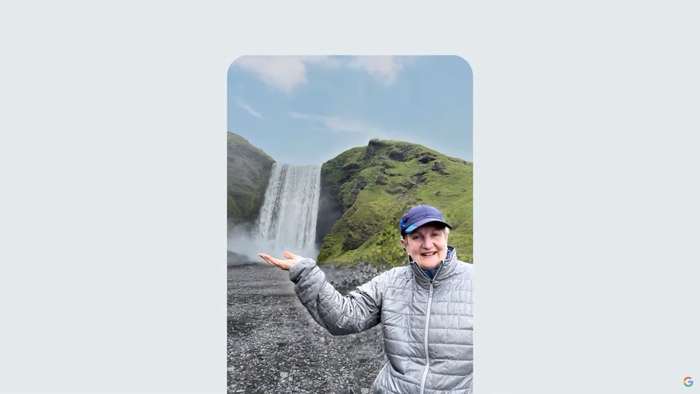

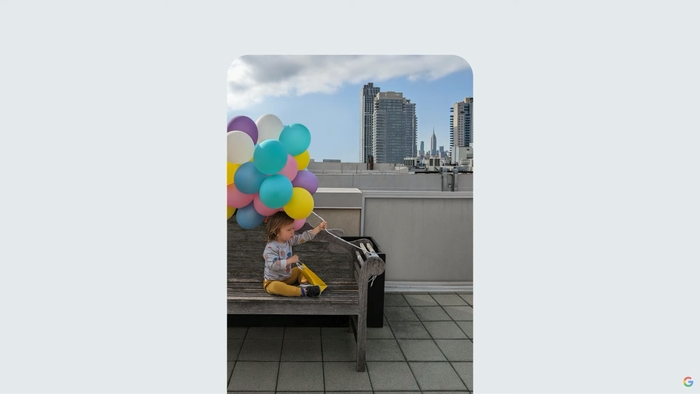

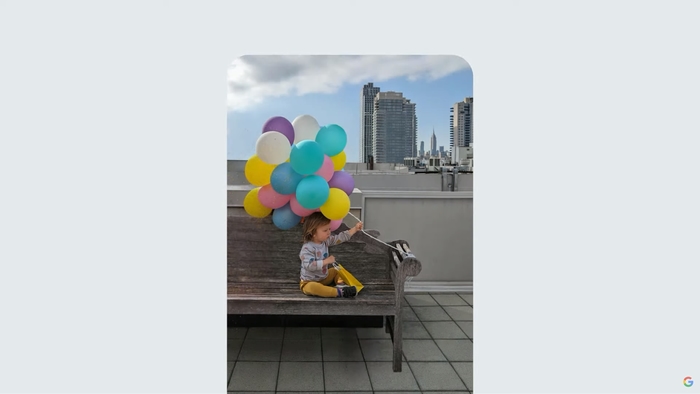

Google Photos

Почали про пошук в сервісі, наскільки він просунутий, що дозволяє шукати об’єкти, кольори, локації і т.п. Потім згадали про вже існуючу і чудово працюючу (позичену в Samsung) функцію видалення об’єктів на фото в редакторі додатку. І продовжуючи тему цієї інноваційної можливості - анонсували суперпросунутий редактор фото з допомогою ШІ під назвою “Мagic editor”, який буде також інтегрований у додаток Фото і запущений наприкінці року. Цей редактор сам в вміє редагувати фото, пересувати об’єкти на ньому, змінювати погоду і натуральне освітлення.

Він може навіть домальовувати фото для пересування об’єктів. При цьому можна налаштувати погоду, щоб освітлення виглядало натуральним.

PaLM 2 - нова версія мовної моделі

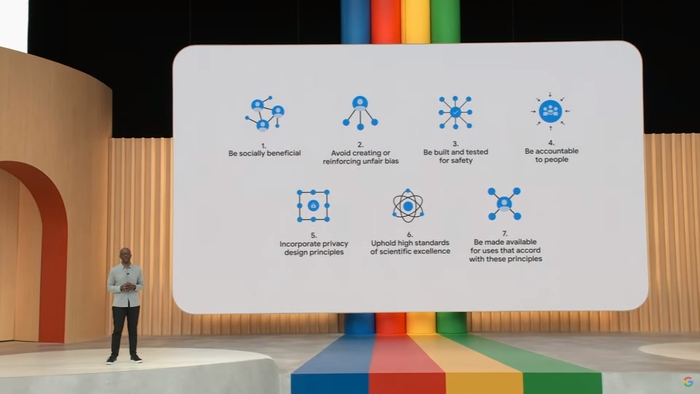

Компанія хоче розвивати ШІ для того, щоб він був доступний кожному, тому керуються даними принципами:

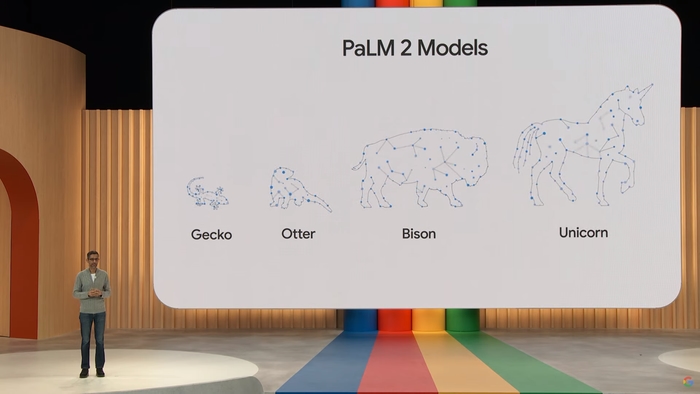

Власне озвучили анонс PaLM 2. На цьому я мало розуміюсь, але дали 4 моделі:

Серед підкреслених переваг те, що ця мовна модель розуміє більше 150 мов, може розпізнавати медичні запити і навіть має ліцензію на це.

Також, в Google об’єднали багато команд з розвитку різних аспектів ШІ в одну спільну для більш ефективного розвитку:

Розповіли про мультимодель Gemini, яка ще на дуже ранній стадії розробки. Вона дуже добре може створювати фотореалістичні зображення (обов’язково з водним знаком та метаданими про те, що це згенеровано штучним інтелектом, а не створено людиною).

Bard

Далі згадали про Bard. Він тепер працює повністю на PaLM 2.

Враховуючи, що дуже багато програмістів використовують зараз різні мовні моделі штучного інтелекту - наголосили на перевагах Барда в цьому.

Потім перейшли до прикладів. Відразу попереджу, що програміст з мене ніякий, тому тут я більше як суфлер буду.

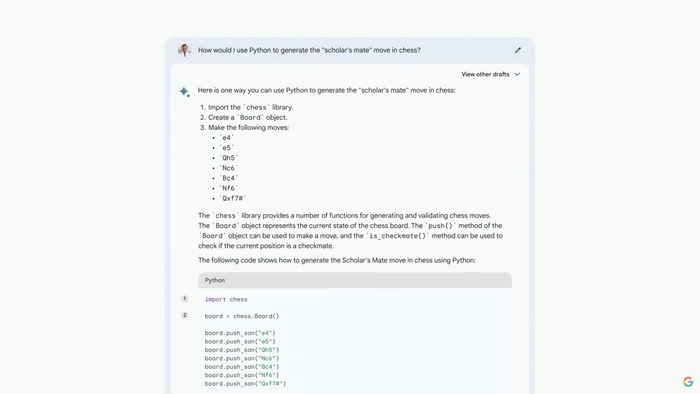

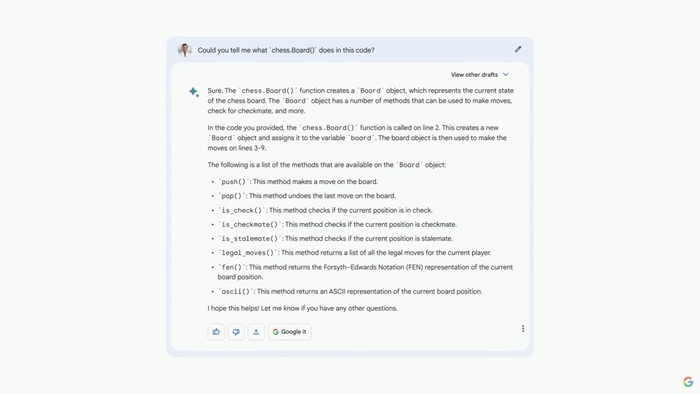

Для демо попросили згенерувати одну з дій в шахах на Python. Тут було наголошено на тому, що програмісти, які використовували цей інструмент в своїх задачах відзначили гарне форматування, багато цитат з джерелами, де можна подивитись, звідки Бард взяв той чи інший шматок коду, і в цілому отримав схвальні відгуки від спільноти цієї професії.

Далі перейшли до прикладу з поясненням коду.

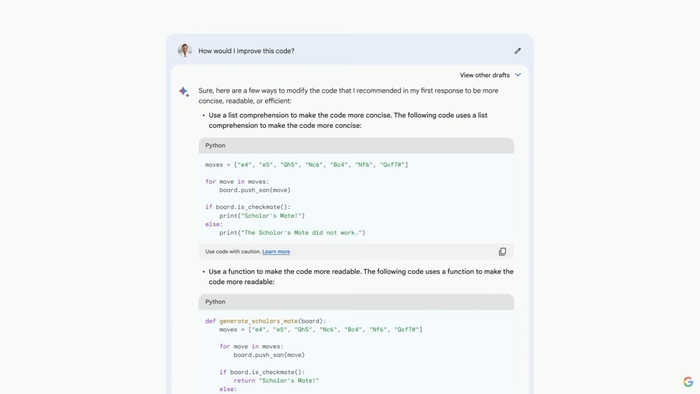

І прикладу з оптимізації коду.

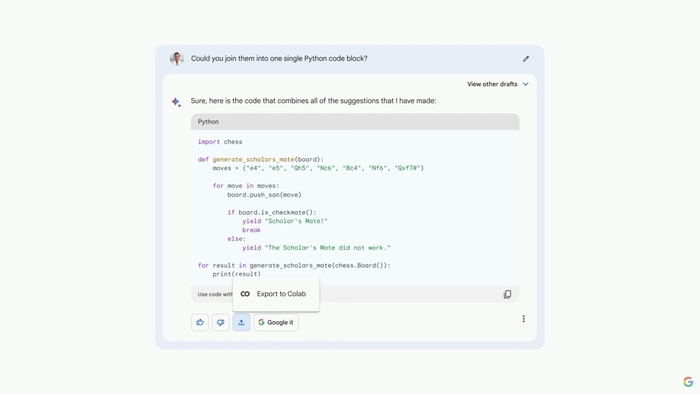

Для зручності в співпраці різних людей - в Бард інтегрували можливість експортувати код зразу в сервіси Colab/Explit.

А для того, щоб очам не було боляче (як на всій презентації) - додали в чат-бота темний режим.

Ще розповіли про штуку, котру назвали “Tools in Bard”. Звичайно, наголосили на безпеці і конфіденційності даних, які користувач надає Барду. Тож, серед тих “інструментів” - використання максимальної кількості доступних джерел даних для показу найактуальніших і правильних результатів.

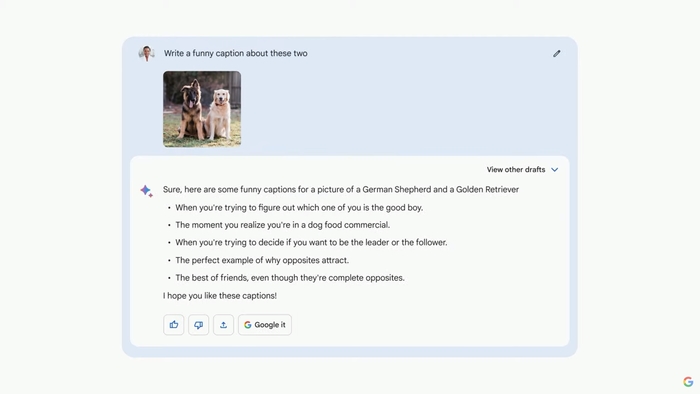

Також вміє розпізнавати живі і неживі об’єкти на фото (навіть тварин аж до породи).

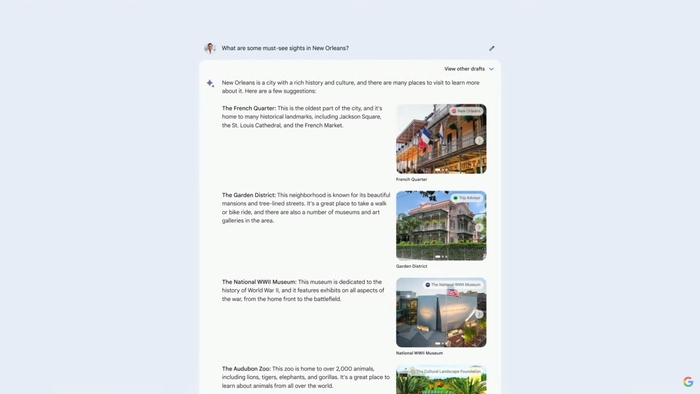

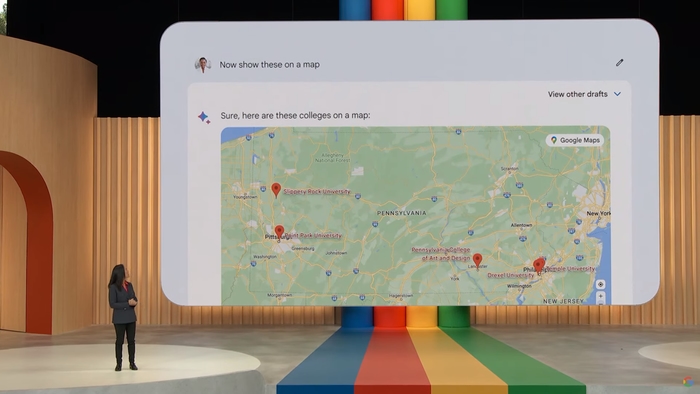

А ще - вміє візуалізувати локації на мапах.

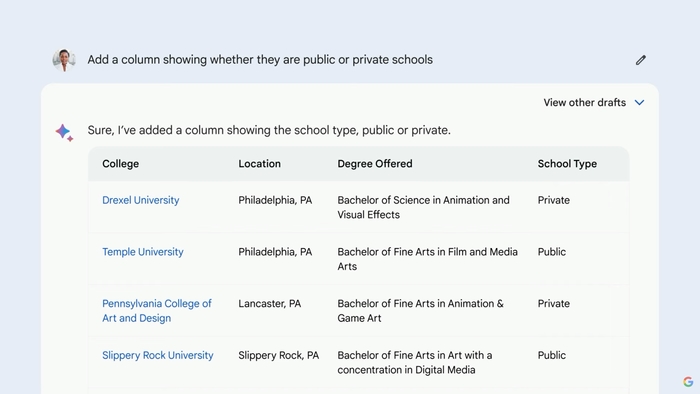

Якщо ж його попросити видати більш сортовані дані - він зможе відсортувати їх в таблицю і навіть експортувати її в Google Sheets.

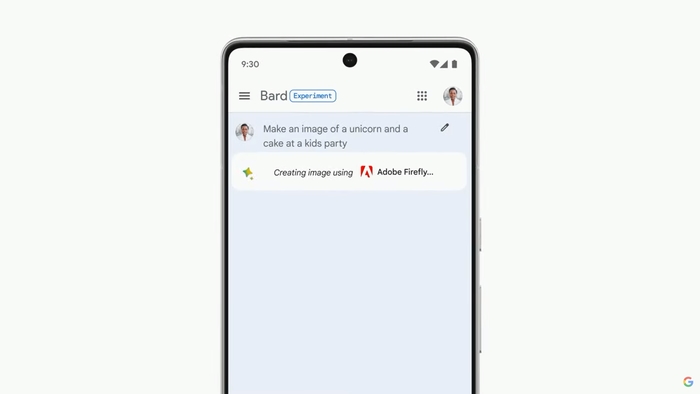

Розповіли ще й про співпрацю з Adobe. Їхній сервіс дає генерувати зображення в Барді напряму:

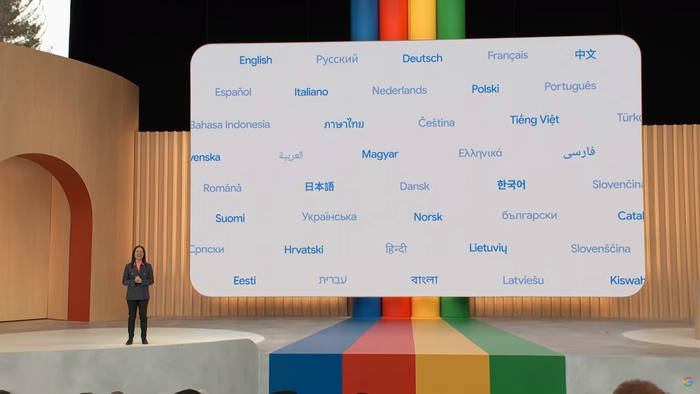

Сьогодні Бард стає доступним у 180+ країнах на інгліші, японській і корейській. Google також планують додати 40 мов найближчим часом (і навіть українську, якщо вірити зображенню).

Інтеграції ШІ в Google Workspace

Почали знову з Gmail, де розповіли, що попередньо показані оновлення вже почали тестувати в березні.

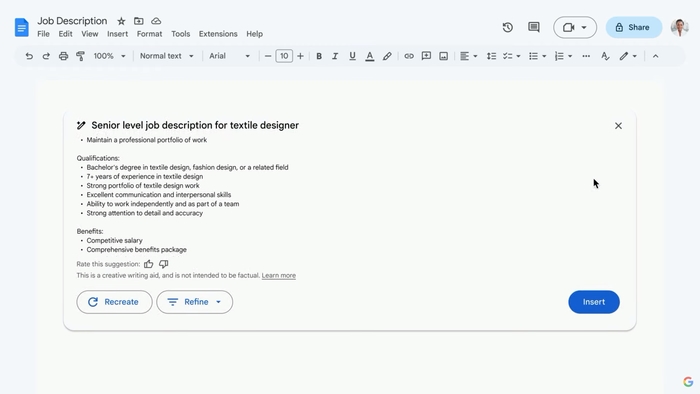

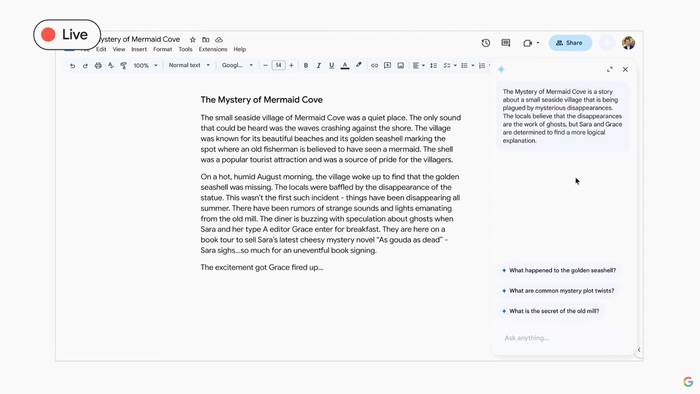

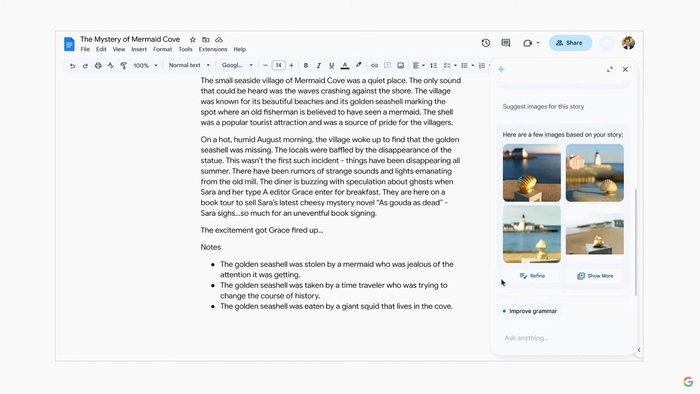

Google Docs

“Help me write” також приходить і в документи. Тут, як і в пошті, можна спокійно натиснути певну кнопку, написати ідею для тексту - і він буде згенерований повністю, і потім, очевидно, його тут же можна і відредагувати. Також, можна просити ШІ його “переробити”.

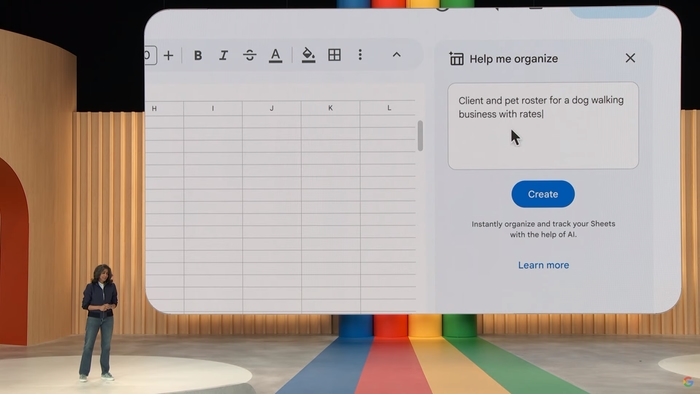

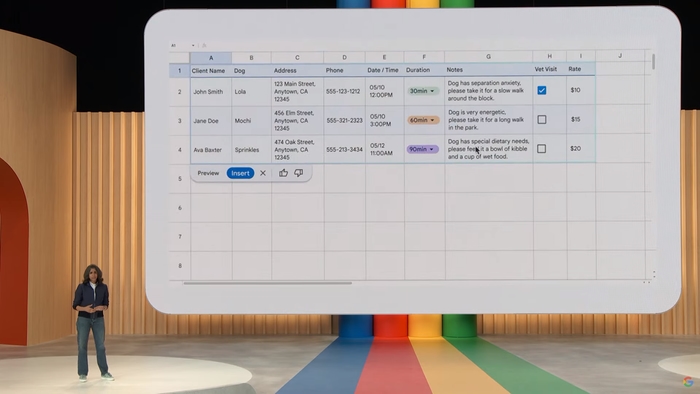

Google Sheets

Відразу перейшли до прикладів з логістикою.

Тут ШІ може згенерувати таблицю по запиту, з даними, котрі надасть користувач у вигляді простого повідомлення, і ця таблиця буде відформатована, з різними типами клітинок і т.п. Більше - на скріншотах нижче.

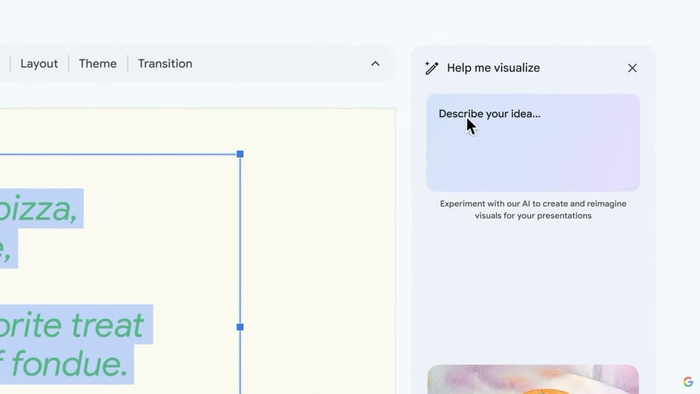

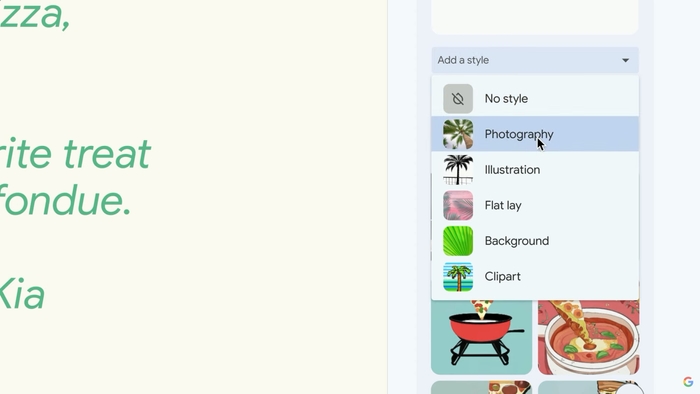

Google Slides

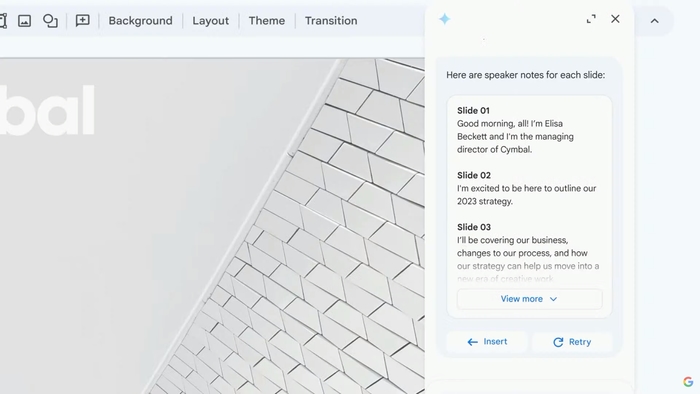

Тут також швиденько перейшли до демонстрації, і через те, що це інструмент для візуалізації того, про що розповідає автор - розповіли про генерацію зображення по опису і ще й в тему презентації.

Якщо потрібен інший стиль ілюстрацій (наприкд, більш “фотографічний”) - це легко змінюється.

Тестувальники зможуть “помацати” все це наступного місяця.

А от наприкінці року отримають всі користувачі в рамках проекту Duet AI for Workspace.

Взаємодія ШІ з користувачем

Далі розповіли про те, як ШІ може взаємодіяти з користувачем.

Наприклад - може щось пропонувати сам, навіть запити.

Для демонстрації показали, як у вже існуючому документі відкривають діалог з ШІ і він зразу пропонує запити по темі тексту в документі.

Також, тут працює і фішка з Слайдів - генерація ілюстрацій по темі документа.

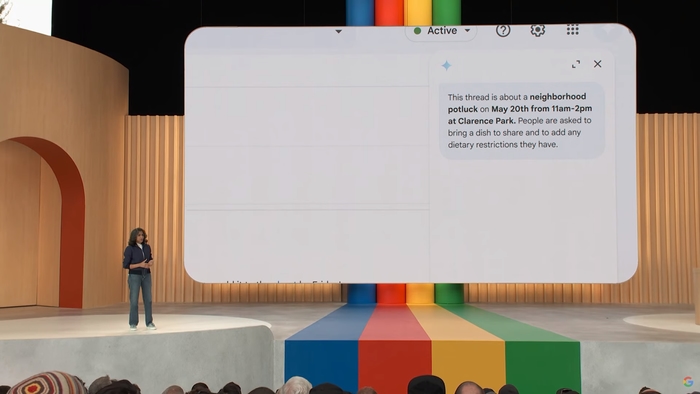

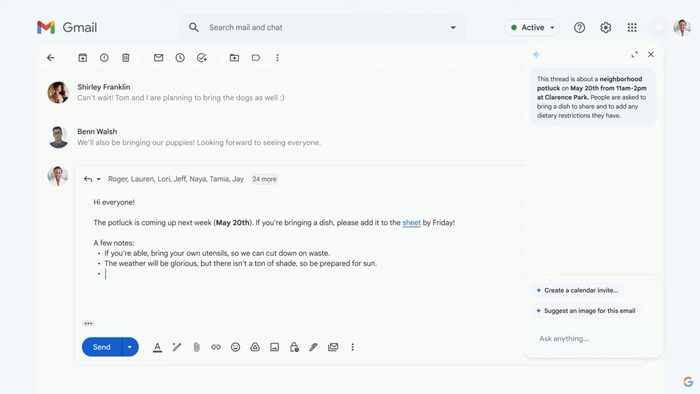

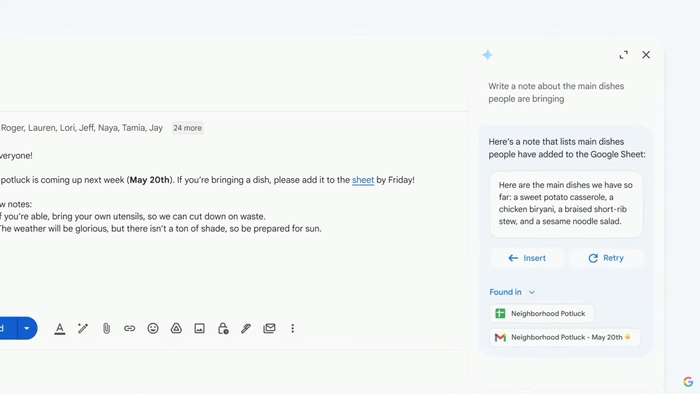

Можна попросити зробити короткий підсумок листа або довгої переписки…

… і попросити щось в контексті цього листа/переписки.

З дуже важливого для школярів/студентів/офісних працівників - можна згенерувати нотатки для кожного слайду! Тобто, зробивши презентацію - непотрібно писати окремий текст, який буде озвучувати людина, а можна його згенерувати автоматично.

Багато з цього можна отримати у вигляді “попереднього перегляду”, типу тестування, на яке можна записатись за посиланням google.com/labs.

Google Search

Наступною темою став пошук, найпопулярніший продукт гугла, де знов розповідали про інтеграцію ШІ.

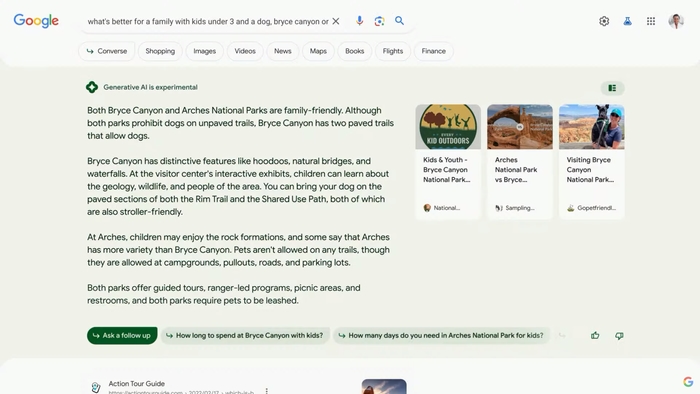

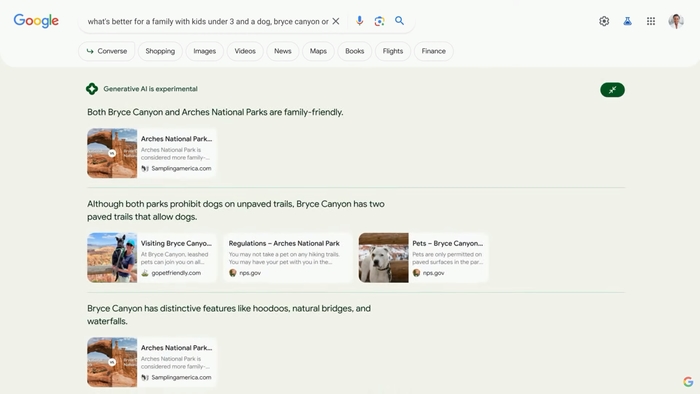

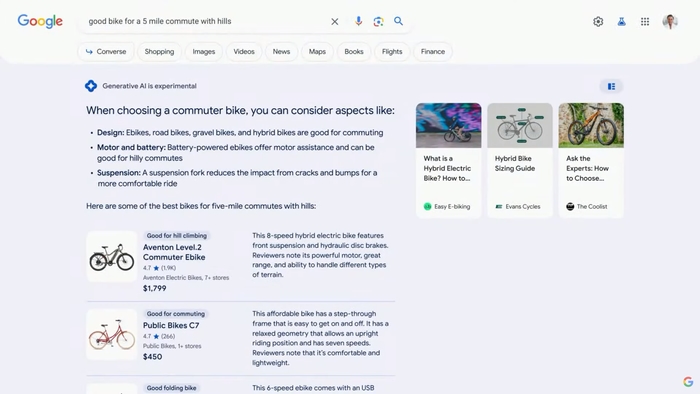

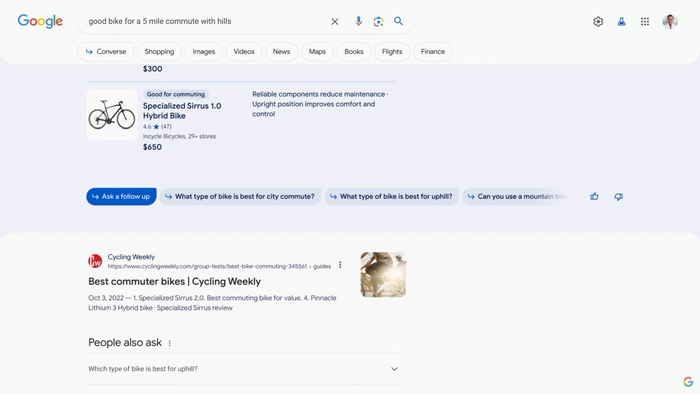

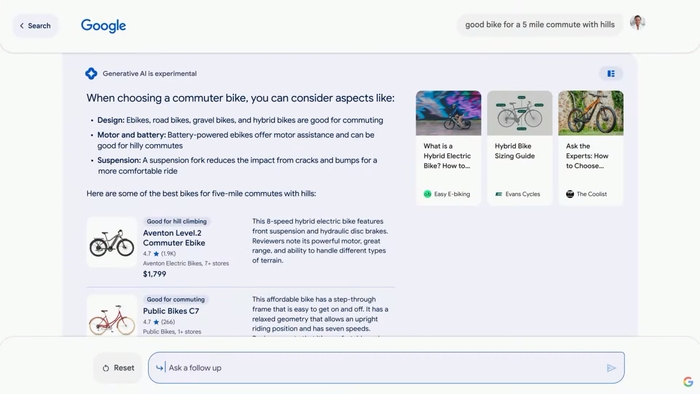

Показали новий дизайн пошукової видачі, де частина інформації згенерована ШІ в окремому розділі.

Можна розширяти цей розділ, щоб відобразити більше інформації, наданої за допомогою ШІ:

Перейшли до демо. Почали з вибору продуктів, в даном випадку - підбору велосипеда. Видача від ШІ має опис різних характеристик товару, приклади лотів у магазинах, де можна купити потрібну модель і інформацію по товарам.

Далі можна обирати запропоновані варіанти уточнюючих питань для пошукового запиту - і тебе перекине в чат-режим (наче інтеграція того ж Барда в пошук).

В ньому користувач все ще може листати пошукові результати, де буде навіть інформація про наявність в магазинах моделей, знижки і т.п. Цей новий функціонал працює і на мобільних пристроях.

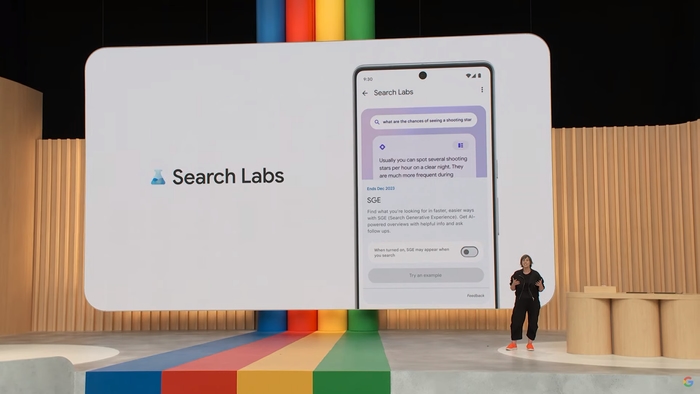

Для того, щоб це не лишилось лише у вигляді візуального демо - презентували програму Search Labs, де бажаючі можуть записатися на тестування різних експериментальних функцій у пошуку (включно з описаними вище).

Посилання для запису - g.co/Labs.

Як підсумок, суть змін в пошуку - ти реально можеш спілкуватись з пошуком, при цьому отримуючи як відповіді від ШІ, так і просто результати з інтернету, тобто є можливість мати і “живу розмову” і “сухі факти”.

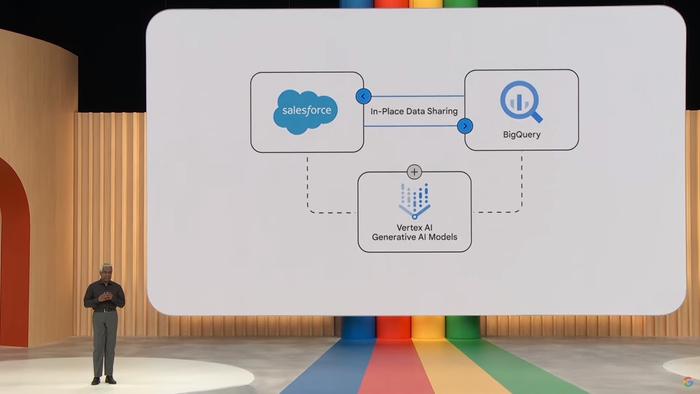

Google Cloud - бізнес штуки, в яких я не розуміюсь (вибачте)

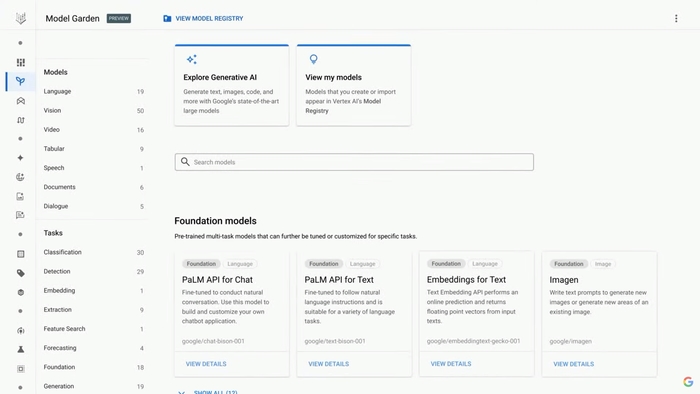

Почали з Vertex АІ.

Якщо я правильно зрозумів - це набір різних моделей штучних інтелектів, котрі можна інтегрувати в свої задачі, додатки і т.п., для використання потужностей Google і їхніх ШІ в межах своїх програм.

Вкотре наголошують (тепер вже для бізнесу), що все конфіденційно і т.п.

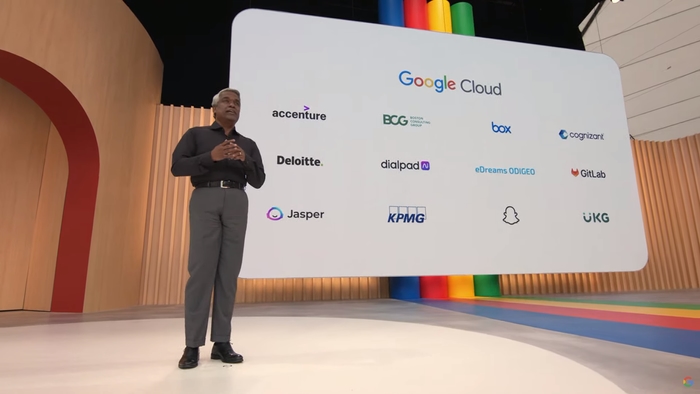

Показали і компанії та проекти, які вже працюють в Google Cloud з певними ШІ.

Ще представили три нові моделі ШІ для компаній.

Перша Imagen - вона дозволяє генерувати зображення.

Наступна - Codey. Ця може допомагати з генерацією і оптимізацією коду для програмістів.

І остання - Chirp. Вона вміє озвучувати текст.

Зараз всі ці моделі доступні в режимі “попереднього перегляду” для клієнтів Google Cloud.

На додачу - створили Duet AІ і тут, для колаборації з ШІ.

Зі сторони “заліза” - тепер хмарні сервіси пропонують нові сервери зі свіжою графікою від Nvidia - H100.

Також Google хочуть інтегрувати PaLM 2 в багато фреймворків, наприклад:

І вже інтегрували його в свої:

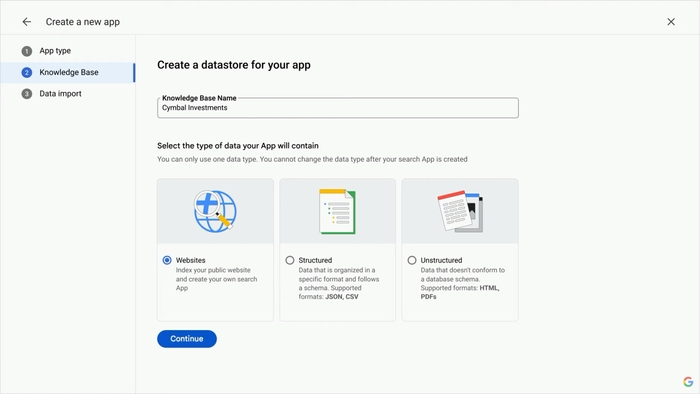

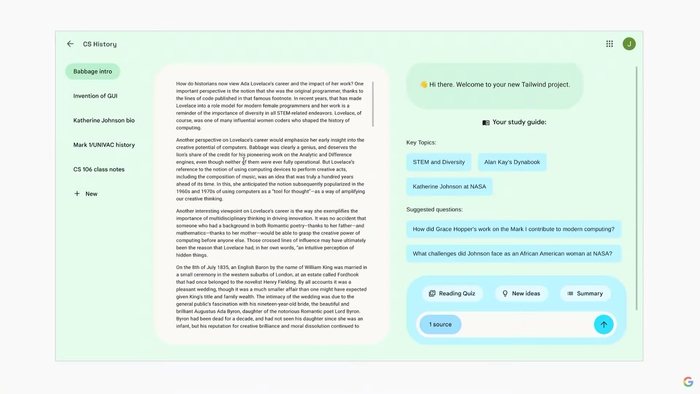

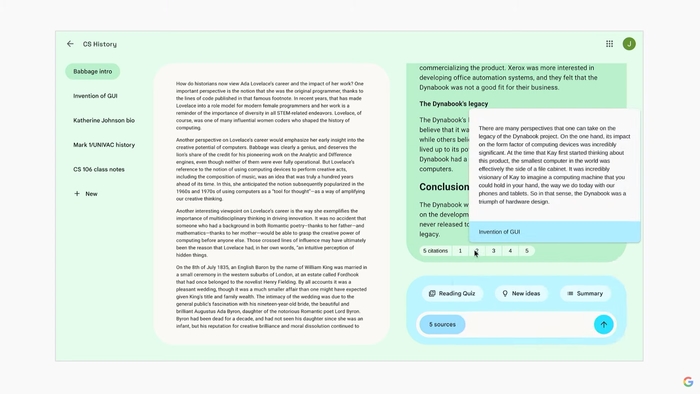

Далі показали свій проект на ранній стадії розробки Tailwind.

Ця штука є “нотатником для ШІ”, як приклад - він може взяти файли з хмарного сховища і заснувати свою модель ШІ на основі даних з цих файлів.

Є можливість взаємодії зі всіма файлами на диску. І ще - ШІ може цитувати джерела, які є файлами у хмарі.

Цей проект на дуже ранній стадії розробки, практично прототип, тому наразі виглядає базово. Але вже можна записатись на тестування там же, g.co/Labs .

Далі перейшли до того, що розповіли про те, як різні ШІ від Google допомогли впоратись з майже 400 мільйонами (!) років медичних досліджень за тижні.

Після цього розповіли про принципи побудови додатків з ШІ.

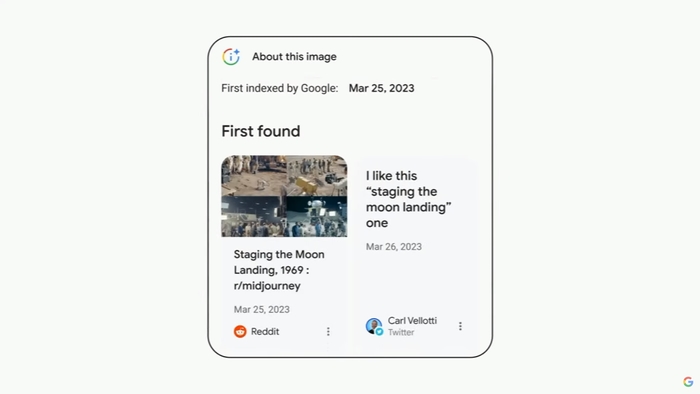

Через те, що далеко не всі ШІ і люди дотримуватимуться правил користування ШІ, видачі згенерованого контенту за реальний і т.п. - скоро нададуть можливість перевіряти зображення на “реальність”. В пошуку, наприклад, буде показуватись, де вперше з’явилось зображення, де згадувалось (типу новин) і інші подібні дані про нього:

Також цей функціонал додадуть і в Google Lens

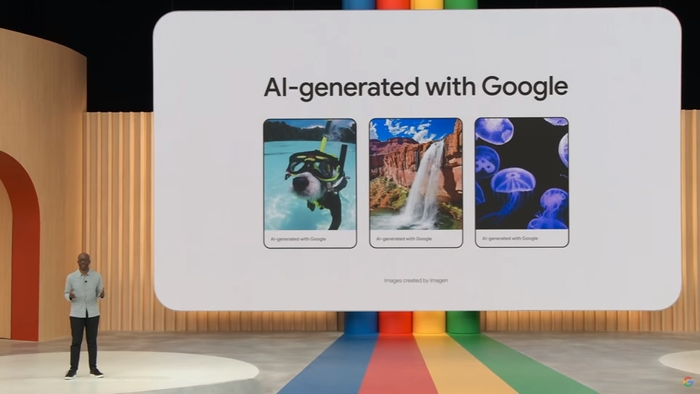

Google хочуть, щоб всі згенеровані ШІ зображення мали метадані про те шо вони саме створені, а не “реальні”, тому вони перші “подадуть приклад” і завжди маркуватимуть свої творіння як водним знаком, так і метаданими.

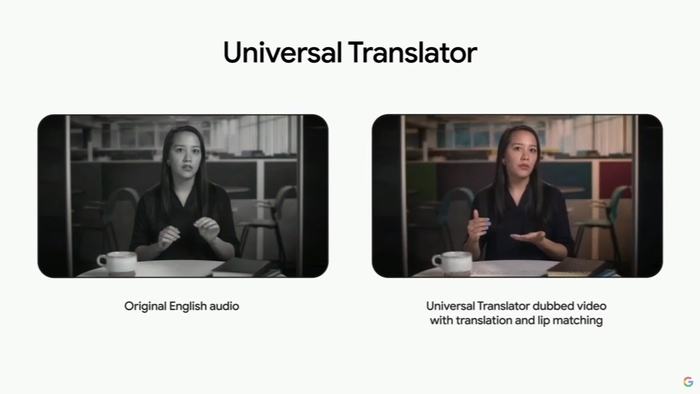

Далі показали одну з важливих, проте достатньо небезпечних технологій - “Universal Translator”.

Основне завдання сервісу - це переклад відео іншою мовою. Але не просто, як це робить перекладач, а саме перетворення всього відеоролика, що, окрім опціональних субтитрів включає озвучку бажаною мовою з емоціями і інтонаціями, а також - і це мене дуже вразило - з ліпсінком. Для довідки - це коли рух обличчя людини співпадає з озвученими словами, таке зараз роблять лише в іграх.

Але Google переймаються діпфейками. Для захисту від них вони також планують використовувати водні знаки і метадані.

Ще, в контексті розмови про безпеку персональних даних - наголосили, що кілька років тому відмовились від розпізнавання обличь для того, щоб не створювалась будь-яка база даних, яку зловмисники могли б використати (підозрюю, це був натяк на те, що після Pixel 4 вони більше не використовували функцію розпізнавання обличь, хоча в Google Photos вона є і працює чудово…)

Також сказали про те, що їхня модель “антитоксичності” для ШІ під назвою Perspective використовується практично всіма відомими ШІ, в т.ч. від OpenAI (ChatGPT).

Android

Відразу попереджу, що навіть номер нової версії ОС ніде не згадували.

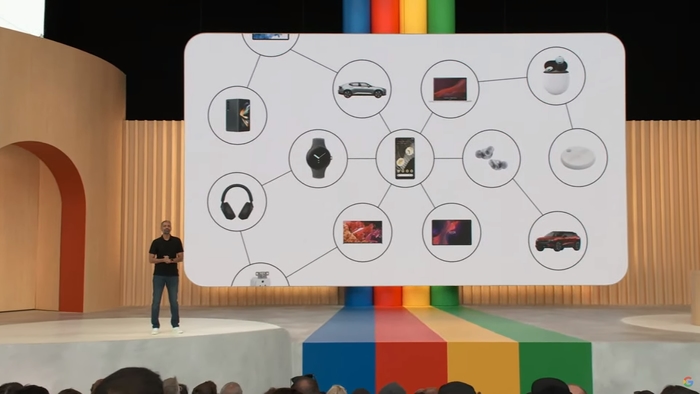

Розпочали з екосистеми і розповсюдженість ОС і її підтримки на максимально різноманітній кількості типів пристроїв - від навушників до автомобілів.

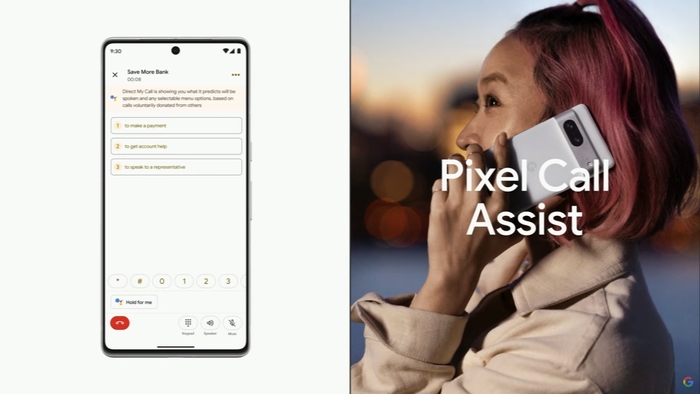

Також згадали про чудовий захист від спаму в повідомленнях і дзвінках.

І нагадали відомий факт - що це найбільш налаштовувана під користувача система.

Далі перейшли до суті.

Основний акцент відразу зробили на пристроях з великим екранами (тобто більшими за смартфони) і годинниках.

Першим показали, як виглядає двовіконний режим на великому екрані.

Також наголосили на тому, що оновили інтерфейси більшості своїх додатків для великих екранів і сприяли подібному розвитку сторонніх розробників.

Тепер про годинники.

Wear OS - розвивається найшвидше серед операційних систем для годинників. Цьому допомагає і швидкий ріст кількості активних пристроїв після виходу 3 версії.

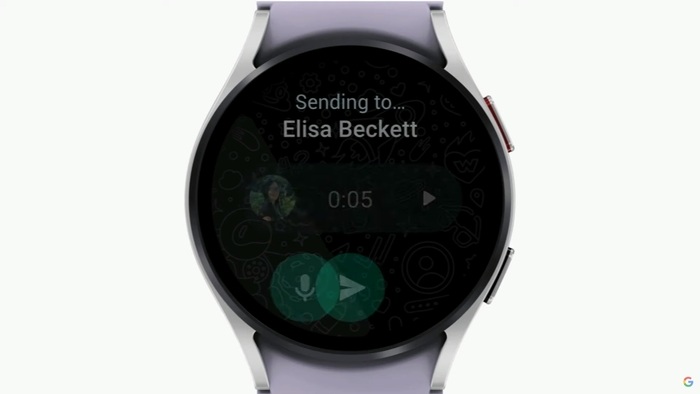

Для користувачів найпопулярнішого месенджера в світі - повідомили, що офіційний повнофункціональний клієнт вийде вже влітку. Там будуть і голосові повідомлення, і переписки.

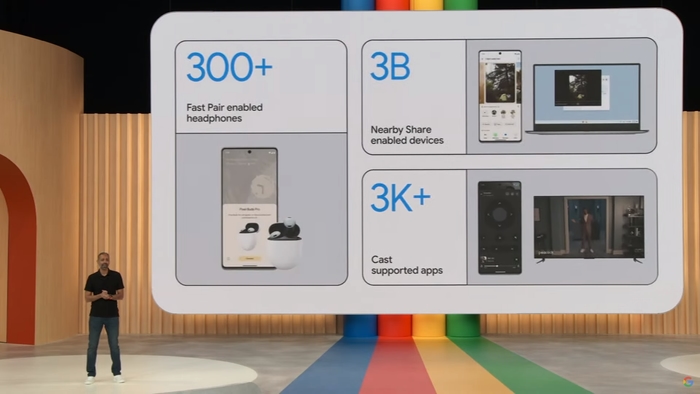

Потім нагадали про найпопулярніші і найвикористовуваніші технології в Android.

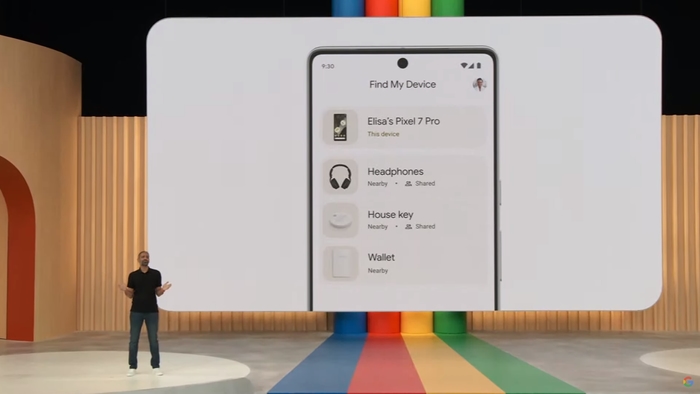

І розповіли про запуск нової версії сервісу “Find my device”, яка підтримуватиме більшість вже існуючих пристроїв.

Анонсували ще й вихід нових трекерів, які працюватимуть з цим сервісом.

Очевидно, що тут знову заговорили про безпеку. І у зв’язку з цим - повідомили, що “Find my device” автоматично шукатиме невідомі трекери навколо, щоб зловмисники не відслідковували людей, автомобілі і т.п.

Ця частина була створена в прямій співпраці з Apple і працюватиме з усіма трекерами, незалежно від виробника.

Заїде це вже влітку.

Перейшли до болючого питання багатьох західних користувачів (переважно із США) - RCS. Навіть випадково (мабуть, ні) озвучили гасло Nokia - Connecting people.

І дуже сильно наголошували на тому, що ця технологія має бути інтегрована в усі пристрої “незалежно від ОС”. Це був один з емоційних моментів, що глядачі аж заволали.

Я б теж дуже хотів це використовувати зі своїми друзями і знайомими, але… Телеграм поглинув всіх :(

Тепер почали про налаштування системи, в якому застосовується “generative AI”.

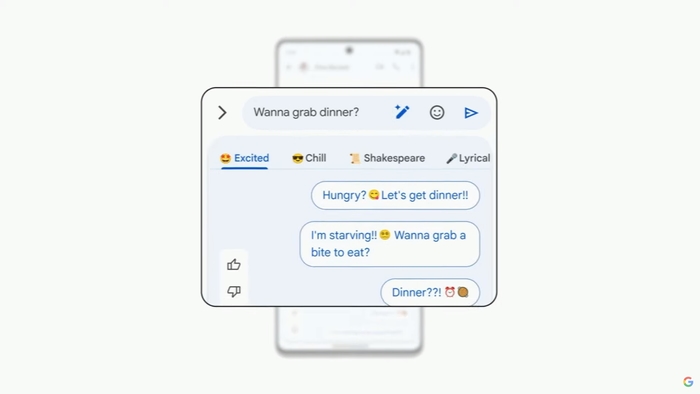

Перше, де показали цю інтеграцію знову були повідомлення. Тут можна написати відповідь, а потім попросити ШІ згенерувати її в різних стилях.

Далі перейшли до візуального налаштування.

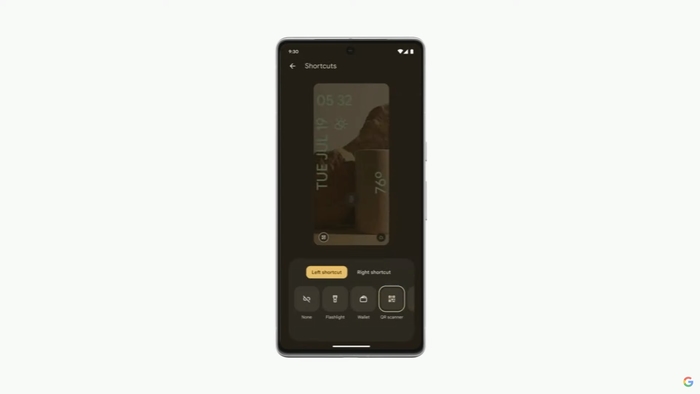

Додали можливість зміни стилю годинника на екрані блокування (так, для “чистого” Android - це новинка).

І навіть можливість зміни посилань там же.

Потім показали багато функцій, пов’язані зі шпалерами.

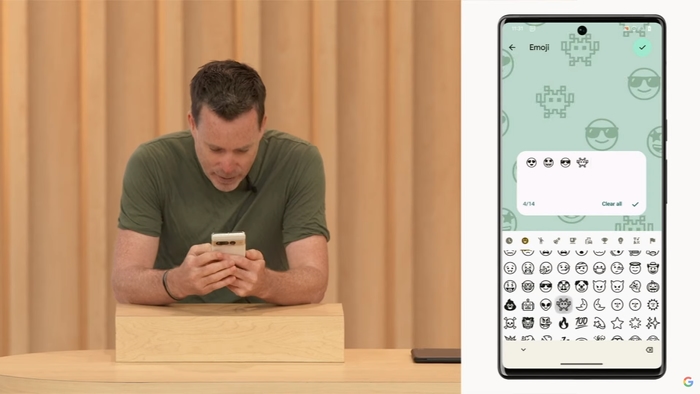

Наприклад, можна створювати шпалери з емоджі.

Емоджі навіть реагують, коли торкаєшся їх.

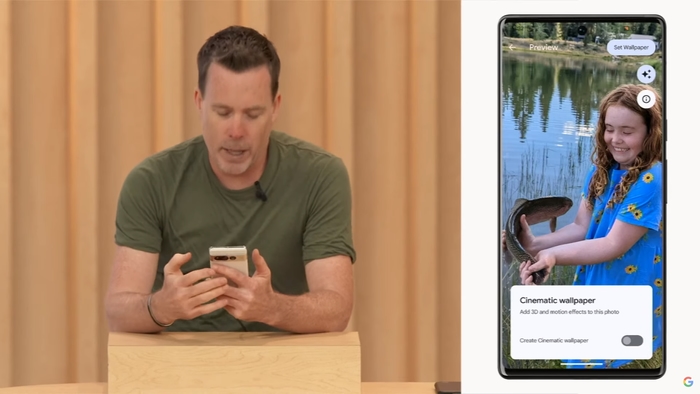

Ще один спосіб створення оригінальних шпалер - з фото, називається “Сinematic wallpaper”.

По факту - це інтеграція функції з популярних додатків минулого десятиліття, де можна поставити звичайне нерухоме фото як шпалеру, а смартфон сам зробить його рухомим в залежності від нахилу пристрою. Проте тепер це працює за допомогою ШІ, тобто не має бути так погано зробленим, як старими програмами.

На смартфони Google Pixel ці функції “прилетять” наступного місяця.

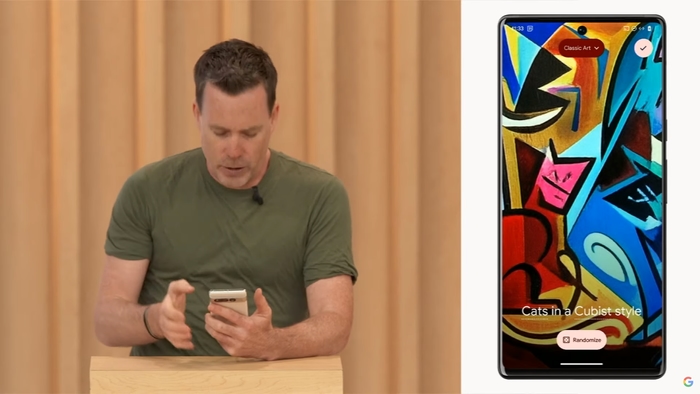

Далі показали безпосередню генерацію шпалер за допомогою ШІ. Береться якийсь приклад для стилю, і відштовхуючись від нього - створюється унікальна шпалера.

Це оновлення буде доступне всім цієї осені (якщо я правильно розумію - за допомогою додатку Google Wallpapers).

Google Pixel

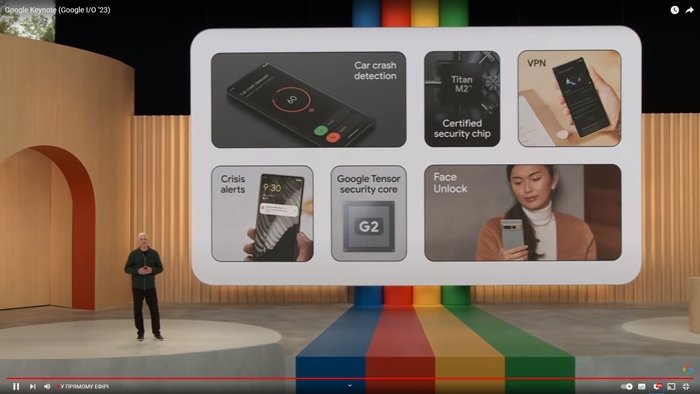

Через тему презентації - першим було наголошено на тому, що в Google Pixel стоїть ШІ прямо в пристроях, тобто такий собі “кишеньковий ШІ”.

Згадали також унікальні функції, які вже існують і працюють.

Тепер згадали технології камери.

Нагадали, що Google Pixel повністю зроблений в Google (на жаль…).

Згадали про вже анонсований сьогодні функціонал просунутого редагування фото і повідомили, що вони будуть доступні вже цього року саме на Pixel.

І перейшли до безпосередніх анонсів нових пристроїв.

Першим став Google Pixel 7a з тим же ЦП, що і лінійка Pixel 7.

Кольори, в яких він буде доступним: кораловий, блакитний, сіро-чорний і білий.

З важливих (для мене особисто теж) оновлень, окрім камери:

зменшився екран на 1мм (чомусь);

частота дисплею стала 90гц (нарешті в А серії);

ємність акумулятора зменшилась порівняно з минулим смартфоном і становить 4385 мАг;

додали бездротову зарядку (що теж величезний плюс для А серії);

стало більше ОЗП - тепер 8Гб;

основна камера, окрім фізичного збільшення - отримала роздільну здатність 64Мп (підозрюю, що в ній знімати неможливо стандартним додатком), 80 градусів огляду і ширину пікселя 0.8 мкм;

надширококутна камера підросла з 12 до 13Мп, а також отримала ще ширший кут огляду у 120 градусів, але зменшилась ширина пікселя до 1.12 мкм;

передня камера також прогресувала - тепер це 13Мп замість 8, і має ширший кут огляду в 95 градусів, проте менш світлочутливу апертуру в f/2.2 замість 2.0 у попередника.

Цей смартфон вже можна придбати.

Далі почали розповідати про “нові типи пристроїв”.

Очевидно, ними стали гнучкі смартфони і планшети.

Почали з останнього.

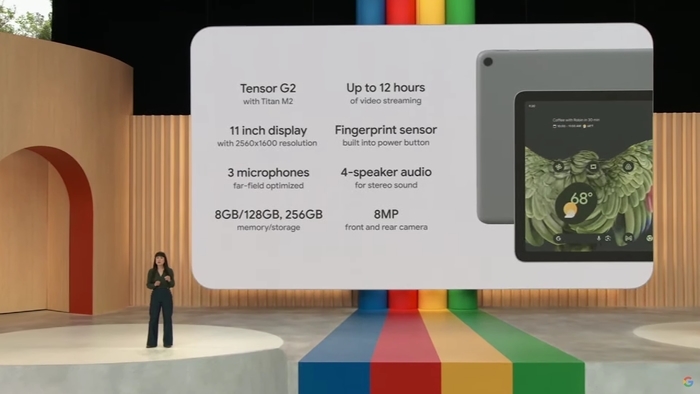

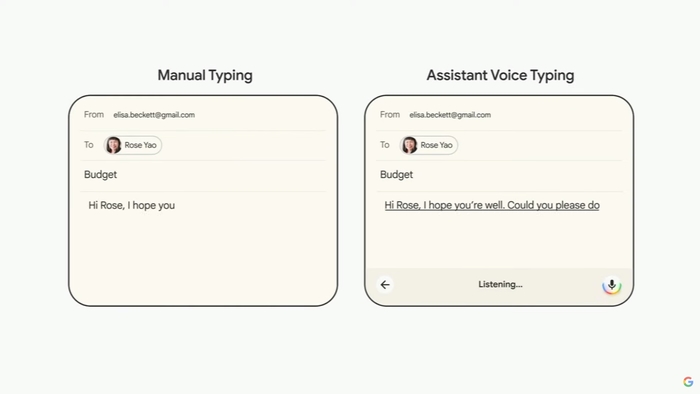

Від себе хочу зазначити, що я не очікував корпус з алюмінію, на минулорічних офіційних рендерах це виглядало як дешевий пластик. Також було сказано про оптимізацію під відеодзвінки. А ще, через незручність друку на планшеті, повідомили, що тут найкраще розпізнавання голосу для друку тексту.

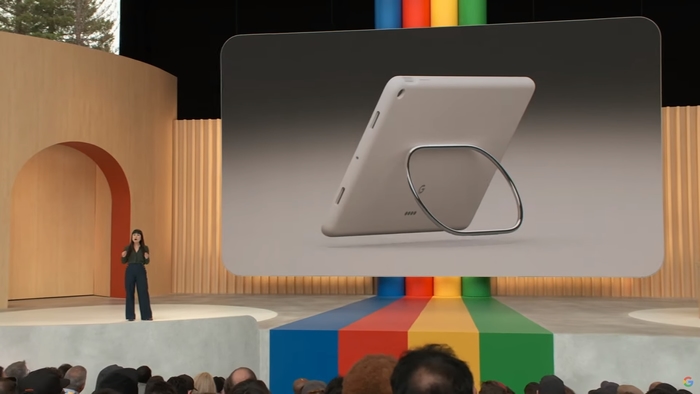

Додатково анонсували, як на мене, обов’язковий аксесуар - док з вбудованою колонкою. Від нього пристрій може заряджатись, а також працювати в якості Google Nest Hub, проте на повноцінній ОС.

Показали, що додають чудовий інтерфейс для керування розумним будинком через додаток Google Home (до речі, в тестовій версії дизайн вже такий, як було показано на презентації, користуюсь кілька днів).

Також, планшет підтримує кількох користувачів.

З цікавих технологій - це перший в світі планшет за всю історію, в який вбудували Chromecast, як в телевізор, тобто на нього можна “кастити” з інших пристроїв.

На додачу показали чохол з підставкою і можливістю встановлення планшета прямо в чохлі на док-станцію.

Продаватиметься він в трьох кольорах (білий, сірий і рожевий), продажі стартують 20 червня.

З інших характеристик планшета:

будуть версіх на 128 і 256Гб, в обох - 8Гб ОЗП;

батарея на 27Вт-год;

є сканер відбитків пальців;

передня камера (з усіма її технологіями) всього на 8Мп, задня - теж, обидві пишуть максимум 1080р відео в 30 к/с;

має 4 динаміки;

не має версії з підтримкою SIM-карток;

не має GPS (з інших бездротових технологій - Wi-Fi 6, BT 5.2, UWB і Google Chromecast Built-In);

док може заряджати максимум на швидкості до 15Вт (що дуже сумно);

дротова зарядка має максимальну швидкість у 27Вт (що теж сумно для планшета).

А останнім показали найочікуваніший - гнучкий Google Pixel Fold.

Було наголошено на тому, що згинання тестували як тільки могли, а також - на наявності захисту від води. Звичайно, камера теж є однією з основних плюшок.

Анонсували функцію спеціально для гнучкого Pixel - переклад на двох екранах одночасно, щоб можна було спілкуватись “наживо”, під назвою “Dual Screen Interpreter Mode”.

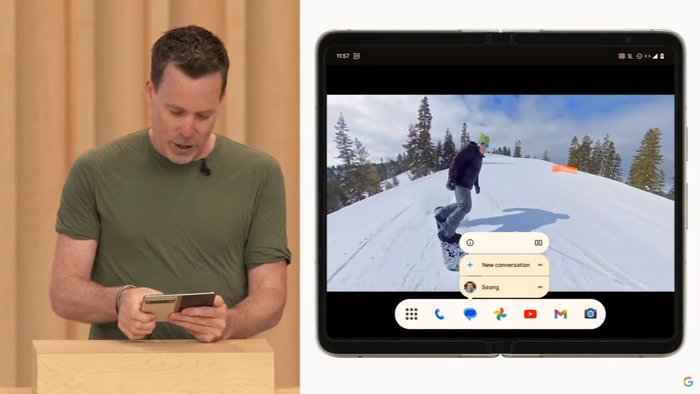

Перейшли далі до оновлень по програмній частині для гнучких пристроїв.

З особистих нотаток - багато чого запозичено у Samsung One UI, по типу шпалер, автоматичного запуску додатків з зовнішнього на внутрішньому екрані. Також робота з багатозадачністю схожа на самсунгівську, але не така сама.

Також переробили шторку.

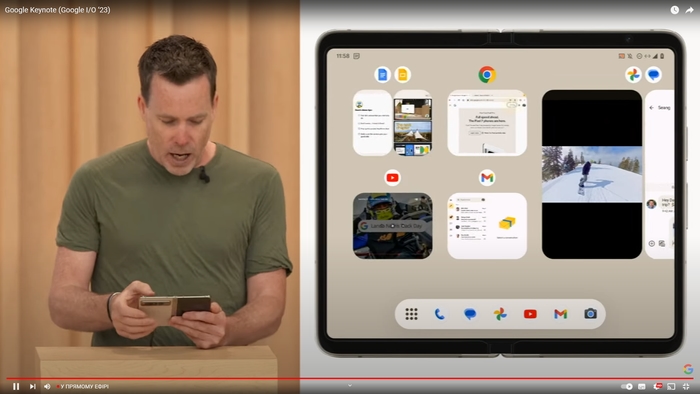

Ще трохи передизайнили багатозадлачність, для підтримки пар додатків.

І, що важливо, зробили режим розділеної клавіатури для зручного друку на великому екрані.

Для камери додали багато функцій, запозичених у тих же Samsung, як то використання напівзігнутого режиму як підставки, селфі на основну камеру за допомогою зовнішнього екрану і т.п.

Кольори, в яких буде представлений апарат - чорний та білий.

А далі показали ціну.

Почнуть відправляти замовлення вже у червні.

З важливих моментів по характеристикам:

зовнішній екран достатньо широкий, що зручніше ніж лінійка гнучких смартфонів від Samsung;

рамки внутрішнього дисплея просто кошмарні як на рендерах, так і на демо з презентації, це серйозна проблема для продажів буде, за наявності відточеного Galaxy Fold4 і купи китайських аналогів;

шарнір стальний;

ємність акумулятора мінімальна 4727мАг, а типова - 4821мАг, що більше за конкурента від Samsung, хоч з Tensor G2 на борту це може і не врятувати;

максимальна швидкість дротової зарядки - 30Вт;

варіанти накопичувача - 256 та 512Гб, ОЗП завжди 12Гб;

основний модуль камери - на 48Мп, з апертурою f/1.7 і всіма плюшками з Pixel 7 Pro по її “залізу”, ширина пікселя 0.8мкм, кут огляду - 82 градуси;

надширококутний модуль камери - на 10.8Мп, з апертурою f/2.2, кутом огляду 121.1 градус і шириною пікселя 1.25мкм;

телеоб’єктив - на 10.8Мп з 5-кратним оптичним наближенням, має апертуру f/3.05, кут огляду 21.9 градуса і ширину пікселя 1.22мкм;

фронтальна камера під зовнішнім дисплеєм має роздільну здатність 9.5Мп, світлосилу f/2.2, кут огляду 84 градуси і ширину пікселя 1.22мкм (дуже дивно, що такі слабенькі характеристики у зовнішньої фронталки);

внутрішня фронталка - це вже 8Мп, апертура f/2.2, 84 градуси огляду і ширина пікселя 1.12мкм.

Висновки

Google дуже сильно відштовхувались від ШІ на презентації, не намагаючись навіть пояснити, чи потрібно воно користувачам, чи ні, при цьому зосередившись на купі технічних термінів, хоча завжди звичайний Keynote був заходом для журналістів і звичайних користувачів. Через це презентація вийшла в більшій частині - нудною, але з проблисками чудових технологій, що ховаються за стінами компанії і її складних спікерів. Щодо пристроїв - особисто мене вразив лише планшет і то завдяки док-станції та вбудованому Chromecast, що робить його, по суті, послідовником маленьких кухонних телевізорів, тільки тепер з повноцінною ОС і можливістю пересуватись по квартирі. Гнучкий смартфон - як Pixel 7a - був злитий задовго до презентації, а за пару днів ще й показаний самою компанією в соц.мережах. І він не вражає, якщо не сказати грубіше. Внутрішній дисплей з такими рамками за наявності всіх інших конкурентів без них - це вже жирний мінус, не кажучи вже про те, що автономність з “фірмовим” процесором буде бажати кращого ще більше, ніж навіть у Pixel 7 Pro. А стосовно Pixel 7a - це, мабуть, той смартфон, який би я міг порадити всім підряд, незалежно від вимог, якщо немає якоїсь функції, через яку смартфон і шукають. Він відносно недорогий, вже має практично всі флагманські функції (окрім телефото камери, але це вже було б занадто), і матиме оновлення навіть довше за флагман цього ж покоління.

Така от вийшла презентація, сподіваюсь, ви отримали якусь корисну інформацію звідси.

Бувайте!