Більше новин та корисного в знайдете в нашому телеграм каналі TechTooday UA

Багато хто обговорює DeepSeek R-1 — нову мовну модель з відкритим вихідним кодом, розроблену китайською компанією DeepSeek, яка спеціалізується на штучному інтелекті. Деякі користувачі стверджують, що за можливостями логічного міркування вона не поступається, а навіть перевершує модель o1 від OpenAI.

Наразі DeepSeek R-1 доступна безкоштовно, що є чудовою новиною для користувачів, але водночас викликає певні питання. Як компанія впорається з витратами на сервери при такому стрімкому зростанні кількості користувачів? Адже експлуатаційні витрати на обладнання не можуть бути низькими, чи не так?

Найбільш логічна відповідь тут — це дані. Дані є основним джерелом живлення для моделей штучного інтелекту. Ймовірно, компанія збирає інформацію про користувачів, щоб згодом використати її для монетизації своєї моделі. Тому, якщо ви турбуєтеся про конфіденційність своїх даних, але все ж хочете скористатися R1, найкращий спосіб — запустити модель локально на своєму пристрої.

Що таке DeepSeek R-1?

Кілька днів тому була представлена модель DeepSeek R-1 з відкритим вихідним кодом. Це означає, що будь-хто може взяти базовий код, адаптувати його та навіть вдосконалити для власних потреб.

З технічної точки зору, DeepSeek R-1 (часто скорочено називають R1) базується на великій базовій моделі під назвою DeepSeek-V3. Потім лабораторія вдосконалила цю модель за допомогою комбінації контрольованого налаштування (SFT) на високоякісних даних, розмічених людьми, та навчання з підкріпленням (RL).

В результаті отримали чат-бота, який здатний обробляти складні запити, розкривати логіку складних питань (іноді навіть більш прозоро, ніж інші моделі), а також відображати код у інтерфейсі чату для швидкого тестування.

Чесно кажучи, це дуже вражає, особливо для моделі з відкритим вихідним кодом.

Як запустити DeepSeek R-1 локально

Для локального запуску DeepSeek R-1 ми будем використовувати інструмент під назвою Ollama.

Ollama — це безкоштовний інструмент з відкритим вихідним кодом, який дозволяє користувачам запускати великі мовні моделі (LLM) локально на своїх комп’ютерах. Він доступний для macOS, Linux та Windows.

Щоб почати, виконайте наступні кроки:

Перейдіть на офіційний сайт Ollama: ollama.ai.

Натисніть кнопку «Download» (Завантажити).

Завантажте та встановіть Ollama на свій комп’ютер.

Після встановлення ви зможете використовувати Ollama для запуску DeepSeek R-1 або інших мовних моделей локально, без необхідності підключатися до хмарних сервісів. Це дозволяє зберегти конфіденційність даних і працювати з моделлю на власному обладнанні.

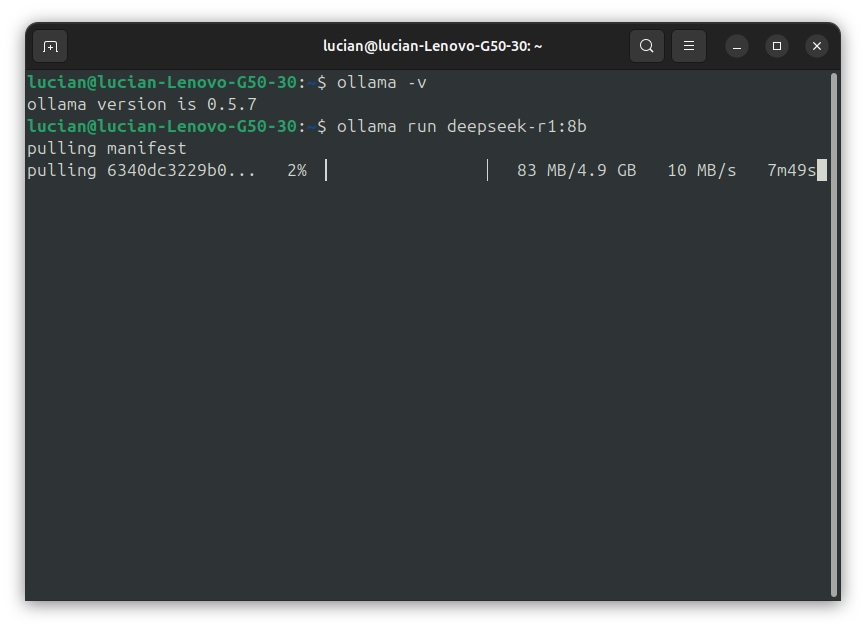

Щоб переконатися, що установка пройшла успішно, відкрийте термінал та виконайте наступну команду:

ollama -v

Замість помилки ви маєте побачити номер версії Ollama.

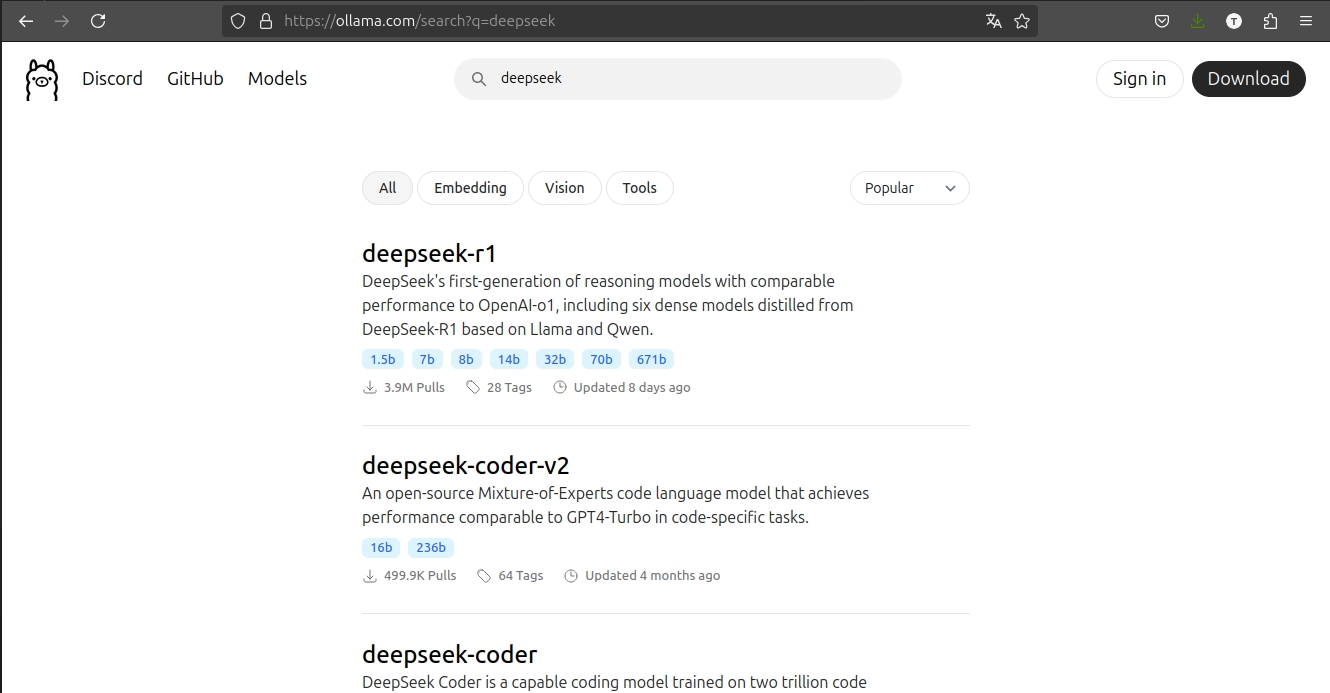

На вкладці Models виконайте пошук за ключовим словом "deepseek", і ви повинні побачити "deepseek-r1" у першому пункті списку пошуку.

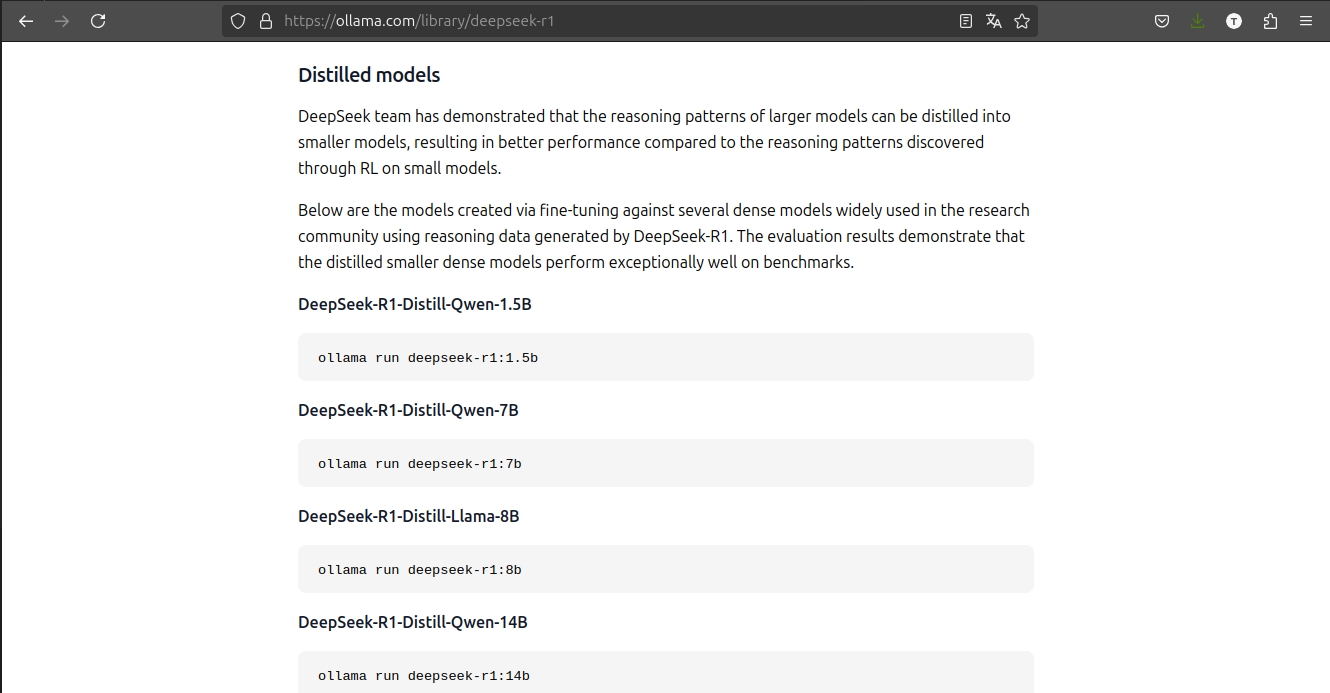

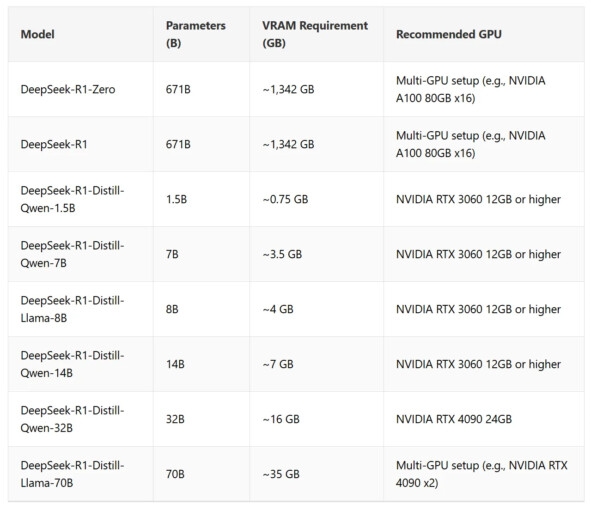

Клацніть на неї і перейдіть до розділу Models (Моделі), де ви побачите кілька розмірів моделей - від 1,5 мільярда до 671 мільярда параметрів. Як правило, для запуску великих моделей потрібні потужніші графічні процесори.

Невеликі моделі, такі як версія з 8 мільярдами параметрів можуть працювати з графічними процесорами з 8 ГБ відеопам'яті. Більші моделі вимагають значно більше ресурсів (див. розділ «Вимоги до VRAM та GPU» нижче).

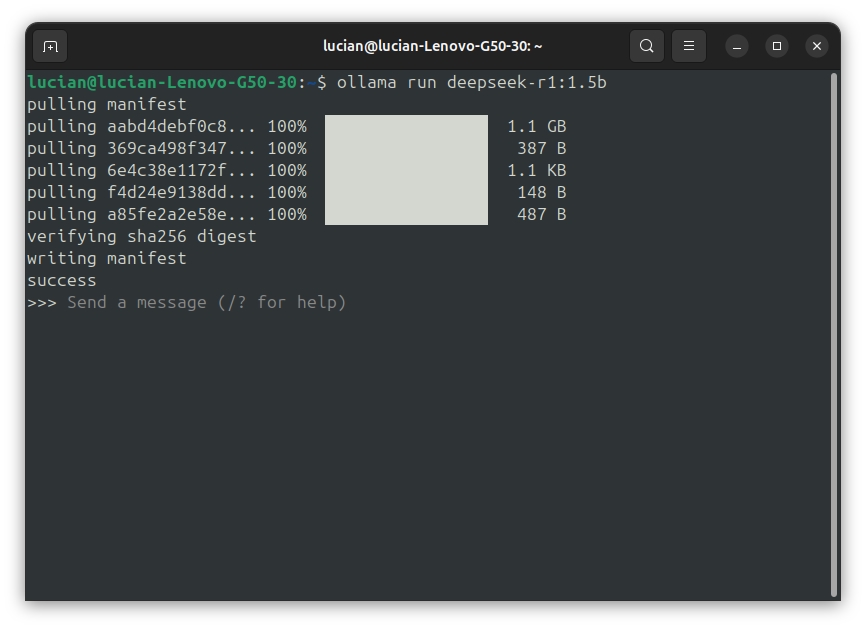

Щоб завантажити та запустити модель з 8 мільярдами параметрів, виконайте таку команду:

ollama run deepseek-r1:8bПочнеться завантаження моделі (близько 4,9 ГБ). Переконайтеся, що ви маєте достатньо місця на диску, перш ніж приступати до роботи.

Після завантаження модель буде запущена локально на комп'ютері. Ви відразу зможете спілкуватися з нею.

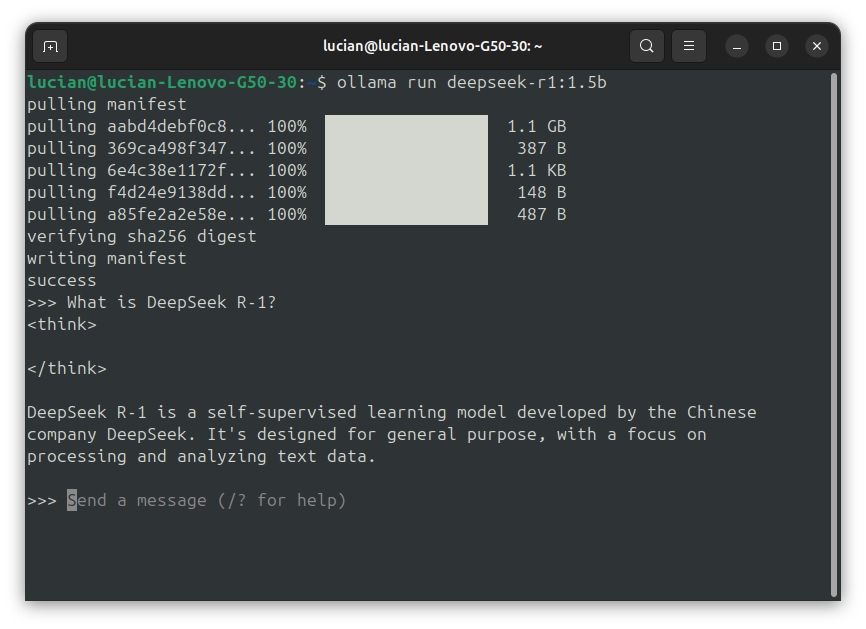

Давайте протестуємо її на прикладі цього промпту:

Промт: What is DeepSeek R-1?

Відповідь: DeepSeek R-1 is a self-supervised learning model developed by the Chinese company DeepSeek. It's designed for general purpose, with a focus on processing and analyzing text data.

Інші можливості Ollama:

Локальний запуск LLM, включаючи моделі LLaMA2, Phi 4, Mistral та Gemma 2.

Створення власних LLM та обмін ними між користувачами.

Об’єднання ваг моделей, конфігурації та даних в один пакет для зручності використання.

Оптимізація процесу встановлення та налаштування, включаючи підтримку GPU для підвищення продуктивності.

Вимоги до GPU та VRAM

Вимоги до обсягу відеопам’яті (VRAM) для DeepSeek-R1 залежать від таких факторів, як розмір моделі, кількість параметрів та методи квантування. Ось основні моменти:

Розподілена настройка GPU для великих моделей. Запуск моделей DeepSeek-R1-Zero та DeepSeek-R1 вимагає значного обсягу VRAM, тому для оптимальної продуктивності рекомендується використовувати розподілені конфігурації GPU (наприклад, NVIDIA A100 або H100 у системах з кількома GPU).

Сумісність з одним GPU для дистильованих моделей. Дистильовані моделі оптимізовані для роботи на одному GPU з меншим обсягом VRAM, починаючи від 0,7 ГБ.

Додаткове використання пам’яті. Додаткова пам’ять може використовуватися для активацій, буферів та задач пакетної обробки.

Чому варто запускати DeepSeek R-1 локально?

Хоча веб-чатбот та мобільний додаток DeepSeek є безкоштовними та зручними, локальний запуск моделі має свої переваги:

1. Конфіденційність:

- При використанні веб-версії або додатку ваші запити та файли відправляються на сервери DeepSeek. Що відбувається з цими даними — невідомо. Локальний запуск гарантує, що ваші дані залишаються на вашому пристрої.

2. Офлайн-доступ:

- Ви можете використовувати модель без підключення до Інтернету, що ідеально підходить для подорожей або роботи в умовах нестабільного Wi-Fi.

3. Захист від майбутньої монетизації:

- Наразі DeepSeek безкоштовний, але в майбутньому компанія може ввести платні послуги або обмеження. Локальний запуск дозволяє уникнути цих обмежень.

4. Гнучкість:

- Ви можете адаптувати модель під свої потреби, інтегрувати її з іншими інструментами або створити власний інтерфейс.

Коли краще використовувати веб-додаток або мобільну версію?

Якщо конфіденційність даних не є вашим основним занепокоєнням, веб-додаток або мобільна версія будуть зручнішими. Вони вже мають вбудовані функції, такі як DeepThink та веб-пошук, і не вимагають додаткового налаштування.

Підсумок

Моделі DeepSeek розроблені так, щоб добре працювати навіть на не дуже потужному обладнанні. Великі моделі, такі як **DeepSeek-R1-Zero**, вимагають розподілених GPU, але дистильовані версії дозволяють комфортно працювати на одному графічному процесорі з мінімальними вимогами.

Якщо ви не любите працювати з терміналом, ви можете додати простий інтерфейс за допомогою інструментів, таких як Gradio або Chatbox AI. У наступній статті я розповім, як їх налаштувати.

Сподіваюся, ця інформація допоможе вам розпочати роботу з DeepSeek R-1. Діліться своїми думками в коментарях, і якщо ви зіткнулися з труднощами, не соромтеся розповісти про них! 😊