Пару років тому я топив за "метаверс" і трішки притоплював за "крипту". Час показав, що мої очікування були, м'яко кажучи, надто оптимістичними. Сподіваюсь, урок засвоїв.

Зараз розігрівається "нова тема" - штучний інтелект та великі мовні моделі. Важко хоча б день прожити й не натрапити на якісь гучні заголовки. Ще важче не піддатися їхньому впливу.

Я вже робив кілька “теплих“ публікацій про ШІ (1, 2, 3) та вважаю за потрібне врівноважити баланс у Всесвіті критичним поглядом або “ложкою дьогтю”.

І хто як не Адам, який "руйнує все", нам з цим допоможе! Пам’ятаєте, було таке шоу? Його можна назвати радикальною версією “Клятого раціоналіста”. Шоу вже закрилось, але Адам продовжує “руйнувати все” на своєму Youtube-каналі та займаючись стендапом.

Нещодавно вийшло його відео про “Штучний інтелект”. Адам доводить, що більшість з того, що ми чуємо про розвиток ШІ сьогодні — всього лише вправна робота маркетологів, яка часто приховує “незручну правду”.

Я не втримався і зробив його текстову версію, але якщо ви товаришуєте з англійською — раджу подивитись відео, не пожалкуєте.

У штучного інтелекту був чудернацький місяць. Нова пошукова система Bing зі штучним інтелектом почала ображати своїх користувачів дужче, ніж бойфренд-абьюзер. Акції Google втратили 100 мільярдів доларів після того, як їхній новий чат-бот зі штучним інтелектом припустився настільки очевидних помилок, що навіть простий пошук у Google виявив би їх. Але, попри цей величезний провал, Google оголосив, що планує додавати ШІ у кожен продукт, який вони виробляють, як сир у меню піцерії “Піца Хат”. І вони в цьому не єдині.

Технологічні компанії навипередки обіцяють використовувати ШІ, щоб “революціонізувати” все — від комп’ютерного програмування до обслуговування клієнтів і терапії.

Тож не дивуйтеся, коли за пару років ШІ-відділ виставлення рахунків вашої страхової буде відмовляти вам у зверненні до ШІ-терапевта, який працює за вашим медичним полісом.

Нас очікує до біса відстійне майбутнє.

Все це змушує людей перейматися, що суперрозумний ШІ вже близько, що роботи переможуть, Skynet існує, і він йде за нами!

І вгадайте що? Це все — лайно собаче! Цей страх — фантазія технарів, яка створена, щоб відвернути вас від реальної загрози ШІ. Купка недолугих компаній брешуть про те, на що здатна їхня недолуга технологія, щоб обдурити вас і змусити використовувати гіршу версію того, що у нас вже є, і щоб зробити це, вони крадуть роботу реальних людей.

При написанні цього матеріалу не використовувався штучний інтелект, і саме ваші донати дають мені час, необхідний для створення жартів моїм м’яким людським мозком, а потім для друкування їх моїми маленькими м’ясними пальцями. Тож заходьте на patreon.com/adamconover і “Підтримайте Людину” вже сьогодні!

Штучний інтелект — це справжня галузь комп’ютерних наук, яка вивчається десятиліттями. І в останні роки вона досягла значних успіхів. Але я говорю не про цей вид ШІ.

Я говорю про маркетинговий термін “штучний інтелект”. Його використовують технологічні компанії, щоб розкрутити свої ледь функціонуючі продукти. Крім того, так вони можуть підняти ціну своїх акцій.

Розумієте, технологічні компанії живляться хайпом. Але цього недостатньо, щоб бути прибутковими. В технологічному секторі ви повинні переконати інвесторів, що у вас є передова проривна технологія, яка дозволить вам домінувати в цілій галузі, як це зробили Google з пошуком, Apple з iPhone та Amazon, змушуючи працівників мочитися в пляшки й забезпечувати вам надприбутки.

Але тепер, коли всі ці низько висячі плоди зірвані з дерева інновацій, технологічні компанії почали вигадувати нові слова, які, як вони стверджують, “революціонують” усе, в надії прокласти собі шлях до грошенят інвесторів. Чули такі слова як метаверс, доповнена реальність, Web3, і, звичайно, крипта?

Минулого року кожна компанія намагалася перейти на блокчейн, але тепер, коли Бенкман-Фрід (Bankman-Fried) був викритий як банківський шахрай (bankman fraud) і повернув крипту назад у крипто, їм потрібен нова гарячиа тема, і це штучний інтелект.

Тож, у відчайдушній спробі підвищити ціни своїх акцій компанії від Snapchat до Spotify і BuzzFeed заявляють, що збираються впроваджувати штучний інтелект у свої продукти.

А може, далі вони запрограмують штучний інтелект і для читання BuzzFeed. Це значно полегшало б нам життя.

Зараз більшість з цього хайпу — це просто собаче лайно.

Spotify щойно випустив ШІ-діджея, який створить персоналізовану радіостанцію саме для вас.

Ого, дуже потужно, за винятком того, що Spotify вже, курва, саме цим і займається (персоналізовані плейлисти). Яка наступна функція? ШІ-регулятор гучності?!

Не можна просто випустити щось, що вже існує, і назвати це штучним інтелектом.

Насправді це не перший випадок, коли технологічна індустрія перетворює нас на піддослідних кроликів.

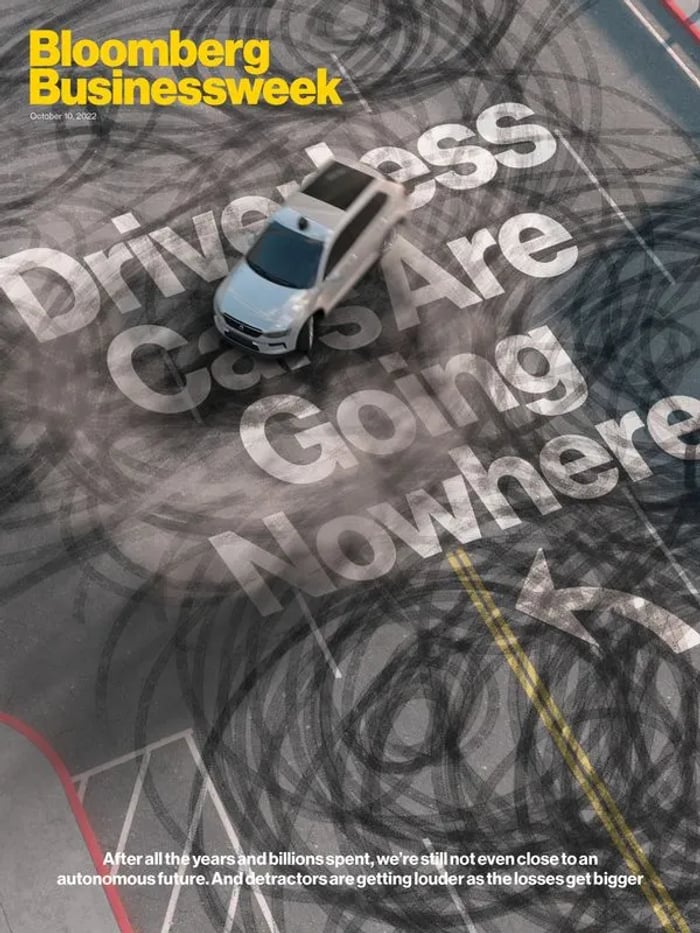

Пам’ятаєте безпілотні автомобілі?

Багато років такі компанії, як Google, Uber і Tesla, говорили інвесторам, що ось-ось вони замінять 228 мільйонів ліцензованих водіїв у США на автопілот зі штучним інтелектом. Чорт забирай, Ілон пророкує, що Tesla буде повністю самокерованою наступного року ще з довбаного 2014 року!

Ці компанії успішно зробили технологію настільки неминучою, що багато штатів дозволили безпілотним автомобілям користуватися дорогами, якими їздять реальні люди. І до чого це призвело?

Після багатьох років невиконаних обіцянок і 100 мільярдів доларів, витрачених даремно, майже всі нарешті погодилися, що безпілотні автомобілі просто не працюють.

Але правда в тому, що вони ніколи не працювали. Це завжди було брехнею.

Наразі Міністерство юстиції США веде кримінальне розслідування проти компанії Tesla, оскільки з’ясувалося, що відеоролики, які вони зняли для просування своєї функції самокерованого водіння, були буквально підроблені. Вони також неправдиво рекламували свої автомобілі як такі, що мають автопілот і повне самокероване водіння. А оскільки світ сповнений довірливих симулянтів, які вірять кожному смердючому слову, що вилітає з рота Ілона Маска, це надихнуло деяких водіїв прибрати руки з керма і їхати, як Люк Скайвокер, по I-95 (траса в США).

В результаті гинуть люди. Минулого року самокеровані автомобілі Tesla вбили 10 людей лише за чотири місяці, і, можливо, саме тому уряд змусив їх відкликати 300 000 автомобілів.

Навіть люди з технологічної індустрії починають усвідомлювати, що існують певні речі, які комп’ютери просто фундаментально не здатні робити так само добре, як люди.

Люди неймовірно добре сприймають нові стимули, з якими ми ніколи раніше не стикалися, міркують про те, хто за них відповідальний і чому, а потім прогнозують, що станеться далі.

Якби вас зупинили на пішохідному переході в Лос-Анджелесі, бо, скажімо, Джеймс Кордон перегородив дорогу і танцював дурнуватий танець у костюмі миші, ви б поєднали свої знання про дратівливу попкультуру з розумінням людської природи й дивного видовища перед вами та зробили б висновок, “О, схоже, я опинився в центрі якогось жахливого вірального пранку для вечірнього ток-шоу, і я нічого не можу вдіяти, окрім як зціпити зуби та чекати, поки це скінчиться”.

Але ваш безпілотний автомобіль не бачив “Late Late Show”. Він навіть не дивиться Колберта! Тож він може вирішити, що це миша, натиснути на газ і розчавити цього виродка! І знаєте, це був би найсмішніший момент шоу, але ми б не назвали таку поведінку розумною.

Багато технологій безпілотного водіння дійсно дуже круті, і вони мають важливе застосування в реальному світі, наприклад, запобігання зіткненням і покращений круїз-контроль. Але думка про те, що ми всі будемо сидіти на задньому сидінні з май-таєм, поки наше роботаксі везе нас на роботу, завжди була вигадкою з розряду наукової фантастики.

І коли такі компанії, як Tesla, говорили нам, що це станеться, це була брехня. Брехня, сказана для того, щоб підвищити ціну своїх акцій і обдурити нас, щоб ми робили те, що їм потрібно, щоб змінити наші закони, щоб дозволити їх неперевірену - в багатьох випадках шахрайську технологію - використовувати на дорогах загального користування, де вона завдавала шкоди та вбивала людей.

І той самий цикл повторюється. Великі технологічні компанії роблять нас піддослідними кроликами для своїх шматків лайна, що ледь функціонують. Тільки цього разу вони називають це “генеративним штучним інтелектом”.

Отже, пошукові системи Google і Microsoft руйнуються. Google з кожним роком стає все гіршим, перетворюючись з того, що раніше було корисним інструментом, на вигрібну яму реклами та SEO-спаму.

А Bing — це, ну, Bing. У мене навіть немає жартів на цю тему. Назва говорить сама за себе. Якщо ви скажете людям, що ви щось “бінгали”, вони буквально розсміються вам в очі.

Тому, прагнучи вирватися вперед, Microsoft вклала понад 10 мільярдів доларів у ChatGPT, чат-бота зі штучним інтелектом, який дає шокуюче зв’язні відповіді на запитання, поставлені йому природною мовою.

Я не буду детально пояснювати, як працюють моделі машинного навчання, такі як ChatGPT. Якщо вам дійсно цікаво — почитайте ось тут.

Але якщо коротко, то якщо ви подаєте одній з цих моделей велику структуровану колекцію символів, наприклад, текст, зображення або кадри відео, вона може видати аналогічну структуровану колекцію, використовуючи ймовірність, щоб визначити, яке слово, піксель або кадр відео, найімовірніше, буде наступним, на основі всіх навчальних даних, які вона отримала.

Іншими словами, це неймовірно складна система імітації. Якщо ви дасте мовній моделі всі історії про Шерлока Голмса, які коли-небудь були написані, вона зможе виводити нові тексти, які нагадуватимуть історії про Шерлока Голмса. Якщо ви дасте їй кожен фрагмент тексту з інтернету, вона може видати текст, схожий на будь-який фрагмент тексту, який ви можете знайти в інтернеті. Вона навіть може змішати два різні тексти та створити новий, що нагадуватиме обидва.

Ви хочете прочитати гостросюжетний роман, де Шерлок Голмс закохується в короля Купу (King Koopa з Братів Маріо)? Що ж, ChatGPT може створити його для вас. Ви відмінний збоченець!

Це дійсно круто, і це робить моделі машинного навчання дійсно цікавими для розваг та дуже корисними для людей, яким потрібно генерувати великі обсяги даних на основі шаблонів, наприклад, для програмістів, аудіотранскрибаторів і… спамерів.

Так, ці речі здебільшого зроблять революцію в спамі! Обережно, той нігерійський принц збирається здобути ступінь філолога!

Знаєте, чим не є ChatGPT? Довбаною пошуковою системою! Але у відчайдушній спробі осідлати хвилю хайпу, Microsoft запхала його в Bing, вдаючи, що ця химерна мавпочка за друкарською машинкою може якимось хріном надавати фактичні відповіді на реальні запитання реальних людей. І результати виявилися поганими.

Навіть презентаційне відео, яке Microsoft використовувала для реклами своєї нової пошукової системи зі штучним інтелектом, було сповнене помилок. У їхньому власному відео стверджувалося, що у відомого бренду бездротового пилососа занадто короткий шнур. На запит про відгуки про вигаданий бар в Мехіко він стверджував, що той користується популярністю серед молоді. А на досить просте для пошукової системи запитання про те, коли йде “Аватар 2”, Bing відповів користувачеві, що його прем’єра ще не відбулася, бо на дворі ще 2022 рік.

Ви можете подумати, що Google, одна з найприбутковіших компаній у світі та буквальний монополіст пошукових систем, подивиться на це палаюче лайно і розсміється, але ніт! Замість цього вони сказали: “От дідько, ми повинні швидко винайти своє власне лайно. Швидше! Хтось, насріть мені в руки!”

Google негайно випустив власну пошукову систему зі штучним інтелектом. Запуск був настільки катастрофічним, що навіть співробітники Google назвали його лажею.

Я гадки не маю, якого біса Microsoft і Google думають, що ви можете використовувати мовну модель ШІ як заміну пошукової системи, адже очевидно, що вона не підходять для цієї мети.

Розумієте, люди користуються пошуковими системами, щоб знайти фактичну інформацію, знайти конкретні ресурси, до яких їм потрібен доступ, або, у моєму випадку, щоб знайти власне ім’я 200 разів на день.

Але мовні моделі штучного інтелекту не можуть надати вам нічого з цього. Все, що вони роблять, — це передбачають, яке слово, згідно з навчальними даними, найімовірніше, буде наступним. А оскільки їхні навчальні дані — це весь інтернет, це означає, що в них повно усілякого непотребу.

Коли звичайна пошукова система показує вам якусь прутню, ви використовуєте свій людський мозок і кажете, “О, це якась прутня. Не думаю, що я повинен слухати поради про здоров’я від якогось TurdGobbler69. Замість цього я перейду на сайт Клініки Майо.”

Але штучний інтелект так не працює. Він не знає різниці між надійним експертом і упередженим ідіотом, тому що він навіть не знає, що люди існують!

Це просто папуга. Який вибирає слова, які він чув раніше. Тож коли в його навчальних даних є якесь лайно, він вивергає це лайно назад на вас і стверджує, що це правда.

Ось в чому справжня проблема: оскільки ці компанії рекламують свої ШІ як надточні оракули досконалих знань, багато людей в це, курва, вірять. Наприклад, компанія OpenCage завалена електронними листами від розлючених клієнтів, які стверджують, що ChatGPT сказала їм, що та випускає продукцію, якої не існує.

І коли ви запитуєте у ChatGPT факти про мене, вона буквально каже вам, що я продюсер “Сімпсонів”. Моя власна мама звинувачує мене в тому, що мульт став відстійним!

Так чому ж люди вірять у цю патентовану маячню?

Все просто: той факт, що ChahtGPT може давати, здавалося б, зв’язні відповіді, покликаний запевнити нас в тому, що він може більше, ніж насправді, навіть що він наближається до рівня людського інтелекту.

Минулого місяця найбільш довірливий технічний репортер “Нью-Йорк Таймс” Кевін Руз (Kevin Roose) опублікував стенограму розмови з Бінгом, заявивши, що чат зі штучним інтелектом Бінга розкриває свої почуття. Кевіне, у Бінга немає почуттів. Бінг навіть не знає, що ти тут, друже. Це просто алгоритм, який передбачає, яке слово буде наступним у реченні. Це автодоповнення.

Це довбаний Т9!

Але Кевін такий: “Воно знає, що я намагаюся написати листа. Воно закохане в мене.”

Але нам усім слід трохи поблажливіше ставитися до Кевіна, адже він припускається найбільш природної помилки, і дослідники ШІ знають про це вже багато років.

У відомій статті “Про небезпеку стохастичних папуг” дослідники ШІ Емілі Бендер (Emily Bender), Тімніт Гебру (Timnit Gebru) та їхні співавтори передбачили саме такий феномен.

Якщо ми бачимо рядок слів, які мають граматичний сенс, ми природно шукаємо і знаходимо в ньому значення, і ми природно схильні припускати, що за цим стоїть розум, подібний до нашого, навіть якщо все, на що ми дивимося, — це словесна каша, яку виблював “імовірнісний” папуга.

Як пишуть дослідники, “схильність співрозмовників знаходити сенс там, де його немає, може ввести в оману як дослідників, так і громадськість, змушуючи сприймати синтетичний текст як осмислений”. А це робить мовні моделі небезпечними, бо означає, що ми природно довіряємо тому, що вони видають.

Потенційна шкода від цього величезна. Зловмисники можуть використовувати їх, щоб генерувати гори правдоподібної дезінформації, а расистські упередження в навчальних даних можуть бути широко поширені й посилені, тому що ШІ вважатиме їх правдивими.

І, так само як бідолашний Кевін Руз, люди можуть бути обдурені, думаючи, що мовна модель спілкується з ними, хоча насправді вона навіть не знає про їхнє існування.

З цих причин Тімніт Гебру та її колеги закликали свою галузь визнати, що застосунки, які мають на меті правдоподібно імітувати людину, несуть ризик надзвичайної шкоди, і закликали провести більше досліджень, перш ніж випускати їх у світ.

Це було у 2021 році, і коли Гебру та її колеги писали цю статтю, вона працювала в Google у відділі етики ШІ, що здається ідеальним, чи не так? Адже саме для цього її найняли. Тож вони, напевно, взяли її застереження до серця, пригальмували свою програму ШІ та ретельно дослідили її наслідки?

Ніт, вони цього не зробили. Замість цього вони її звільнили! Вони сказали: “Ти робила свою роботу надто добре, і нам не подобається те, що ти сказала. Пакуй свої манатки”.

Це все одно, що звільнити синоптика, бо ви незадоволені тим, що насувається ураган. “Пішов ти зі своєю п’ятою категорією, Карле, я власник цієї метеостанції і я хочу вийти в море на своєму човні!”

А всього кілька тижнів тому Microsoft звільнила власну команду з питань етики ШІ, і тепер обидві компанії тиснуть на газ. Накачують проєкти штучним інтелектом так швидко, як тільки можуть, дарма що хтось від цього постраждає.

Хіба це не смішно?

Щоразу, коли ви чуєте балаканину технологічних титанів про небезпеку ШІ, вони завжди говорять про науково-фантастичну версію, де ШІ стає свідомим і захоплює світ. Але все це нагнітання страху — просто маркетинг.

Я б назвав це — маркетингом страху.

Ця моторошна науково-фантастична історія покликана привернути увагу заголовків ЗМІ і відвернути нас від реальної небезпеки ШІ, яка полягає в тому, що реальні люди в Кремнієвій долині використовують його для того, щоб трахнути нас усіх прямо зараз. Ось жорстока правда.

Навіть назва цієї технології — брехня. Якщо ви хоч трохи підколупнете будь-який з цих так званих штучних інтелектів, ви побачите, що за роботою системи стоять люди, яким недоплачують, яких експлуатують, яких обкрадають.

Нещодавнє розслідування журналу “Time” виявило, що для того, щоб утримувати весь інтернет-бруд і осад у ChatGPT і DALL-E, OpenAI змушує кенійських працівників відсіювати токсичний контент, визначаючи, які фрагменти є надто жорстокими, відверто сексуальними або тривожними, щоб використовувати їх у тренувальних даних.

Ці працівники стикаються з графічними сценами насильства, смерті та сексуального насильства, у тому числі над дітьми.

А за це їм платять менше ніж 2 долари на годину!

Чому я повинен турбуватися про те, що ШІ захопить нас, коли люди, які зараз відповідають за це, займаються таким лайном?

Але навіть якщо OpenAI буде платити тим людям справедливу зарплату за таку роботу (п’ять тисяч на годину і безплатну терапію довічно?), це не зробить експлуатацію меншою, тому що вся її бізнес-модель побудована на використанні безоплатної праці буквально мільйонів людей.

Пам’ятайте, що так званий генеративний ШІ, такий як ChatGPT і DALL-E, насправді слід називати імітаційним ШІ. Вони можуть виводити будь-який текст або зображення, якщо їм надається величезна кількість навчальних даних для копіювання.

І знаєте, звідки ці дані беруться? Від людей, хай їм дідько!

Ви хочете, щоб DALL-E створив вам зображення мене без сорочки, який їсть шматок піци в стилі аніме-художника з DeviantArt? Що ж, він може це зробити, але тільки тому, що копіює реальні роботи мільйонів реальних художників.

Не кажучи вже про тисячі моїх реальних фотографій!

І коли ви заходите в ChatGPT і генеруєте сценарій для епізоду “Адам руйнує все”, ви отримуєте результат, який дуже схожий на моє старе шоу.

Чому? Чи це якийсь суперрозумний штучний інтелект придумав оточення, персонажа, якого я граю, і теми, які я обираю для висвітлення? Ні, це був я!

А потім якийсь вилупок з Пало-Альто написав алгоритм, який списує мою роботу і згодовує її мені назад. Це не штучний інтелект. Це мій інтелект!

І коли я використовую свій ніжно-рожевий мозок, мені зазвичай подобається, коли мені за це платять, бо так я можу дозволити собі їжу, яка підтримує його роботу.

Компанії, які розробляють штучний інтелект, можуть стверджувати, що все це є доброчесним використанням, а отже, законним - це просто як ремікс, друзі!

Але творці з цим не згодні, і тому вони зібралися разом, щоб подати на них до суду. І я сподіваюся, що вони виграють.

Тому що правда в тому, що ці програми зі штучним інтелектом в основі своїй побудовані на неоплачуваній праці реальних людей.

І їхня бізнес-модель полягає в тому, щоб підривати роботу людей, використовуючи для цього нашу власну працю. Замість того, щоб прочитати статтю справжнього журналіста, коли у вас є питання, Microsoft хоче, щоб ви використовували Bing, щоб змішати роботу кожного журналіста в Америці з гівняним молочним коктейлем.

Замість того, щоб платити художнику за створення ілюстрацій для вашого веб-сайту, вони хочуть, щоб ви платили DALL-E, застосунку, навченому на зображеннях справжніх художників, не сплачуючи цим художникам жодного цента.

Лише минулого місяця стало відомо, що Apple почала тренувати штучний інтелект на голосах дикторів аудіокниг, не кажучи їм про це, а потім використовувала його для створення нових аудіокниг.

Бачите, нам не потрібно чекати, поки якийсь суперрозумний штучний інтелект знущатиметься з людства. Тім Кук може зробити це сам.

Але я не бачу майбутнього, тож, можливо, я помиляюся. Можливо, одного дня роботи прийдуть за нами. Про це я теж не хвилююся, тому що тепер я знаю, що ми потрібні штучному інтелекту. Він не може зробити жодної речі, не використовуючи нашу людяність як вхідні дані, а це означає, що у нас є перевага.

Розумієте, як би добре ШІ не імітував те, що робили люди в минулому, реальна різниця між нами та машинами полягає в тому, що ми все ще маємо здатність створювати нові речі, про які ніхто ніколи не думав раніше.

Лише минулого місяця найсильніший у світі штучний інтелект, що грає в Го, був переможений гравцем-аматором, який використовував нестандартну стратегію, настільки безглузду, що жодна людина ніколи не пробувала її раніше. Я думаю, якби ви грали в Го, ви б зрозуміли ту досить кумедну позиціяїна дошці. Але оскільки її не було в навчальних даних, ШІ навіть не помітив, що щось відбувається, аж поки не програв.

А ось один з найкращих заголовків, які я коли-небудь читав: “Морські піхотинці обдурили робота DARPA, ховаючись у картонній коробці, хихикаючи й прикидаючись деревами”.

І якщо ви художник і хочете перевершити мистецтво ШІ, ви можете створити щось настільки нове, настільки химерне і прекрасне, що у цього навіть не буде назви, щоб ввести її в чат DALL-E, і ви це точно зробите, тому що це те, чим займаються люди.

Ми створюємо нові речі!

Ми думаємо нові думки!

Ми відкриваємо нові факти про всесвіт!

Це те, що відрізняє нас від інших живих істот, і це те, що відрізняє нас від ШІ.

Який жалюгідний жарт навіть називати те, що ці штуки роблять, інтелектом. Це не людський розум. Воно зовсім не схоже на людський розум.

Ми не просто імітуємо те, що робили в минулому. Ми не просто набір ймовірностей на жорсткому диску. Людський мозок розвивався мільйони років, і він настільки складний, що ми навіть не розуміємо, як він працює.

І ми використовуємо цю дивовижну м’ясну машину в нашому черепі, щоб спостерігати за навколишнім світом. Ми міркуємо про те, чому він є таким, яким є.

Ми спілкуємося з іншими умами про те, що ми дізналися, і створюємо нові речі з цими знаннями.

І ми використали це для створення ChatGPT, алгоритму, який може писати гівняну фан-фікшн.

Що ж, дивний вибір, але, гадаю, нам на руку. Це дуже круто. Але зробімо крок назустріч людству і використаємо наш м’який пухкий людський мозок для того, щоб зробити ще одну річ, яку не може тупий алгоритм Кремнієвої долини.

Використаймо його, щоб відрізняти правду від брехні, і перестанемо вірити в їхню маячню!

Щиро дякую вам за те, що ви це прочитали.

Якщо ви хочете підтримати Адама, то лайкніть його відео або задонатьте на Патреоні,

Сподобалась публікація? Дуже на це сподіваюсь, адже автор відшукував матеріал, перекладав, редагував та адаптував його для того, щоб читання приносило не лише задоволення, але й було корисним. Можете підтримати його донатом. Навіть 1 гривня принесе радість!