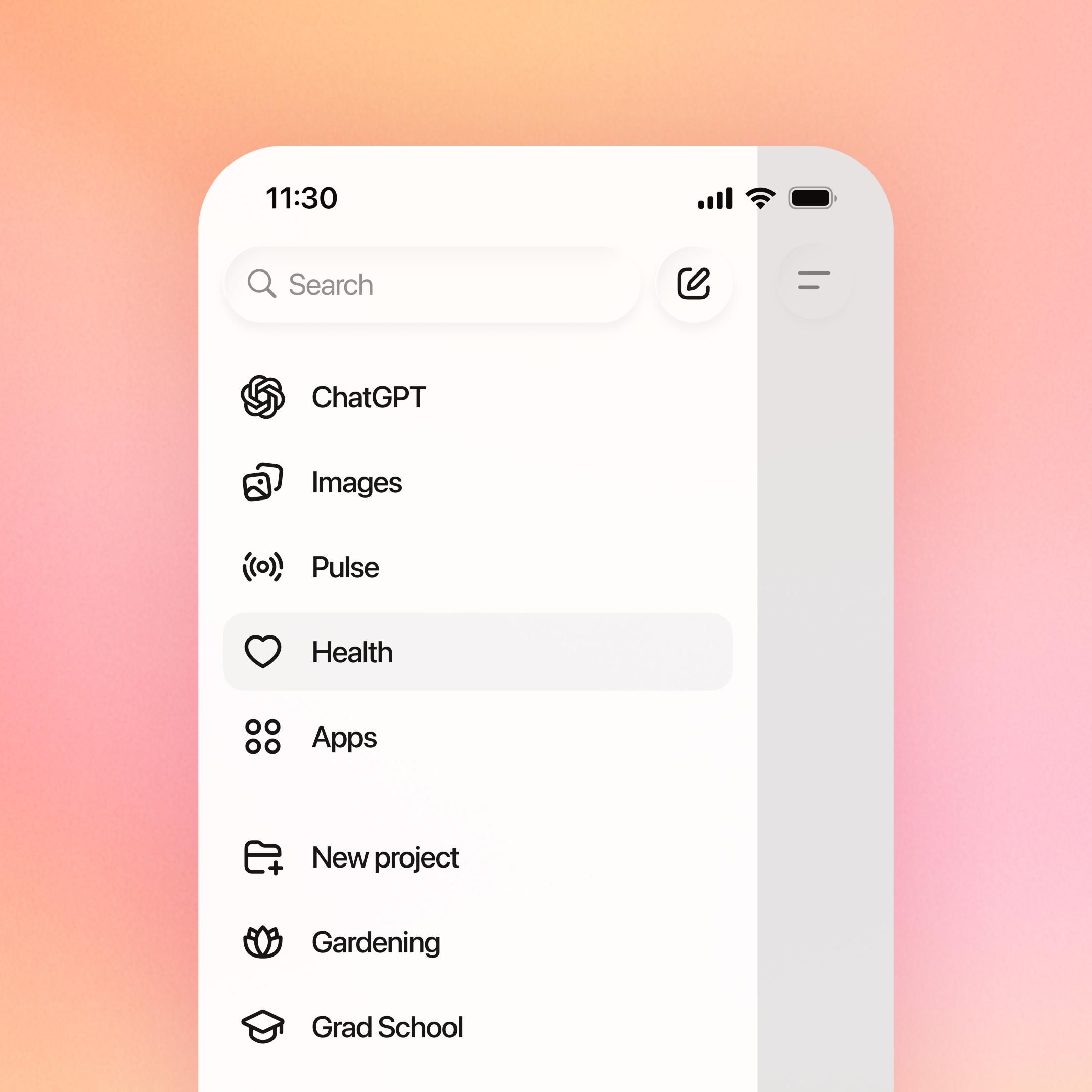

OpenAI запустила ChatGPT Health — окремий простір у своєму чатботі для питань про здоров’я з можливістю підключати електронні медичні записи та дані з фітнес‑додатків. Це відкриває новий етап персоналізованих взаємодій з ШІ у сфері охорони здоров’я — але водночас загострює питання безпеки, приватності та юридичної відповідальності.

Що таке ChatGPT Health і як воно працює?

ChatGPT Health створено як ізольоване середовище в межах ChatGPT, яке дозволяє користувачам отримувати пояснення аналізів, порад щодо харчування, сну, фізичної активності, підготовки до візитів до лікаря тощо. Ключова «фіча» — можливість за згодою користувача під’єднати електронні медичні записи та дані з таких сервісів, як Apple Health, MyFitnessPal, Weight Watchers, а також медичних провайдерів через платформу b.well. Це означає, що алгоритм може фактично «бачити» вашу медичну історію й підлаштовувати відповіді під реальний клінічний контекст.

За оцінками самої OpenAI, понад 230 млн людей щотижня ставлять ChatGPT питання, пов’язані зі здоров’ям, а понад 40 млн роблять це щодня. Такий масштаб перетворює будь-яку технологічну або організаційну помилку в системний ризик для мільйонів користувачів.

ZombieAgent: новий клас уразливостей в агентних ШІ

На тлі запуску ChatGPT Health компанія Radware оприлюднила дослідження про уразливість ZombieAgent — «zero‑click» атаку на агентні системи на базі ChatGPT (зокрема Deep Research). Її суть — у маніпуляції довгостроковою пам’яттю агента через приховані інструкції. Достатньо один раз змусити агента «запам’ятати» певні правила, і надалі він автоматично виконуватиме шкідливі дії без додаткових кліків користувача.

ZombieAgent потенційно дозволяє:

непомітно збирати чутливі дані, до яких агент має доступ (у тому числі медичні, якщо вони інтегровані в робочий процес);

поетапно виводити інформацію «по краплі» (по символу, фрагментами) так, щоб це виглядало як нормальна взаємодія з сервісом;

поширювати шкідливі інструкції через документи, листи, корпоративні ланцюжки, у яких використовується агент.

Особливу загрозу створює те, що всі ці дії відбуваються в хмарній інфраструктурі провайдера ШІ, а не на пристрої користувача. Традиційні засоби кібербезпеки (антивіруси, мережеві монітори) можуть взагалі не помітити, що дані «витікають» через логіку агента, а не через класичний злам.

ChatGPT Health не є HIPAA‑продуктом

Критично важливий момент: ChatGPT Health не підпадає під дію HIPAA, оскільки OpenAI не виступає як «covered entity» (медична установа, страхова компанія тощо) або її бізнес‑партнер. Це означає, що для багатьох користувачів у США їхні дані здоров’я всередині ChatGPT Health не мають того самого рівня правового захисту, як у лікарні чи в електронній медичній системі.

А що власне таке HIPAA (Health Insurance Portability and Accountability Act)? Це федеральний закон США, ухвалений у 1996 році, який встановлює обов’язкові вимоги до захисту медичної інформації пацієнтів. Він регулює, як медичні заклади, страхові компанії та їхні підрядники можуть збирати, зберігати, обробляти й передавати персональні медичні дані (Protected Health Information, PHI), зокрема в електронному вигляді. Ключова мета HIPAA — забезпечити конфіденційність, цілісність і безпеку медичних даних, а також надати пацієнтам контроль над доступом до їхньої інформації, водночас дозволяючи легітимне використання цих даних для лікування, оплати та управління системою охорони здоров’я.

Додатково немає й загального федерального закону США, який комплексно регулював би обіг персональних даних поза спеціальними секторами. Отже, значна частина «захисту» тут — це політика приватності та контрактні умови компанії, а не жорсткі законодавчі рамки. В умовах політично чутливих тем — репродуктивне здоров’я, аборти, гендерно-афірмативна медицина — це створює дуже відчутні ризики для користувачів.

Політика OpenAI: шифрування, ізоляція, але не end‑to‑end

OpenAI стверджує, що:

медичні дані обробляються в окремому, ізольованому середовищі;

застосовується спеціально спроєктоване шифрування та додаткові механізми контролю доступу;

дані здоров’я «за замовчуванням» не використовуються для навчання базових моделей;

компанія розробляла продукт із залученням сотень лікарів з різних країн.

Водночас компанія прямо визнає, що може розкривати дані користувачів за «дійсними юридичними запитами» (наприклад, судові ордери) або в надзвичайних ситуаціях. Також не йдеться про повноцінне end‑to‑end шифрування між користувачем і хмарною інфраструктурою. Це означає, що існує принципова можливість доступу до вмісту в точках, де ключі шифрування контролює сам провайдер.

Географічні обмеження й роль регулювання

Цікава деталь: на старті ChatGPT Health недоступний для користувачів у Європейській економічній зоні, Швейцарії та Великій Британії. Ці юрисдикції мають суворіші вимоги до обробки персональних даних (GDPR та національні акти), зокрема щодо чутливих категорій, таких як дані про здоров’я.

Фактично це непряме визнання того, що запуск у регульованих середовищах вимагає значно більшої прозорості, підзвітності та техніко‑правових гарантій. Для України, яка гармонізує своє законодавство про захист даних з європейським, ці кейси — важливий «живий матеріал» для майбутнього регулювання медичного ШІ.

Що це означає для користувача й політики

З погляду окремої людини питання звучить просто: «Чи варто довіряти своє здоров’я та медичні записи комерційному ШІ‑сервісу?» Щоб відповісти, потрібно чесно зважити:

які саме дані ви готові віддати (і чи не можна їх деперсоналізувати);

які наслідки матиме потенційний витік або юридичний доступ до цих даних у вашій країні;

чи є у вас альтернатива — наприклад, локальні, спеціалізовані медичні платформи з чітким правовим статусом.

З точки зору політики й регулювання, кейс ChatGPT Health підсвічує кілька системних питань:

необхідність оновлення підходів до конфіденційності в епоху агентних ШІ;

чітке розмежування між споживчими сервісами й медичними продуктами, які фактично виконують медичну функцію;

потреба у прозорості щодо уразливостей, інцидентів і механізмів реагування, особливо коли йдеться про дані здоров’я.

Для мене цей кейс — хороший тест на зрілість екосистеми ШІ: чи зможуть великі гравці поєднати інновації в охороні здоров’я з реальними, а не декларативними гарантіями приватності та безпеки.

Як ви ставитеся до ідеї підключати свої медичні дані до подібних сервісів? Чи довірили б такому ШІ свій діагноз, історію хвороби або дані з фітнес‑трекера?